筑波大学は5月22日、AIの画像認識技術において、それぞれの最適な適用割合を自動的に発見するアルゴリズムを開発し、画像認識のために利用する「畳み込みニューラルネットワーク」(CNN)のサイズを従来より28倍も小さく圧縮、また削減割合を発見する速度も従来の76倍にまで高速化できたことを発表した。

同成果は、筑波大学 システム情報系の山際伸一准教授らの研究チームによるもの。詳細は、IEEEが関心を寄せるすべての分野を扱う学際的な学術誌「IEEE Access」に掲載された。

深層学習のうち、コンピュータに画像を見たり認識させたりする機能を持たせるのに使われているのがCNNで、視覚にあたる「畳み込み」部分と、画像の種類を推論する「全結合」部分で構成される。

畳み込み部分は、人間の視覚が行っている特徴量の認識のような役目を担い、画像の複数の画素から要約された画素情報を作成する(畳み込み演算)。その情報が全結合部分に送られ、そこでは脳でニューロンが相互に異なる強度の神経のつながりを持つ仕組みを模倣した構成となっており、そのつながりの強度が「重み」と呼ばれる。重みを入力の画像に対し、正しく認識するように数値を合わせ込む計算の過程が「学習」であり、結果を予測しながら合わせ込む計算により設定が行われている。このような仕組みのため、精度の高い学習を行うには、畳み込みや重みの表現に高精細な数値表現、つまり多くのビット数が必要となる。そのため、AIは電力消費量の増大が課題とされている。

AIの学習には、計算に莫大な時間がかかるため、可能な限り少ない時間でCNNの重みの設定を行えることが鍵となる。そこで現在のCNNでは、達成したい推論精度(画像の認識精度)を維持したまま、より少ない畳み込み演算、重み、数値表現でも実現できる、「Network Slimming」(NS)、「Deep Compression」(DC)、「Integer Quantization」(IQ)といった手法が提案されており、それらは組み合わせて利用することが可能。

しかしその3手法をCNNに適用し、大きさを圧縮しようとする場合、その3種類をどの順番で使うのかに加え、それぞれの手法にどの程度の削減割合を与えるかについての明確な適用方法の指標がないことが課題となっていた。そのため、現在は総当たりで最小構造を求めるしかなく、結局は莫大な学習計算が必要となっていたのである。そこで研究チームは今回、物体カラー画像データセット「CIFAR10」を使い、NS、DC、IQの適用順序の解明を目指すことにしたという。

まず順序に関しては、先行研究により、NS→DCという順序が有効なことが解明されていたため、IQの挿入位置が実験的に求められた。その結果、IQ→NS→DCが、最も効率的にCNNを最小化できることが判明。また、それぞれの削減手法の割合を最小化できたところで、その少し前の冗長性が残った段階に引き戻しながら、次の手法を適用していく「マージン計算法」が提案され、CNN構造を最小化するアルゴリズムを開発することに成功したという。圧縮の結果、従来法と比べて、28倍も小さくできたことが確認されたほか、その縮小効果を実現する削減割合を発見する速度は、総当たりの従来法に比べ、76倍の高速化が達成されたとした。

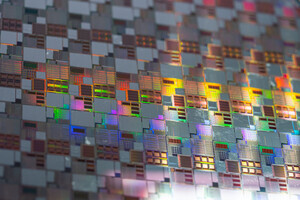

画像認識AIが必要な監視カメラや自動運転車など、社会のエッジデバイスにCNN構造をハードウェア実装する際、今回の研究成果を応用すれば、増大化しているAIの消費電力量を抑え、より少ないハードウェア量で実現できるようになることから、エッジ・コンピューティング技術への一助となることが考えられるとしている。また研究チームは今後、今回の研究成果を活かし、CNNを半導体チップにデジタルハードウェアとして実装するなどし、資源量や消費電力量の削減効果を調べていくとしている。