米NVIDIAは2月13日(現地時間)、技術デモとして「Chat with RTX」をリリースした。NVIDIA RTXを搭載したWindows PCのローカル環境で、AIチャットボットを使用可能にするツールである。要件は、GeForce RTX 30シリーズまたは40シリーズ(8GB以上のVRAM)、16GB以上のRAM、535.11以降のドライバーなど。

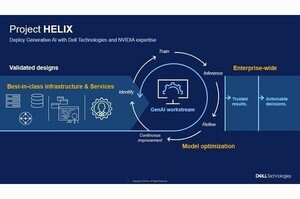

ChatGPTやGoogleのGeminiのようなクラウドベースのAIチャットサービスは、データセンターの強大な処理能力を活用する利点があるが、使用にはインターネットアクセスが必要であり、またユーザーがデータ管理を行えないため、セキュリティやプライバシーに関する懸念が残る。一方、ローカル環境のAIチャットボットは、機能へのアクセスが容易であり、ユーザーが柔軟に選択しカスタマイズできる利点があり、そしてローカルPC上で機密データを処理することが可能である。

Chat with RTXは、NVIDIAが昨年Windows PC向けに発表した「TensorRT-LLM」と「Retrieval Augmented Generated」(RAG)を用い、RTXアクセラレーションを活用した高速な動作を実現している。

データセットとして、txt、pdf、doc、docx、xmlなど多様なファイル形式をサポートしており、これらのファイルを含むフォルダを指定することで、MistralやLlama 2といったオープンソースの大規模言語モデル(LLM)のデータセットとして使用できるようになる。NVIDIAによると、「TensorRT-LLM v0.6.0」で推論性能が最大5倍向上し、Mistral 7BやNemotron-3 8Bなど対応LLMの追加により、ローカルLLM環境がさらに充実する。

例えば、過去にメモしたレストランを探す場合、「ラスベガスにいる間にパートナーが勧めてくれたレストランは?」と尋ねると、Chat with RTXがローカルファイルをスキャンして指示に合致する回答を提供する。これにより、キーワードを用いてメモを検索していた時間を大幅に短縮できる。よりインテリジェントなファイル検索が可能になる。

YouTubeの動画やプレイリストからの情報も組み込むことができる。動画のURLをChat with RTXに追加すると動画の情報がチャットボットに統合され、文脈に即したクエリを使用できるようになる。例えば、好きなインフルエンサーの動画に基づくおすすめの旅行を尋ねたり、高く評価された教育リソースに基づくチュートリアルやハウツーを得ることが可能になる。

Chat with RTXは、GitHubから入手できるTensorRT-LLM RAG開発者リファレンス・プロジェクトから構築されており、開発者はそのリファレンスを使用して、RTX用の独自のRAGベースのアプリケーションを開発してデプロイできる。