日本CTO協会はこのほど、CTO(Chief Technology Officer:最高技術責任者)やソフトウェア開発者向けのイベント「Developer eXperience Day 2023」を開催した。本稿では同イベントから、東京大学の松尾豊教授が語ったLLM(Large Language Models:大規模言語モデル)の仕組みと、これからの可能性についての基調講演の模様をお届けしたい。

ChatGPTを生み出した2つのブレークスルー

LLMはディープラーニング技術を用いて構築される言語モデルで、多量のデータを使って学習しており、パラメータ数も膨大だ。有名なものだと、OpenAIのGPT-4やGoogleのPaLM、MetaのLLaMAなどが知られ、最近よく目にする「ChatGPT」にもこの技術が応用されている。

LLMの発展に関してブレークスルーとなったのが、「Transformer(トランスフォーマー)」と「自己教師あり学習」だろう。トランスフォーマーは論文「Attention is all you need」(L.kaiser et al, 2017)によって一躍有名となった手法で、Attention(自己注意機構)をニューラルネットワーク中のどの情報に使うのかを学習可能な仕組みである。

トランスフォーマーによって、自然言語の文中の距離が遠い単語同士の関係性も扱えるようになったことで、「これ」「あれ」と言った指示代名詞の従属関係や、トピックのつながりの依存関係についても柔軟な挙動が可能となった。

もう一方の自己教師あり学習は「next-token-prediction」とも呼ばれるように、途中までの文章から次のトークン(単語)を予測可能な手法だ。この手法を使って事前に学習しておくことで、次に高頻度で来る単語を予測できるようになる。これにより、継続的なダウンストリームのタスクにおいて少ないサンプルからでも高い精度を実現している。

また、ディープラーニングにおいては「スケール則(scaling law)」という法則が知られている。これは、計算機の性能、データ量、パラメータ数のいずれを増やしても、それに比例して頭打ちにならずに精度も上昇するという法則だ。

以前は「過剰適合を防ぐために適切なパラメータ数を設定する必要がある」とされていたのだが、トランスフォーマーと自己教師あり学習の登場によって従来のパラダイムが覆されたような状況である。データ数やパラメータ数に比例してモデルの精度が向上することが明らかになったために、より大きなモデルを作成するための競争が起こっているのだという。ちなみに、GPT-3は1750億のパラメータを持ち、学習に数億~数十億円規模のコストがかかっているそうだ。

ChatGPTは何がすごかったのか? - 流行の背景

現在無償で公開されているChatGPTは、GPT-3またはその後継のGPT-3.5をベースに開発されている。従来の自然言語モデルと比較しても高度な会話(チャット)が可能だ。ChatGPTは、以下の3つのステップで学習している。

それは、あるプロンプトとそれに対応する回答のデータセットを人間が用意する「教師あり学習」、プロンプトに対する回答の中で良いものを人間が順位付けする「報酬モデルの学習」、モデルの回答に対する報酬値を推計して最大化するようフィードバックする「強化学習」の3つのステップだ。

ChatGPT以前にも複数の対話型AIは開発されているのだが、それらの多くはユーザーからの発現も学習データとして取り込み可能な仕組みであり、ユーザーが"わざと"差別的な発言や不適切な発言を学習させることで、AIが人にとって好ましくないテキストを出力してしまう課題があった。

一方でChatGPTは人間が明示的にアウトプットを評価し、さらに報酬を最大化するよう強化学習を実行するため、人に好ましくない出力を実行しづらい特徴がある。

従来の対話型AIは、人間が作成したオリジナルのアウトプットに対する修正などが可能だった。しかしChatGPTは、文章の添削や校正だけでなく、アウトプットを作り出す段階から支援する。さらには、翻訳や、アイデアの提案、プログラミングのソースコード生成など幅広い業務に応用可能な強みを持つ。

松尾氏は「ChatGPTをはじめとする生成AIの登場によって、既存のツールの使われ方に大きな変化が生まれるだろう」と指摘していた。Microsoftは同社のOffice製品に生成AIを搭載する方針を示しており、今後はPowerpointでの資料作成などがより高度に自動化されると予想できる。同氏は「ホワイトカラーの仕事のほとんどすべてに影響があるだろう」とも指摘している。

ChatGPTは公開から約1週間で100万ユーザーを獲得し、2カ月後には1憶ユーザーまで拡大している。もはや社会現象とも呼べるほどの大きな変革を私たちにもたらした。同サービスは誹謗中傷や差別的な出力をしないよう設計されており、多くの人が利用しても悪影響がないために、ポジティブな活用方法が多数考案されている。

松尾氏は「ChatGPTは技術の蓄積に加えて、新しい使い方を創発するプロセスに多くの人が参加したという経緯が特徴的。その過程で多くの人が『未来が変わる』と確信しており、そして、そのことによって実際に未来が変わっていくだろう」と述べていた。

日本企業がChatGPTを活用する際の戦術

松尾氏を座長として「AI戦略会議」が5月11日に発足すると、同月26日には暫定的な論点整理の結果が公表された。AI戦略会議では、AIの利活用時に懸念されるリスクへの対応や、AIの利用を加速するための構想、AI開発に寄与する計算資源への投資についてが主要な論点となったようだ。

また、文化庁は5月30日にAIと著作権の関係に関する方針を示している。この資料ではAIの開発・学習段階と、生成・利用段階に大別して現状を整理している。基本的には、開発・学習段階においては著作権者の許諾なく著作物を利用可能だ。ただし、必要と認められる場合や著作権者の知益を不当に害する場合は規定の対象とならないので注意が必要。

生成・利用段階においては、AIを利用して生成した画像などを公表したり販売する場合は通常の著作物と同様に、類似性と依拠性によって判断される。著作権者は著作権の侵害として損害賠償請求がや差止請求が可能で、場合によっては刑事罰の対象ともなり得るとのことだ。

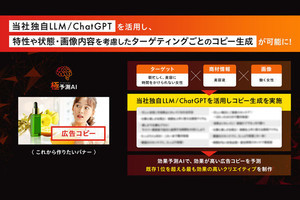

すでにPanasonicやベネッセはChatGPTを業務に活用しており、導入効果も出始めているようだ。さらに、弁護士ドットコムやサイバーエージェントはChatGPTを活用した新たなサービスを公表している。今後ますます多くの業界で活用が進むものと思われる。

LLMはまだまだ黎明期だ。今後いくつもの課題を乗り越えながらさらに良質な技術が出現するだろう。GoogleとDeepMindは5400億ものパラメータを持つ言語モデル「PaLM」をベースに、医療系に特化した「Med-PaLM」を公開した。これは通常のモデルよりも医療タスクに対して高い精度を示す。

このように、今後は業界に特化したバーティカルなLLMも開発が進む可能性があるのだという。一方で、さらに大規模な汎用的モデルが出現すると、そちらの方が高い精度を持つ可能性もある。巨大な1つの汎用LLMとバーティカルなLLMのどちらが今後勝つのかは、各社の戦略的にも気になるところであろうが、識者の間でも意見が分かれているようだ。

「どこにビジネスチャンスがあるのかは分からないので、現状の事業とまったく関係ない事業にもChatGPTをぜひ使ってみてほしい。その中から次の時代のGAFAM(Googlet、Amazon、Facebook、Apple、Microsoftの頭文字)のようなビッグテックが出てくるかもしれない。ぜひ、取り組みの事例やベストプラクティスを発信してもらえたら」(松尾氏)