日本ディープラーニング協会(以下、JDLA)は5月1日、「生成AIの利用ガイドライン」のひな型を公開し、資料の公開に合わせて記者説明会を開催した。最近活躍の場が広がる生成AIの活用を検討する組織が、スムーズにAIを導入できるよう支援する目的があるとのことだ。

「生成AIの利用ガイドライン」をどう使うべきか?

米OpenAIが公開したチャットボット「ChatGPT」をはじめ、プログラムのソースコードを出力する「OpenAI Codex」、画像を出力する「Midjourney」および「Stable Diffusion」など、生成AIの開発は日進月歩で進む。

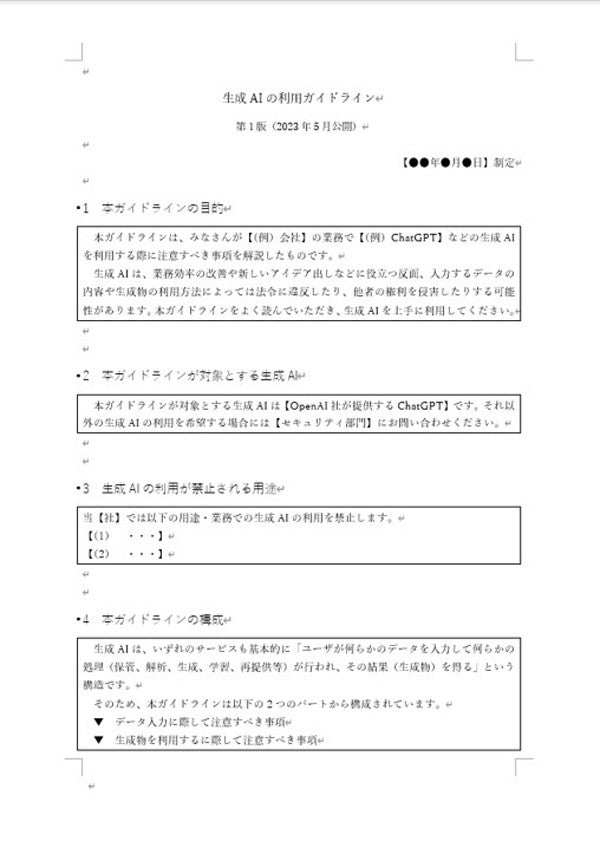

こうした生成AIを企業内や組織内で活用したいと考える場面も多いだろう。今回、JDLAは民間企業や各種組織が生成AIを利用する際に最低限定めておいた方が良いと思われる項目を示し、ガイドラインの作成を支援するためのひな型を公開した。

同協会が公開した資料は、自社名や対象となるサービスなど、必要な箇所を書き換えるだけで使い始められるよう設計されている。なお、あくまで今回公開するのは現段階における生成AIの利活用を想定した第1版であり、今後適時修正を加える予定だ。

生成AIを利用するリスクを検討する際には、「データを入力する場合」と「出力された生成物を利用する場合」の2つの場合について考える必要がある。以下にそれぞれどのような内容に注意すべきかを紹介する。

データを入力する場合に気を付けたいリスク

生成AIにデータを入力する場合は、どのようなサービスを利用するのかによって注意すべきリスクが異なる。言語モデルを例にすると、LLM(Large Language Model:大規模言語モデル)そのものを自社で運用する場合、ChatGPTのようにLLMを用いたサービスを利用する場合、ChatGPTのAPI(Application Programming Interface)を使った外部事業者の独自サービスを利用する場合などが想定される。

当然、どういったサービスを利用するのかで考えられるリスクが異なるため、ガイドラインを作成する際には、第一歩として利用したいサービスがどのようなシステム構成であるかを理解する必要がある。

国内においては、機械学習を目的に著作物のデータを入力する場合には著作権の侵害に該当しないが、生成されたデータが既存の著作物に類似する場合には、著作権の侵害に該当する可能性もあるので注意が必要だ。

その他、ChatGPTでは入力したデータがOpenAIのモデルの学習に利用されるため、個人情報を入力する場合には本人の同意が必要となる。しかし、対話履歴をオフに設定することで、データを学習に使われないよう管理できる場合もある。また、OpenAIのAPIやオプトアウト利用など、場合によっては個人情報の規制をクリアできる例もあるので、やはり個別のリスク確認が求められる。

自社のガイドラインを作成する際には、データが利用したいサービスでどのように扱われるのかを知ることが重要だ。リスクは当該サービスのポリシーや方針に依存することになるため、都度確認すべきだろう。

出力されたデータを使う際に気を付けたいリスク

生成AIによって出力された生成物を利用するリスクについては、利用する生成AIサービスはあまり関係が無いようだ。ここで考えるべきは、生成物をどのように扱うのかだ。生成物が著作権など知財を侵害しないかを確認し、有効に自社サービスに活用するための方針を定めたい。

松尾豊氏が語る「生成AI活用は日本の最後の切り札」

2022年11月30日にOpenAIが公開したChatGPTは、日ごとに活躍の場を広げている。公開2カ月後には1億ユーザーを突破するなど、その勢いには目を見張るものがある。自社サービスにChatGPTを活用しているほか、ChatGPT有償版の利用料金を補助する企業や、優れた活用事例に賞金を支給する企業もあるようだ。

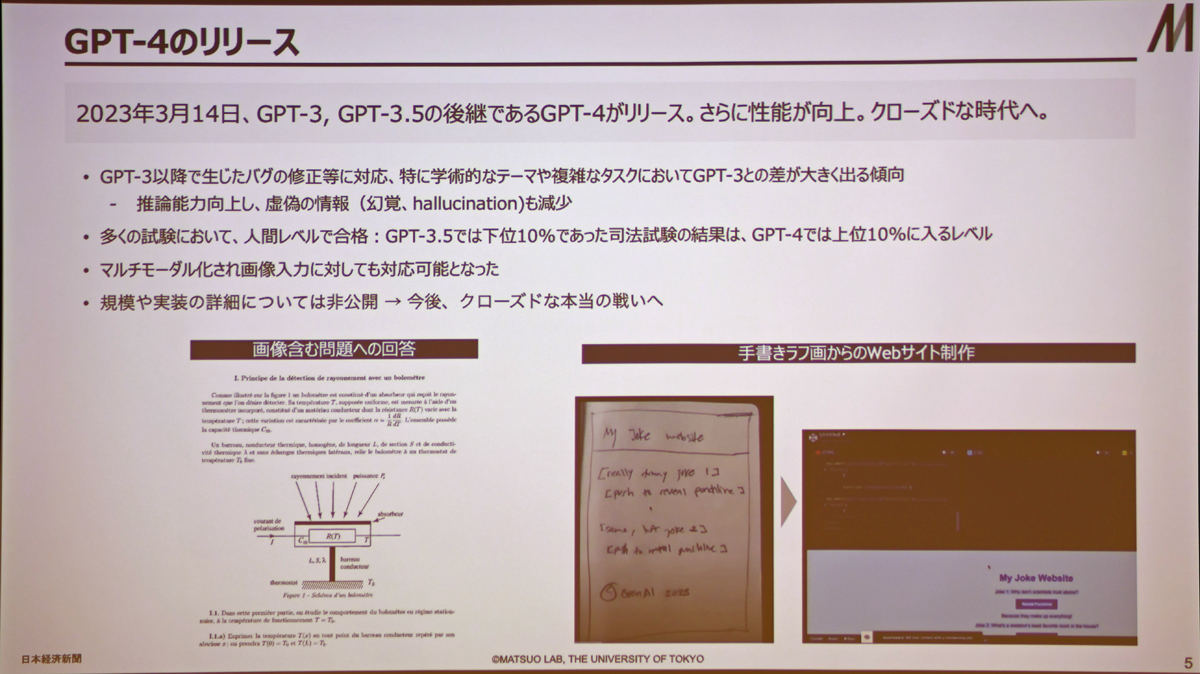

2023年3月には、GPT-3およびGPT-3.5の後継モデルであるGPT-4がリリースされた。GPT-3以降のモデルで生じたバグの修正に対応し、AIが虚偽の情報を出力するHallucination(ハルシネーション:幻覚)も以前より減少している。

学術的なタスクの能力も向上し、GPT-3.5では下位10%であった米国司法試験の結果がGPT-4では上位10%にまで改善した。さらに、マルチモーダル化されたため画像の入力にも対応可能となっている。

また、ChatGPTがメールやチャットツール、API実行などを選んで操作する「LangChain」や、組織内の文書をインデックス化して検索可能にする「Llama Index」など、企業がChatGPTを活用する土台が整いつつある。

こうした中、OpenAIは3月17日に『GPTs are GPTs(GPTはGPT)』のタイトルで論文を発表し、GPTはあくまでGeneral Purpose Technology(汎用目的技術)であるとする旨を示した。トランジスタやインターネットやエンジンのように、大きな産業変革が期待できる数十年に一度の技術だとしている。

さらなる技術革新が待たれる一方で、80%の労働者が、タスクのうち少なくとも10%がChatGPTをはじめとする大規模言語モデルの影響を受けるとする試算もある。そのうち19%の労働者は約50%近いタスクで影響を受けるようになるようだ。特に高賃金の職業や参入障壁が高い業界で大規模言語モデルの影響が大きいと予測されている。

海外ではChatGPTの制限も進む。ニューヨーク州やシアトルでは公立学校で宿題へのChatGPTの利用を禁止している。中国ではChatGPTを禁止しており、Baiduが中国版の対話型AI「文心一言(アーニーボット)」を発表した。イギリスは9億ポンドをスーパーコンピュータに投資し、英国版ChatGPTともいうべき「BritGPT」の開発を進める方針だ。その他、イタリアではChatGPTの使用を一時的に停止し、フランスやドイツでもそれぞれルール作りが急がれている。では、日本ではどうだろうか。

東京大学教授の松尾豊氏は「ChatGPTなどの大規模言語モデルを用いた変革は、日本が逆転するための最後の切り札」と主張する。

ChatGPTの登場により、国内でも多くの人が新時代的なAIとの付き合い方を体験したのではないだろうか。直感的に「この技術はすごい」と感じたはずだ。これほど先進的な技術を使わない手は無い。

しかし、ChatGPTの優れた技術を手放しで享受するのは注意が必要だ。ChatGPTについてよく知り、その上で組織ごとにChatGPTを活用する業務と活用してはいけない業務を定め、適切に運用する必要がある。このような状況を受けて、JDLAはChatGPTをはじめとする生成AIの適切な運用を促す目的でガイドラインのひな型の公開に至ったとのことだ。