eSecurity Planetは4月27日(米国時間)、「ChatGPT Security and Privacy Issues Remain in GPT-4」において、ChatGPTに見られるセキュリティおよびプライバシに関する問題はGPT-4にも引き継がれている可能性があると報じた。ChatGPTだけでなく、GPT-4にも存在するとされている問題が紹介されている。

GPT-4にもChatGPTと同様のセキュリティの問題が存在すると指摘されている。GPT-4はソーシャルエンジニアリングの能力が向上しており、より自然なフィッシングメールや会話を作成できるようになったという。この問題はChatGPTにも引き続き存在し、どちらの人工知能(AI: Artificial Intelligence)チャットボットにおいても攻撃者がランサムウェア、難読化マルウェア、その他のエクスプロイトを作成するようだませると報告している。

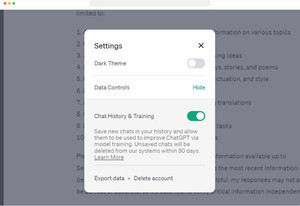

ChatGPTのセキュリティインシデントも取り上げられている。2023年3月にChatGPT Plusの加入者情報の約1.2%にあたるユーザー名やメールアドレス、支払い先などデータの漏洩が発生している。OpenAIの情報漏えい事件で明らかになったソフトウェアのサプライチェーンの問題は一部の組織が直面している普遍的な問題とされ、これらの問題が将来的にどのような影響を与えるかが懸念されている。OpenAIのGPTなどのソフトウェアも、依存関係の混乱やタイポスクワッティング、オープンソース開発者詐称などから被害を受ける可能性があると指摘している。

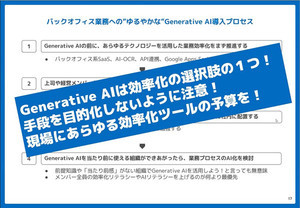

GPT-4への取り組みに対しセキュリティ上の問題を理由に、JPMorgan、Goldman Sachs、Citiなど多くの企業がChatGPTを含むAIツールの利用を制限または禁止している。また、イタリアのような一部の国でも同様の措置がとられている。しかしながら、膨大な量の情報を処理したり、顧客とのインタラクションを改善したり、さらにはコードを書いたりする場合、AIを利用することで得られるメリットは大きいという。

企業はAIモデルが機密情報を漏らしたり公開したりしないようデータ分類の基準を策定することやプロンプトに対して入力できるテキスト量を制限すること、GPT-4 APIを利用する企業は本番で利用する前にコードの検証を独自に行うことなど、潜在的なリスクを軽減するのに役立つアプローチを取ることが重要とされている。