米Intelは現地時間の4月9日、アリゾナ州フェニックスでIntel Vision 2024を開催し、ここでXeon 6とGaudi 3の発表を行った。基調講演の様子はこちらから視聴可能であるが、主な内容について紹介したい。

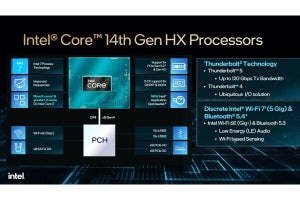

今回のIntel VisionはAIにフォーカスをあてた、と言うよりもほぼAI絡みの話に終始した。同社の"AI Everywhere"戦略はClient/Edge/Data Centerの全ての分野にAI向け製品を投入してゆく、というものであることは繰り返す必要は無い(Photo01)が、まずClient向けで言えばCore UltraことMeteor LakeがNPUを内蔵した形で提供開始されており、年内の出荷量は4000万台に達すると予定されている(Photo02)。これに続く製品としてLunar Lakeが予定されているのは既に報じた通りであるが、今回AI PerformanceがMeteor Lakeの3倍に向上、Platform全体では100TOPSを超えることが発表された(Photo03)。

-

Photo01: "AI Everywhere"ということで一応全セグメントに向けて製品を投入しているが、ややムラがあるのも事実。もっとも、現状全セグメントにムラなく製品を提供できている企業は存在しない。どこまでのEverywhereを実現できるのかは興味深い。

-

Photo02: 逆に言えば、Meteor Lakeの生産量は年間4000万個に過ぎないとも言える。今年1月のIDCの速報によれば、2023年のPC総出荷台数は2億5950万台である。ただ2022年/2023年は出荷台数が結構落ち込んでいる事を考えると、健闘していると言っても良いだろう。

-

Photo03: PlatformというのはCPUとGPU、NPU全部の演算性能を合算したものである。ただ現状、CPUとGPU、NPUを全て並行させて処理できるようなAI Frameworkが存在していないので、この100TOPSという数字にどこまで現実的な意味があるのかはちょっと課題か。ちなみにNPU単体では45TOPSと発表されている。

続いてEdge及びData Centerである。ここに関してはコンポーネントは基本一緒であり、どれだけの規模を集積するかでEdgeかData Centerかが別れる事になる。勿論Inference専用はあまりData Centerで使われることは無いし、Training専用がEdgeに入るケースも珍しいから、その意味では差が無いわけでもない。

さてそのEdge向けと言えば、現在はIntelのXeonと言う事になるが、現在出荷中のEmerald Rapidsこと5th Gen Xeon Scalableに続く製品が、6th Gen Xeon Scalableとはならずに「Xeon 6」となる事が今回発表された(Photo04)。"Performance and Efficiency"から判るように、E-CoreのみのSierra Forestのみならず、P-CoreのGranite RapidsもやはりXeon 6となる。まだ具体的な性能とかは開示されたわけではないのだが、今回2つ指標が示された。一つは性能/消費電力比であり、「第2世代の」Xeon Scalableと比較すると同じ性能ならサーバー台数を1/3近くに減らすことが出来、消費電力で言えば1MWの節約になるというもの(Photo05)。もう一つはパラメータ700億個のLLMをローカルで実行した場合のLatencyを比較すると、同じ4bit Format(FP4の事だろうか?)であってもXeon 6は4th Gen Xeonの倍以上の性能になるというものだ(Photo06)。

-

Photo05: Gen 2 Xeon Scalableというのは要するにCascade Lakeの世代である。最大28コア(56 coreのXeon Platinum 9200シリーズはプラットフォームの互換性が無いからちょっと脇に置いておく)×200台(2Sだとすると11200コア相当)と、288coreのSierra Forest×72台(2Sだとすると41472コア相当)が性能で同等というあたりは、E-Coreの限界ということなのかどうか。

このXeon 6のうちSierra Forestに関しては今四半期中に量産開始となり、Granite Rapidsはその後、と改めて明言された。ただ量産開始≠出荷開始であって、Sierra Forestも現時点ではまだ量産は開始されていないことになるから、と言う事は出荷されるのは早くて第3四半期末あたり。Granite Rapidはその後だから第4四半期か、あるいは2025年にズレ込むのかもしれない。

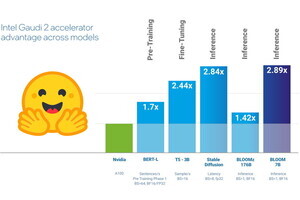

ただXeon 6はどちらかといえばInference向けであって、勿論Data Centerでも利用されるとはいえ、性能比較はどちらかと言えばEdge向けを志向したものになる。ではData Center向けは? というとGaudi 3になる訳だが、以前からアナウンスはあったGaudi 3が正式に発表された(Photo07)。このGaudi 3の詳細はこちらにも示されているので細かい話はこちらをお読みいただきたい(Photo08)。

ちょっと気になるのが、そのGaudiの製品ラインの今後である。こちらのスライドにもあるように、Gaudi 3の次はFalcon Shoresになる訳だが、これはCPU+GPUの構成(Cache/Memoryを共有するという意味では、NVIDIAのGH100/GH200やGB200よりも、AMDのInstinct MI300Aに近い)であり、この中にはGaudi互換のエンジンは入らない構成に見える。現状GaudiシリーズはHabana SynapseAI SDKを利用してアプリケーションを構築する必要がある(PyTorchとかTensorFlow向けのBridgeは提供されるが、そのまま動く訳ではない)。ただこれはGaudi専用であってPonte Vecchioの延長にあると考えられるFalcon Shores上で動作するかが判断できない。

基調講演に合わせて出されたリリースを読むと、最後にIntel Tiberへの言及がある。説明によればTiberとは「生成AIアプリケーションを含めた、企業環境へのソフトウェアやサービスの導入を効率化するビジネス向けソリューション」とされており、Tiber AI/Tiber Trust&Security/Tiber Cloud/Tiber Edgeという4つのプラットフォームが提供されることになっているが、ひょっとするとこのTiber CloudがGaudi 3からFalcon Shoresへの橋渡しの役割を担っているのかもしれない。