NVIDIAは5月14日(米国時間)、同日より開催しているオンラインプライベートカンファレンス「GTC2020」において、同社の最新アーキテクチャとなる「Ampere」をベースに開発された初のGPUとなるデータセンター向け製品「NVIDIA A100」を発表した。

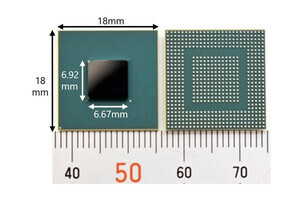

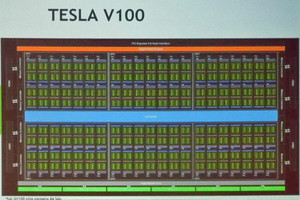

同製品はTSMCの7nmプロセスを採用し、ダイサイズは826mm2と前世代のVoltaとほぼ同等(Voltaは815mm2)ながら、トランジスタ数は2倍以上となる540億(Voltaは211億)となっており、第3世代のTensorコア、600GB/sに対応する第3世代NVLINKなども備えており、DRAMとしてSamsung Electronics製HBM2(メモリ帯域1.6TB/s)を40GB備えるという。

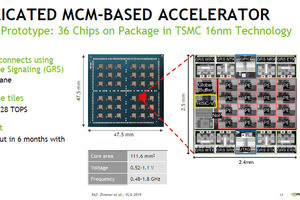

第3世代のTensorコアでは、新たに「Tensor Float32(TF32)」ならびに「Brain Floating Point 16(BFloat16)」というデータフォーマットをサポート。TF32で学習を行った場合、312TFLOPSであり、これはVoltaでFP32におる学習を行った場合に比べて約20倍の性能向上となるほか、INT8の推論で比較した場合でも性能は1248TOPSと、約20倍向上するとしている。

また、GPUチップ内のリソースを最大7インスタンスに分割できるマルチインスタンスGPU(MIG)技術を採用。これにより、よりGPUのリソースを有効活用できるようになり、システム全体の性能向上を図ることができるようになるとしている。

なお、同製品はすでに量産出荷を開始しており、Alibaba Cloud や Amazon Web Services (AWS)、Atos, Baidu Cloud、Cisco、Dell Technologies、富士通、GIGABYTE、Google Cloud、H3C、Hewlett Packard Enterprise (HPE)、Inspur、Lenovo、Microsoft Azure、Oracle、Quanta/QCT、Supermicro、Tencent Cloudといった世界の主要クラウドプロバイダやシステムビルダが自社製品やサービスに採用する予定だという。

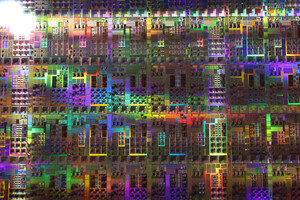

NVIDIA GTC 2020のキーノートにおけるNVIDIA A100の紹介動画