◆性能と普及状況

ここまではSPECRate_int_Peakなどを使っての性能比較がメインだったが、実際にアプリケーションワークロードでの比較も色々紹介された。

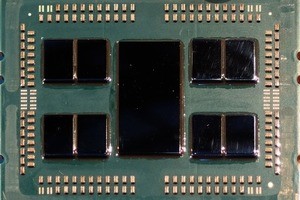

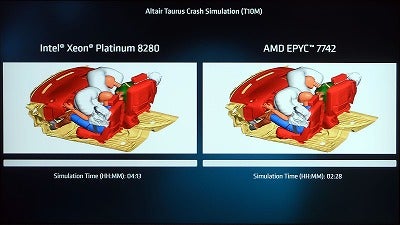

科学技術計算の分野ではAltair RADIOSSを利用してのTaurus Crash Simulation(Photo23)とかGROMACSを利用してのLignocellulosic biomass Simulation(Photo24)などの他、様々な分野でXeonに比べて高い性能を発揮している事をアピールした。

-

Photo23: 衝突時にエアバッグが展開するシミュレーションをXeon PlatinumとEPYC 7742で同時に実行開始。結果はご覧の通り。

-

Photo24: ちなみに今年1月には、分子動力学のシミュレーションであるNAMDをXeon 8180と64core EPYCのプロトタイプの両方で比較、EPYCの方が高速というデモを行ったが、これに対抗してIntelは4月にCascade Lake-APを使い、より性能が上というデモを行っている。これをどう思う? と説明員に確認したところ「消費電力が違う。向こうは(こちらの)2倍だ」という明快な回答が。

またBlenderを利用してのライブデモ(Photo25)なども行われていた。

-

Photo25: 時間の関係で全ての動作デモの写真は撮影できなかった。

-

Photo26: 左がXeon、右がEPYC(型番はどちらも不明)。CPUベースのレンダリングでは概ね1.9倍高速とされる。何故かXeonの方が倍近いメモリを利用しているが、その理由は担当者にも判らないとの事だった。

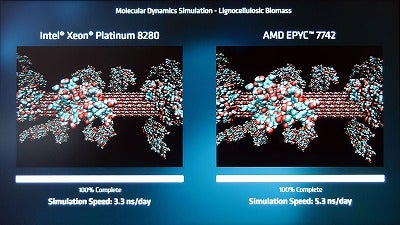

クラウド環境については、さすがにライブデモというのは難しかったようで結果のみの表示であったが、例えばAmazon AWSのEC2 M5aのコスト比較ではEPYCを利用したノードの方がコスト節約になるとされていた(Photo27)。Photo28はPublic Cloudを構成した場合のコスト試算で、EPYCを利用することでTCOを半減させられるとしている。

-

Photo27: 担当者に「コスト半減ではなく、$1.44程度の節約なのはなぜ?」と聞いたら「いやそれも1年分になると大きな節約になるんだ」という、答えになってない答えが。

-

Photo28: これはAMDの試算。

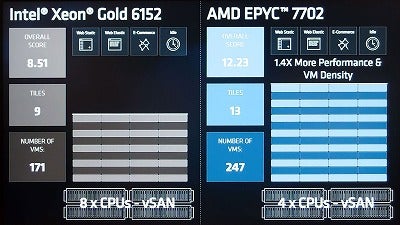

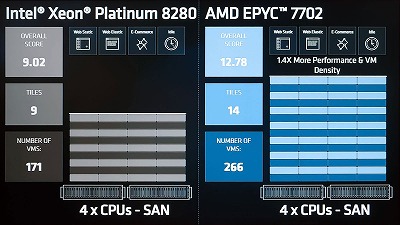

Photo29・30はVMmarkを実施した例で、vSANを使うケースとSANを使うケースのどちらでも、EPYC 7702が40%ほど密度を上げられるとしている。

-

Photo29: こちらはvSANを利用した例。何故か比較対象はSkylake-SPベースのXeon Gold 6152(44core)である。

-

Photo30: こちらはSANで接続したケース。Intelの側はXeon Platinum 8280を持ってきているにも関わらず、あまり性能が改善していない。

講演の中でLisa Su CEOは「第2世代EPYCは80もの世界記録を作った」とアピールしたが、その内訳がこちら(Photo31)。細かなデータはこちらから参照できる。

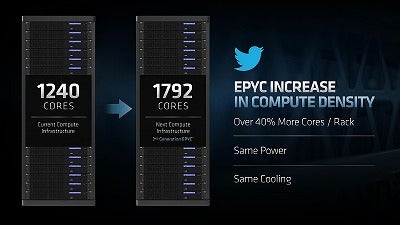

これに加えて、OEMベンダーも第2世代EPYCサーバーを利用してやはり新記録を出している。Twitterは、第2世代EPYCを利用することで、同じ消費電力/冷却能力のまま、既存のサーバーからコアの数を40%増やすことに成功している(Photo32)と説明した。

CRAYはAMDと共同で2021年中に稼働予定のFrontierを既に受注しているが、これに加えて米空軍の天候シミュレーションに利用するHPC11というシステムをこの第2世代EPYCで構成し、2020年に稼働させることを発表した(Photo33)。

-

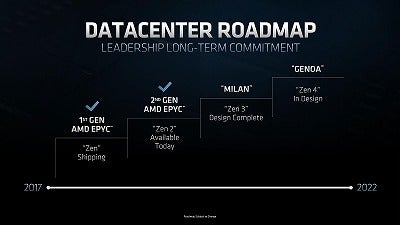

Photo33: これはAMDのEPYCとCrayの共同システムの一覧。左上のDOE向けがFrontier、NERSC向けがPerlmutterであるが、PerlmutterはMilan(Romeの次のZen 3ベースEPYC)ベースだし、恐らくFrontierはGenoa(Milanの更に次のZen 4ベースEPYC)になると思われる。

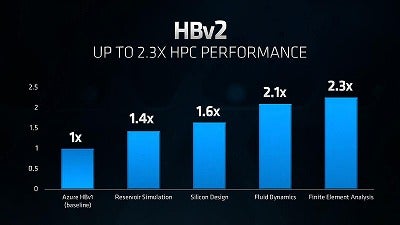

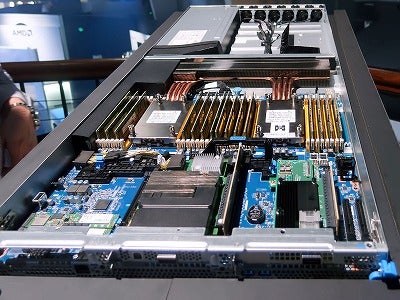

Microsoftは第1世代EPYCをベースとしたAzure HBv2の提供を開始することも発表し(Photo34~36)、これは第2世代EPYCをベースとしたものである。会場ではこのHBv2用のサーバーも展示されていた(Photo37,38)。

-

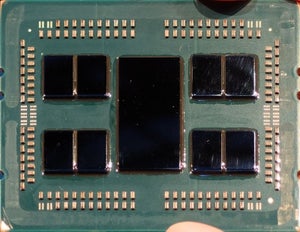

Photo37: そのHBv2向けシャーシ。1UのシャーシにCPUが2つとSSD、それとInfinibandのI/Fカードが搭載されているのが判る。上側のCPUのちょっと斜め下に"Microsoft"のロゴがあることから判る様に、これはMicrosoftが自社で設計・製造したそうである。

-

Photo38: 同じ筐体を別アングルから。2 Socketの冷却が空冷で済む(しかも1Uサイズ)というあたり、事実上水冷が必須のCascadeLake-APとの大きな違いと言える。

クラウドで言えば、Googleも自社のGoogle Cloud Compute Engineに第2世代EPYCを利用するアナウンスをしていたほか、HPEはProLiantとApolloのラインナップに第2世代EPYCを搭載した製品を同日から追加して出荷開始(Photo39)、Lenovoも8月に第2世代EPYC搭載製品を出荷予定で(Photo40)、DellEMCもやはり搭載製品を予定している事を発表した(Photo41)。

-

Photo39: 筆者の個人的感想としては、第2世代EPYCの採用よりも。"ProLiant"とか"Apollo"という名称がまだ残っていた事の方が驚きである。

-

Photo40: まずはラックサーバーから、という事らしい。

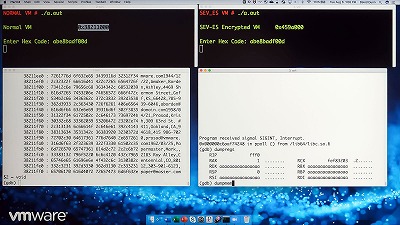

ソフトウェアで言えば、先にPhoto12でVMwareのSEV対応は"Contact Vendor For Schedule"となっていたが、会場ではVMware vSphere上でSEV対応を行ったプロトタイプの動作デモを行っていた(Photo42)。

-

Photo42: 左は何も対応していないVMを動かしたケースで、メモリの内容が簡単にデバッガでダンプできる。ところがSEV対応のVM(右)の方は、ダンプしようとしてもデバッガがSIGINTを興して内容が参照できない。

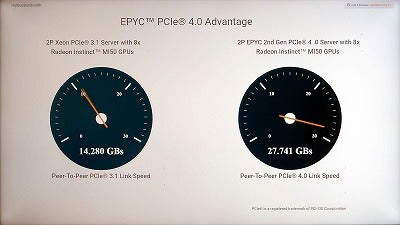

I/O性能に関しては、AMDがRadeon Instinct MI50へのアクセス性能をデモしていた(Photo43)ほか、MellanoxがConnectX-6を展示(Photo44)していた。他にXilinxは前日に発表されたAlveo U50を展示し、Spark Query AccelerationでQuery 1が4.7倍、Query 2が6.5倍高速化されたと説明していた。

-

Photo43: ちなみにこれは8枚のRadeon Instinctへの転送性能の平均値をリアルタイムで表示中。ほぼスペック通りではある。ただGamingと異なり、アクセラレータとして利用する場合はこの帯域の大きさがそのまま効いてくる。

-

Photo44: 200GbEとInfiniBand 200G HDRに対応できるConnectX-6。200Gbps=25GB/secなので、理論帯域が16GB/secのPCI Express Gen3 x16では足りず、PCI Express Gen4 x16かPCI Express Gen3 x32が必要になる。

またSamsungは8月9日に第2世代EPYCに対応したSSDと高密度DIMMを発表したが、会場にはU.2タイプのPM1733 SSD(PCIe Gen4×4)が展示されていた(Photo45)。

なお、講演の最後で第4世代EPYCの開発コード名が「GENOA」であることが明らかにされた(Photo46)。