NVIDIAは3月27日(米国時間)、技術者向けイベント「GPU Technology Conference 2018」(GTC 2018)にて、データセンター向けGPU「Tesla V100」に32GB HBM2を搭載した新モデルを追加した。

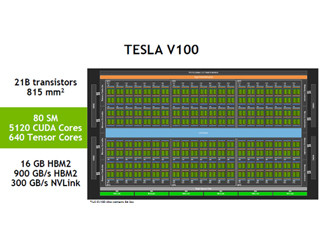

Tesla V100は、NVIDIAが2017年5月に発表したGPU。GPUコアに"Volta"ベースの「GV100」コアを採用する。従来モデルでは16GB HBM2メモリを実装していたが、新たに追加されたモデルでは倍となる32GBのHBM2メモリを搭載する。

また、プロセッサ間の接続インタフェース「NVLink」も引き続きサポート。6レーンのNVLinkで8基のTesla V100を接続できるのだが、さらに高いレベルの学習性能を実現するには、単一ノードでより多くのGPUが必要だとして、NVLinkを基にしたスイッチ「NVSwitch」を投入。

これを12基使うことで、最大16基のTesla V100を接続可能で、トータルのスループットは2.4TB/sにも上る。また、512GBものメモリ空間、14.4TB/sのメモリ帯域幅を活用できるようになる。合計のCUDAコアhgは81,920基。基調講演に登壇したNVIDIA CEOのジェンスン・ファン氏は「世界で最も巨大なGPU」と表現した。

また、NVIDIAは32GB HBM2を搭載したTesla V100とNVSwitchを使った深層学習向けサーバ「DGX-2」も発表した。「DGX-2」は2基のXeon Platinumと、16基のTesla V100、1.5TBのシステムメモリ、30TBのNVMe SSDを搭載。

消費電力は10kW。FP16(16ビット半精度浮動小数点数)における演算性能で、前世代の「DGX-1」(8基のGPUを搭載)から2倍の2PFLOPSに達する。

価格は399,000ドル(約4,230万円)。2018年第3四半期に発売するとしている。ファン氏は同じ性能をCPUベースで構築した場合、デュアルCPUサーバが300台いるとして、価格は300万ドル(約3億1,800万円)かかるほか、消費電力は180kWになると説明。「DGX-2」のコストパフォーマンスと電力効率をアピールした。