NTTコミュニケーション科学基礎研究所は6月3日、最新の研究成果を公開するイベント「オープンハウス2013」のプレス向け事前発表会を都内で開催した。オープンハウス2013は6月6日、7日の2日間、京都にあるNTT京阪奈ビルにて行われる。同イベントでは30件の基礎研究が公開される予定で、プレス向けに展示された研究は、そのうちの7件。

NTTの研究所では、総勢2500名の研究員が基礎研究に従事しており、先日新たに北米の研究室「NTT Inovation Institute Inc.(NTTアイキューブ)」の開設も果たした。

基礎研究は世の中に広がるまで時間のかかる分野だが、より良い生活をエンジョイしてもらうために日々研究を行っているという。同研究所 所長の前田 英作氏は「すぐにこの研究の成果を得られるわけではないが、明日の、未来のための発表。その価値をご理解いただければ」と話した。

続いて、展示された基礎研究の説明に移った。1点目は、ビッグデータ解析。ビッグデータ解析というと、すでにトレンドとなっている用語であり、基礎研究とは無縁に思えるかもしれないが、研究所では「ビッグデータ解析のための革新的機械学習研究」として、研究を行っている。

ビッグデータ解析を行う際に、主に対象となる人間の複雑な社会活動などは、物理モデルでは説明しづらく、科学的に信頼性の高い解析・予測を実現するためには機械学習技術に基づいた統計的なモデル化が必要だという。しかし、これまではビッグデータを解析する場合に、機械学習を行うと、処理に大幅な時間を要することがあった。

そこでNTTの研究所では、Jubatusと呼ばれるオンラインデータ処理基盤技術を活用して、オンラインで接続したままビッグデータを処理する。多種類のデータを同時に統計解析できることで、横断的に現れるパターンを自動抽出できるという。

ドメインを跨いだ膨大なデータの統計解析も可能で、データの直感的な理解に繋がるとして、ソーシャルメディアの解析デモも行っていた。この技術の利用想定として、単一的なデータでは見えない潜在情報(例:震災時の行動パターン)の多面的把握を挙げていた。

2点目は、環境モニタリングだ。環境モニタリングは、大量に設置する各種センサ(気温計など)のデータを集計し、情報分析を行う。その際に課題として、センサの電池持ちがある。センサの電池持ちに最も影響を及ぼすのが、データを無線でサーバに送信する時の通信だ。

研究所は、この通信を削減する方法として、データの圧縮率を向上させた。

圧縮方式は、大量に設置されているセンサの計測したデータから相関性を導きだし、データが重なる部分の通信を行わないことで、通信頻度を下げる。

センサの数が多ければ多いほど圧縮率が改善され、最大で60%の通信量の削減に成功、電池持ちもほぼ比例して改善できたとしている。

3点目は、位置情報サービスのプライバシー保護で、「仮名交換」という技術を活用する。位置情報サービスは、位置情報をサービス事業者に提供することで、サービスの改善、発展に繋がっているが、その一方で"会社から自宅に帰宅する経路情報"などプライバシーが筒抜けになることから、提供に慎重なユーザーも多いという。

そこで研究所では、長期的な位置情報のプライバシー(半日、一日など)を保護しつつも、"駅から店"などの短期的な位置情報は取得できる「仮名交換」を開発した。

これは、同じ場所に居合わせたユーザーの行き先をランダムに取り替えることで、個人の移動履歴を追えないようにする技術だ。

完全に移動履歴を追わないようにした場合はデータに利用価値がなくなるが、仮名交換の場合には、ユーザーの移動量や、経路情報がある程度は追うことができるため、データの有用性を保ちつつ、マーケティングに活用できる。

ユーザー側も、他ユーザーと出会うポイント(例えば駅、スーパーなど)で、他のユーザーと経路が交換されるため、プライバシーが保護されるとしている。

4点目は中国語から日本語への翻訳技術で、2012年に研究所が発表した英日翻訳の中国語版となる。これまでの翻訳技術は、語彙と語順を同時に翻訳する「ルールベース機械翻訳」で行われていたが、この技術は、語順を先に並べ替えてから翻訳することで、翻訳精度を向上させたという。

中国語や英語では、修飾語などが左右どちらにも係るが、日本語では、左から右にかかることがほとんどだ。これに格助詞を補うことで、自然な日本語への翻訳を行えるようになったという。

この仕組みに加え、統計的機械翻訳を利用することで、実用レベルの精度を持つ翻訳を実現可能にしたとする。統計的機械翻訳では、特許文章を解析し、学習することで翻訳精度を向上させた。特許文章は、定型的な言い回しなどが多く、多量の対訳文を入手しやすいことからも、機械翻訳を行いやすいという。日常会話などへの応用は難しいものの、ビジネスシーンでの活用に期待できそうだ。

5点目は日本人の英語発音をネイティブ英語発音に変換する技術で、発話リズム抽出法を用いて、スペクトログラムを周波数情報(発音)と時間情報(発話リズム)に分解発音のリズムを変えることで、ネイティブのような英語の発音に変えることを可能にする。

時間情報に含まれている音素列は、人間が発話する際に調音運動で滑らかに繋がれており、その発話メカニズムを導入したリズム抽出アルゴリズムを開発したことにより、ネイティブ発音への変換を実現したとする。将来的には、電話越しで外国人と会話を行う際に、自動的なリズム変換を実現することなどが想定されている。

6点目としては、音声認識技術の精度向上技術が展示されており、単語エラー率が従来の約30%から約20%と10ポイント近く改善を果たしたことが示されていた。

従来は言葉と関係ない音を除去する「特徴抽出」、言葉の最小単位を当てる「音素推定」と単語の繋がりを考えて最も良い文章を出力する「出力文推定」を要素別に分けて行っていたが、NTTでは、これらをひとまとめに連続して分析し、それぞれの要素を相互に再調整し続けることで、精度の向上を図ったとする。

そして最後に紹介されていたのが「見るだけでモノの形や質感が変わる」現象の発見というもの。ヒトの脳みそは、目で見た映像を脳内で複雑な処理を行うことにより三次元の物体を認識していると考えられている。その一方で、「りんごの形状、色、質感」といった、断片的な統計情報を目で見た映像と組み合わせることで、物体を認識しているという説もあるという。

今回の発表では、後者の説の立場を取っている。実験内容は、とある物体Aを一定時間見せたあと、他の似たような形状の物体Bを見せると、脳が錯覚を起こして物体Bのように見えてしまうと言うもの。これについては実際に動画を見ると分かりやすい。

動画の真ん中にある点に意識を集中していると、左右にある点滅している2つの物体が、最後に別の物体へと変わる。この物体は、左右で違う物体のように見えるかもしれないが、実はまったく同じ物体を表示している。

これが別の物体に見えているのであれば、錯視を起こしていることになる。この発表はまだまだ研究段階であり、今後どのように発展していくかは未知数であるが3D表示技術への応用などが考えられているという。

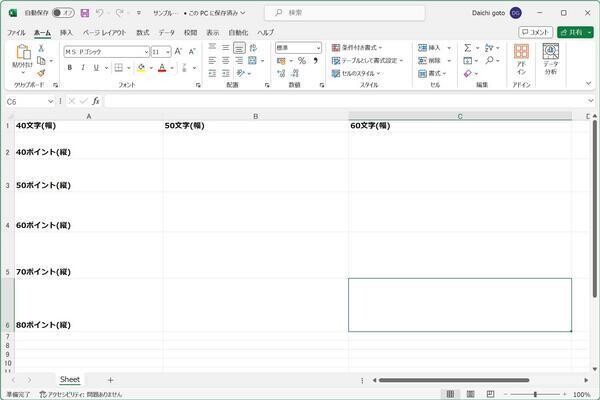

なお同研究所によると、昨年のオープンハウスでは、2日間で約1000名の来場者があったという。これらの発表以外にもタブレット端末向けの新しい文章表示の提案など、さまざまな展示が行われる予定となっているので、興味を持った関西圏の方はぜひ足を運んでみたらいかがだろうか。