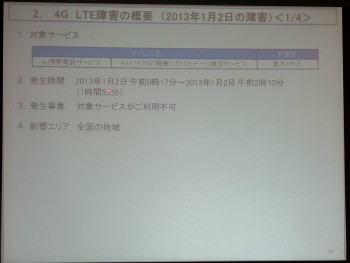

二つ目の障害は、1月2日の午前0時17分から1時間53分にわたって4G LTEのデータ通信ができなくなった問題で、最大175万人が影響を受けた。当初0時5分に発生し、1時53分に解消したとしていたが、精査した結果、発生は0時17分、解消は2時10分だったという。

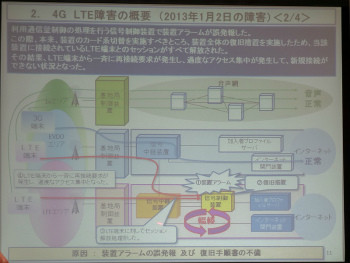

原因はひとつ目の障害とは異なり、信号制御装置が突如アラームを発報し、その復旧でミスが発生したことでLTE対応端末のセッションが解放され、再接続要求が殺到し、アクセス集中で信号制御装置が輻輳を起こした、というもの。

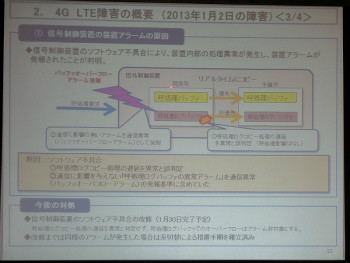

信号制御装置は、呼処理を行うバッファと、その呼処理のログを記録するバッファの2種類があり、現在利用している現用系のデータは、予備系の装置にリアルタイムでコピーされている。しかし、信号制御装置のソフトウェアにバグがあり、呼処理ログバッファのコピー処理で遅延が発生した際に、装置全体の異常と認識され、装置アラームが発報されたという。

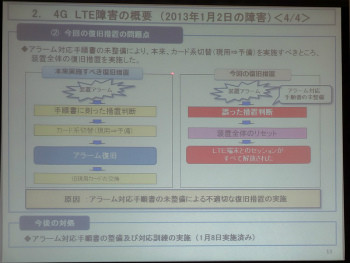

この遅延自体も「多少」(同)の時間であり、装置の処理自体には問題はなかったが、アラームが鳴ったことで同社の運用者が復旧作業を実施。その際、現用系から予備系に切り替えを行うだけで良かったところに、装置全体の復旧措置を実施してしまった。本来は手順書に従った作業を行うべきだったが、手順書には装置アラームの存在は記載されていたものの、発報時の対策方法が記載されていなかったという。

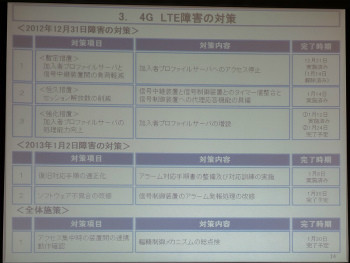

この対応で、セッション解放・再接続要求が一斉に発生し、そのため、アクセス集中による輻輳が発生し、データ通信の利用ができなくなった。対策として、1月30日までに信号制御装置のソフトウェアの不具合を改修する。1月8日には、すでに手順書の整備と異常発生時の対応訓練も実施しており、同様の問題が発生しないようにした。

この2つの障害を受けて同社では、アクセス集中時に各装置間でどのように連携動作するかを検証し、輻輳を制御するメカニズムを再点検する。1月30日までに完了する予定で、すでに多くは点検終了しており、「二度とこういうことが起きないようにする」(同)考えだ。