[2ページ] : PowerPointの自動翻訳が凄い! AI時代のビジネスフロー

[3ページ] : DBにAI追加、高速で安全! 世界規模の分散管理DBもアナウンス

[4ページ] : HoloLensの父が登壇! 建築会社は設計データをHoloLensごと納品

5月23日、東京都港区のプリンスパークタワー東京にて、日本マイクロソフトが主催する開発者向けの年次イベント「de:code 2017」が開催された。

基調講演では、MicrosoftとしてAIへの対応を進めていることを全面的にアピール。Preferred Networks(PFN)との協業をアナウンスしたほか、国内外で開発されたチャットボットや、ビジュアルな環境で手軽に試せるディープラーニング(深層学習)サービス、AIを搭載したSQLサーバなどを、デモを交えながら紹介した。

さらに、KinectやHoloLensを生み出した開発者Alex Kipman氏も登壇。MR(Mixed Reality : 複合現実)をベースとした近未来のコミュニケーション像なども解説された。

本稿では、3時間に及んだトピックス満載の基調講演の中から、事例を中心に主な話題を取り上げていこう。各サービスには、リンクも張ってあるのでぜひ試してほしい。

MSが手掛けたAI、最初の事例はAI女子高生「りんな」

基調講演の中で最も強調された言葉が、「Intelligent Cloud(インテリジェントクラウド)」と「Intelligent Edge(インテリジェントエッジ)」だ。ここ数年、モバイルファースト、クラウドファーストを推進してきた同社だが、今後はモバイルとクラウドの双方にAIの力を加えていくという。

講演では、これを実践するMicrosoftによるAIイノベーション事例をいくつか紹介した。

最初に取り上げられたのが、深層学習を利用して国内で開発されたチャットボット「りんな」。AI女子高生という設定の下、女子高生らしい返答をするチャットボットとして稼動する。LINEとTwitterにアカウントを持ち、フォロワーは570万人。ローソンのLINE公式アカウント「ローソンクルー♪あきこちゃん」にも採用されている。

さらに「AI男子 俺様」という設定の「りんお」を開発したことも紹介。今年の4月頭に期間限定でLINE/Twitterにおいてアカウントを公開していた。講演では、「好きな食べ物は?」と聞くと「辛いもん。ドクターペッパーとパクチー」と回答し、「焼肉行こう」とつぶやくと「今度は俺も連れてってーな」と反応するデモを披露した。

だれでも試せる画像の深層学習「Custom Vision Service」

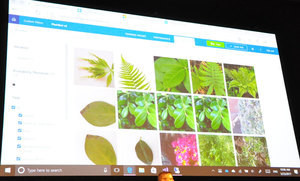

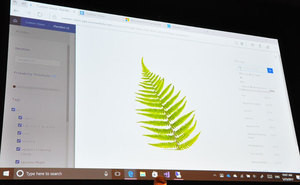

続いて紹介されたのは、簡単なGUIの操作で画像の深層学習を実行できるサービス「Custom Vision Service」。タグ付けした画像をアップロードしてトレーニング開始ボタンをクリックするだけで、独自の画像認識AIサービスを作ることができる。

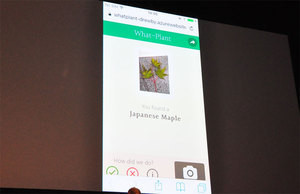

デモでは、Custom Vision Serviceの基盤でもある、Microsoft Azureの「Cognitive Services」を使って開発された「CaptionBot」も紹介。「内緒だけど、ホテルの庭で取ってきた(笑)」という紅葉をその場で撮影し、CaptionBotにアップロードしたところ、「Japanese Maple」という回答が得られる様子を披露した。

UI開発も簡略化! AIボットが簡単に作れる「Bot Framework」

簡単にチャットボットを開発するサービスとして「Bot Framework」も紹介。Skype用ボットや、Bingの検索ページに表示するボット、さらには会話を理解する機能や、FAQを元に回答を生成する機能など、12種類のコンポーネントが用意されている。

なかでも、今回特に焦点を当てられたのが「Adaptive Cards」。これは、カード形式のUIコンポーネントをJSONで作成できる技術。SkypeやAndroid、iOS、Micosoft Teams、Webブラウザからの通知などさまざまなプラットフォームに対応しており、1ソースで各プラットフォームに対応したものが自動生成される。

Adaptive Cardsには、コメント送信機能など、ユーザーとのインタラクション機能があらかじめ用意されているほか、カードに記載された内容を読み上げる機能なども提供されている。現代のWebに必要とされる機能が簡単に用意できる。

[2ページ] : PowerPointの自動翻訳が凄い! AI時代のビジネスフロー

[3ページ] : DBにAI追加、高速で安全! 世界規模の分散管理DBもアナウンス

[4ページ] : HoloLensの父が登壇! 建築会社は設計データをHoloLensごと納品