2022年末にOpenAIの「ChatGPT」が登場して以来、生成AIブームが巻き起こっているのは周知の事実だろう。昨年までは、多くの企業であくまでも「試してみる」というフェーズだったが、昨年半ばからはアプリケーションやソリューションを構築するなど、実際に活用していくフェーズを迎えたと言っても過言ではない。

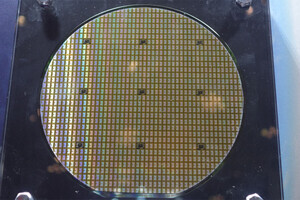

そのような中でAI開発に必須となっているものがGPUだ。そして、GPUと言えば先日にMicrosoft(マイクロソフト)やApple(アップル)を抜いて、時価総額が3兆3300億ドルに達したNVIDIA(エヌビディア)のここ1~2年間における躍進は目を見張るものがある。

米国のテックジャイアントたちはNVIDIAのGPUを大量に買い漁っており、2023年第3四半期における同社の販売統計(出典:Omdia Research)では、GPU「H100」の販売台数50万台以上のうち、MicrosoftとMetaで各15万台、Google、Amazon、Oracleなどが各5万台を購入している。

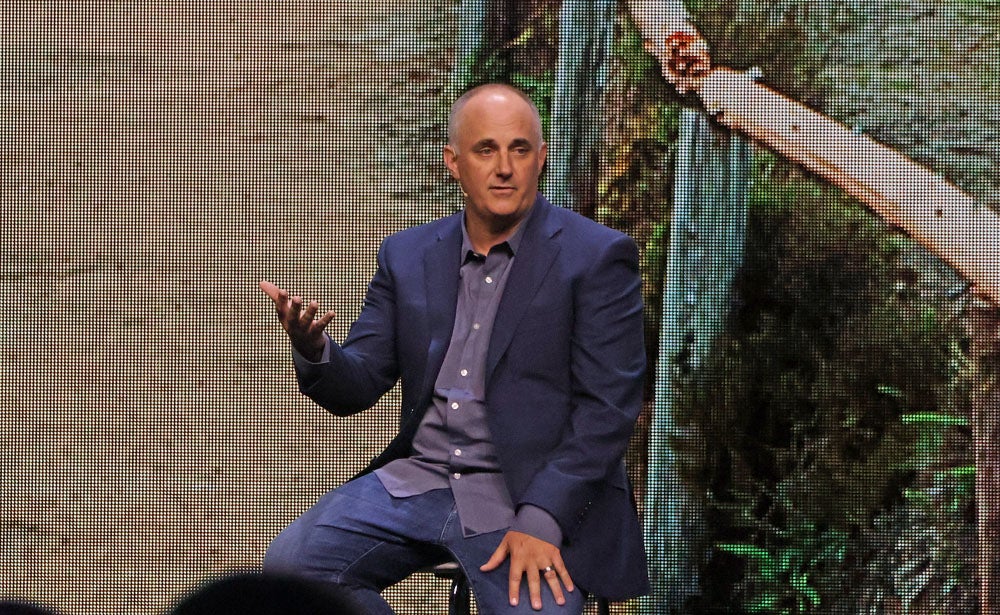

Nutanix(ニュータニックス)が5月末にスペインのバルセロナで開催した「.NEXT 2024」の基調講演で、NVIDIA Vice President Enterprise AIのJustin Boitano氏と、Nutanix CCO(Chief Commercial Officer)のTarkan Maner氏が対談を行った。

Nutanixと連携を深めるNVIDIA

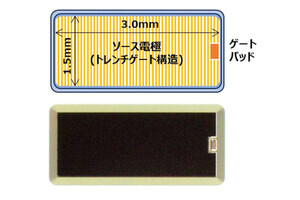

Nutanixは、.NEXT 2024において昨年に発表した同社でストレージ機能とGPUをサポートして、そこにフレームワークを載せればすぐにAIの開発が始められる「Nutanix GPT-in-a-Box」に、NVIDIAアクセラレーテッドコンピューティングのサポートを含めた「同2.0」を発表。そして、GPT-in-a-Box 2.0とNVIDIAの生成AIアプリケーションの開発向けマイクロサービス「NIM」との連携を発表し、同社との関係を深めている。

GPT-in-a-Box 2.0を活用してAIモデルの導入を簡素化し、企業向けAI/ML(機械学習)アプリケーションを効果的・効率的に実行可能なほか、NIMのカタログを企業全体とエッジで活用できる。

一方、NIMがGPT-in-a-Box 2.0に対応することで、APIを活用したオープンソースのコミュニティモデル、NVIDIA AI基盤モデル、カスタムモデルなどにもとづくシームレスなAI推論が可能。また、NVIDIA NIMを含む本番グレードAIの開発・導入を合理化するソフトウェアプラットフォーム「NVIDIA AI Enterprise 5.0」の認証も明らかにしている。

まず、Maner氏からこれまでのNVIDIAについて聞かれたBoitano氏は「CEOのJensen Huang(ジェンスン・フアン)はよく『会社で見る一夜の成功は、実際には10年間の業務に相当する』と言っています。しかし、この言葉は2006年にアクセラレーテッドコンピューティングの先駆者として始まった私たちにとって、これ以上ないほどの真実」と語った。

エンタープライズAIの行く末

同社は2006年にGPU向けの汎用並列コンピューティングアーキテクチャ・プログラミングモデルとして「CUDA」の提供を開始している。

Boitano氏は「ムーアの法則が終わりに近づいていたため、世界が新しいコンピュータアーキテクチャを必要としていることに気づきました。最初はHPC(ハイパフォーマンスコンピューティング)センターに導入し、研究者や科学者は新しい計算能力を使い、20年先の未来を見ることができると理解しました。その時以来、アクセラレーテッドコンピューティングはクラウドやデータセンターに広がり、生成AIのステージまで来ました」と話す。

続けて、Maner氏は顧客にとって重要なことは世界的なAIの安全性や持続可能性、セキュリティ、プライバシーの側面であることから、今後のエンタープライズAIの方向性について尋ねた。

-

左からNutanix CCO(Chief Commercial Officer)のTarkan Maner氏、NVIDIA Vice President Enterprise AIのJustin Boitano氏

Boitano氏は「生成AIは言うは易しですが、一歩下がって考えてみると私たちは人間ではない知能について話しているのです。そして、私たちは皆、ChatGPTのような生成AIのクラウドサービスと最初の接触を経験しました。すべてのオープンモデルの開発者は素晴らしいモデルを構築し、精度の真実に追いついていますが、それらのモデルを自社のデータに接続できない限り、各企業にとっては役に立ちません。したがって、企業で起こっていることは、AIエージェントを使用したアプリケーションを構築し始めているということです」との見解だ。

続けて、同氏は「最初は推論の計画を作成し、構造化されたデータベースを検索するために第2のモデルに行くかもしれませんし、非構造化されたデータベースのために第3のモデルに行くかもしれません。ユーザーの質問に十分に答えられるか否かを推論し、最終的には応答を生成します。そのため、連携して動くモデルの連鎖として考える必要があります」という。

そして、Boitano氏は「データセンターでモデルを1つだけ動かすだけでなく、これらのモデルを連鎖的にデータに接続することが重要」と強調する。といのも開発者がより簡単に利用できるように、新しいプラットフォームを導入することで彼らが求めるREST APIを提供する大きな機会があることに気づいたからとのことだ。

これにより、開発したものがNIMというわけだ。NIMではLLM(大規模言語モデル)を提供するベンダーと協力してモデルのパフォーマンスを最適化し、データセンターで最も効率的に動作するという。

同氏は「ランタイムを保護し、シンプルなマイクロサービスを提供します。これにより、顧客のクラウドまたは選択したデータセンターで実行できます」と説明した。

これにより、アプリ開発者は最先端のモデルに接続し、計画を立てているか、カスタマーサポートのAIエージェントを利用しているかに関わらず、ビジネスの問題を推論し始めることができるとのことだ。

「まずは生成AIをスタートすることが重要」 - Boitano氏

企業にはさまざまなアプリケーションがあり、カスタマーサポートのAIエージェントやAIコーディングアシスタントなどからスタートすることが多いものの、AIはすべての産業・企業の生産性を向上させる可能性がある。

同氏は「正直に言って、どこから始めるかは重要ではありません。スタートすることが重要です。すべては生成AIの船に乗船することであり、これをビジネスの生産性に変え、組織を力強くするビジネスにしていくことがポイントです」との認識を示す。

では、パートナーエコシステムについてはどうか。その点について、Boitano氏はNVIDIAはGPUについて大きなパートナーエコシステムを構築しており、すべてのクラウド、データセンター、エッジ、ノートPC、ワークステーションで動作するという。開発者が最大かつ最小の基盤を持つことができるようにしていることから、エコシステムを通じて、すべてのシステムと連携しているとのことだ。

そのうえで、同氏は「次にハイパーバイザーの企業、Kubernetes関連の企業、OSを提供する企業と協力して、アプリケーション層にパフォーマンスを提供できるようにしており、アプリ開発者と協力します。私たちは何百万ものアプリ開発者、何千ものAIスタートアップ、グローバルソリューションインテグレーターのエコシステムを持っています」と、パートナーエコシステムが順調に拡大していることを伝えた。

最後に、同氏は「誰もがモバイルデバイスのブラウザを開いて、ai.nvidia.comにアクセスし、NIMをすぐに利用できます。Web UIを通じてそれらをプロンプトし、APIキーを作成してアプリケーションに組み込み、準備ができたら、Nutanix Cloud Platformにエクスポートして、データのプライバシーとセキュリティを維持することを可能としています」とNIMを訴求し、対談を結んだ。