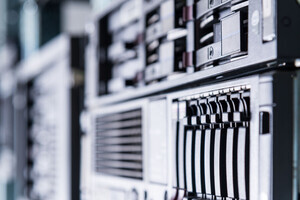

Dell Technologies(デル)の年次カンファレンス「Dell Technologies World 2024」(5月20日~23日 米ネバダ州開催)は、デルが「AI Edition」と明記するほど“AI推し"だった。カンファレンスの目玉となった「Dell AI Factory」(は、デルが擁するITインフラを核とし、ソフトウェアやプロフェッショナルサービスを包含したAIワークロードに最適な環境を提供するものだ。

カンファレンスの目玉となった「Dell AI Factory」

基調講演では、MetaやHugging Faceといった大規模言語モデル(LLM)や自然言語処理(NLP)ツールを提供する企業のキーパーソンが登壇し、デルとの協業を発表した。

Hugging Faceはデルのインフラ向けにカスタマイズしたLLMを容易に実装できる「Dell Enterprise Hub on Hugging Face」を発表。一方、Metaはデルのインフラ上で「Llama 3」モデルを容易に検証・展開できる詳細情報などを提供していくことを明らかにした。

今後、生成AI活用の有無がビジネスの成長を左右することは間違いない。一方で懸念されるのがセキュリティリスクだ。オープンなエコシステムによる生成AIの活用は、モデルの堅牢性やAPI(Application Programming Interface)セキュリティといった観点から適切なリスク管理が求められる。

デルで最高技術責任者(CTO)を務めるJohn Roese氏は「過去1年間で、生成AIのセキュリティを取り巻く環境は変化している。企業はその変化を見極め、どのような対策を講じるべきかを見極める必要がある」と指摘する。では、その変化とは何なのか。Roese氏に話を聞いた。

“セカンドオピニオン”でAIのハルシネーションを管理

Roese氏によると、この1年間でAIセキュリティを取り巻く環境には2つの特徴が見られるという。1つ目は、安全性と堅牢性の確保が重要な課題として認識されたことだ。

生成AIの台頭当初から、生成AIが現実とは異なる情報を生成する「ハルシネーション(Hallucination)」するリスクや、モデルのパラメータ・構造情報を盗取する「モデル盗難攻撃(Model stealing attacks)」を懸念する声は挙がっていた。

こうした現状に対し、Roese氏は「現在もハルシネーションを防止する方法は見つかっていないが、検索拡張生成(RAG:Retrieval Augmented Generation)といったハルシネーションを管理する手法は開発されている。特にMetaが開発したLlama 3のようなオープンソースの言語モデル開発では、モデルの堅牢性を向上させる研究開発が積極的に行われている」と指摘する。

もう1つは、エンタープライズ向け言語モデルの普及が、セキュリティ専門家が懸念していた状況よりも遅いことだ。そのため、モデルを盗むような攻撃もほとんど見られないという。

モデル盗難攻撃とは、攻撃者がAPIなどを通じてモデルにアクセスできる場合に、大量のクエリを送信してモデルの動作を推定する手法である。これにより、攻撃者はそのモデルと同等の性能を持つ別のモデルを作成することが可能となる。

しかし、現時点では攻撃者が盗取できるようなモデルは少数であり、モデルを盗むような攻撃は一般的ではないとRoese氏は指摘する。

「サイバーセキュリティは攻撃者と防御者の競争だ。1年前、生成AIをビジネスで活用する機運が高まった際には、誰がどのような手法で(生成AIを)攻撃するかわからず、あらゆる攻撃シナリオを想定した。この1年間で防御者の取り組みは進展し、言語モデルに堅牢なセキュリティ技術が組み込まれた。また、政府もセキュリティアプローチの標準化に取組んでいる。今後こうした動きは加速するだろう」(Roese氏)。

ビジネスモデルも盗取されるリスク

さらにRoese氏は「2025年以降、AIシステムは“公共環境”から企業の環境へと移行していくトレンドとなる。そうした状況の中で、留意すべきはモデル盗難だ。企業の生成AI導入目的は生産性の向上であり、モデル盗難のリスクは生産性の低下を招くことと同義語だと考えてよい」と警鐘を鳴らす。

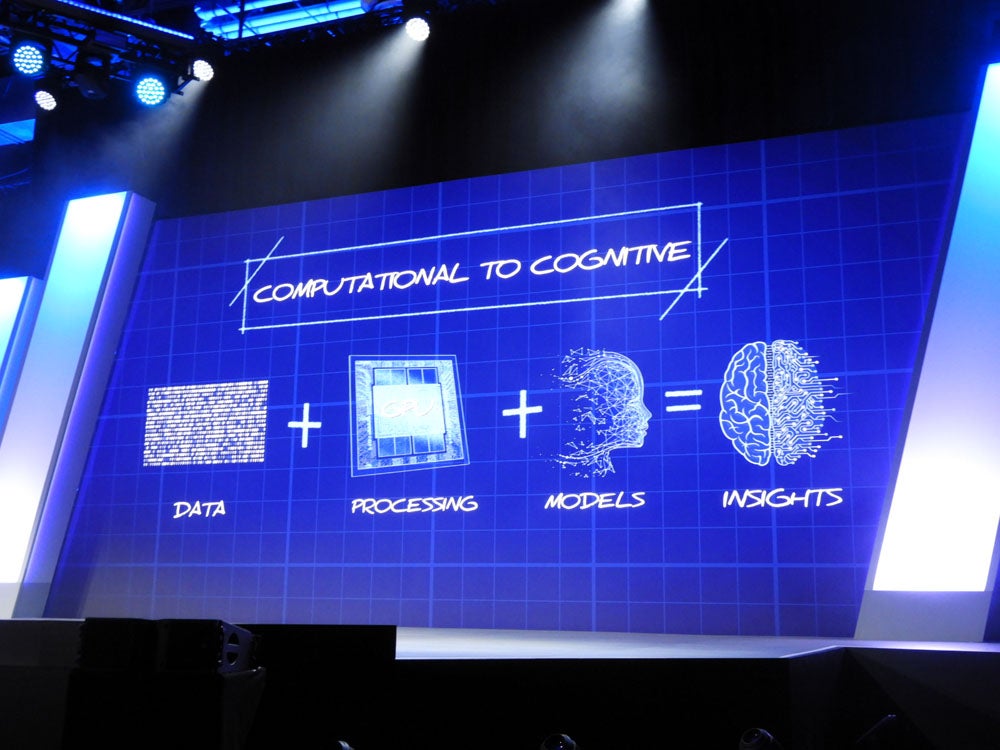

かねてからデルでは「AIのある場所にデータを置くのではなく、データのある場所でAIワークロードを実行するほうが効率的だ」と主張している。

デルによると、企業が所有するデータの83%はオンプレミス環境にあり、自社のITインフラにAIシステムを組み込むほうが、コストや運用管理、さらに迅速にAIモデルを展開できるといった観点からも有効だという。

「企業がAIを導入する大局的な目的は競争力の強化であり、新しいビジネスプロセスの中核にAIを実装する。これによりソフトウェア開発の自動化や販売プロセスの自動化などが実現すると期待される。しかし、AIのモデルを盗難されてしまえば、企業の重要な資産であるデータも同時に盗難されてしまう」(Roese氏)。

企業が自社ビジネスの中核に導入するAIモデルは、企業独自のデータを利用してチューニングするケースが多い。このため、AIモデルを盗まれることは、単にモデル自体の損失だけでなく、企業の重要な資産であるデータとビジネスモデルの損失も意味する。

Roese氏は「AIモデルの盗難は、企業にとって技術的な損失以上の深刻な問題だ。例えば、販売・流通に関連するAIモデルが盗取されれば、誰が顧客で、どのような販売戦略を立案し、どのようなプロセスで製品が市場に投入されるかを把握できる。そうなれば、AI導入の効果以上(AI盗難によって被った)に被害の方が大きくなる」と指摘する。

さらにAIが業務システムに組み込まれ、これまで人間が行ってきた作業の多くがAIによって代替されると、その業務に精通している人材が不要になり、人材リソースの配置にも変化が生じる。こうした状況でAIが利用できなくなれば、業務の継続が困難になり、ビジネス自体が停止してしまう。

Roese氏は「AIのセキュリティ対策は単にAIシステムを守るだけでなく、ビジネス全体を守る重要な対策でもある。企業がAI環境に最適なIT基盤を再構築する際には、従来の古いセキュリティモデルをそのまま踏襲すべきではない。AIシステムに適したセキュリティ対策を講じることが不可欠だ」と訴えていた。