Google Cloudが4月9日~11日に米ラスベガスで開催した「Google Cloud Next'24」では、同社初のArmベースのCPUから、AIアプリケーションを構築する「Vertex AI Agent Builder」、Google Workspaceに加わる新アプリ「Google Vids」まで、さまざまな発表があった。イベントでは、CEOとして同社を率いるThomas Kurian(トーマス・クリアン)氏が記者からの質問に答えた。本稿では、Kurian氏の回答をトピック別にまとめる。

「選択肢は重要」 - 生成AIのニーズは各社で異なる

--ビジネスのアップデートとGoogle Cloud Nextでの主要な発表について教えてください。

クリアン氏(以下、敬称略):5年前にCEOに就任し、この5年でGoogle Cloudの事業は5倍の規模となった。Google Cloudは現在、エンタープライズ向けにソフトウェアを提供する企業として第4位だ。イベントには3万人が来場し、2500社のパートナーが参加した。

成長の要因の1つとして、われわれは常にテクノロジーが向かう方向に賭け、そこに対して適切な製品とソリューションを提供してきたことが挙げられる。

前回(2023年8月末)のイベントで顧客の多くは、生成AIで何ができるのかをテストしている段階だった。今年のイベントでは顧客が実際に生成AIを大規模に導入し、成果を上げていることを示すことができた。

基調講演だけでGeminiを使う57~58社の顧客の声を紹介し、セッションでは300社以上の企業が自分たちの生成AIの活用を共有した。

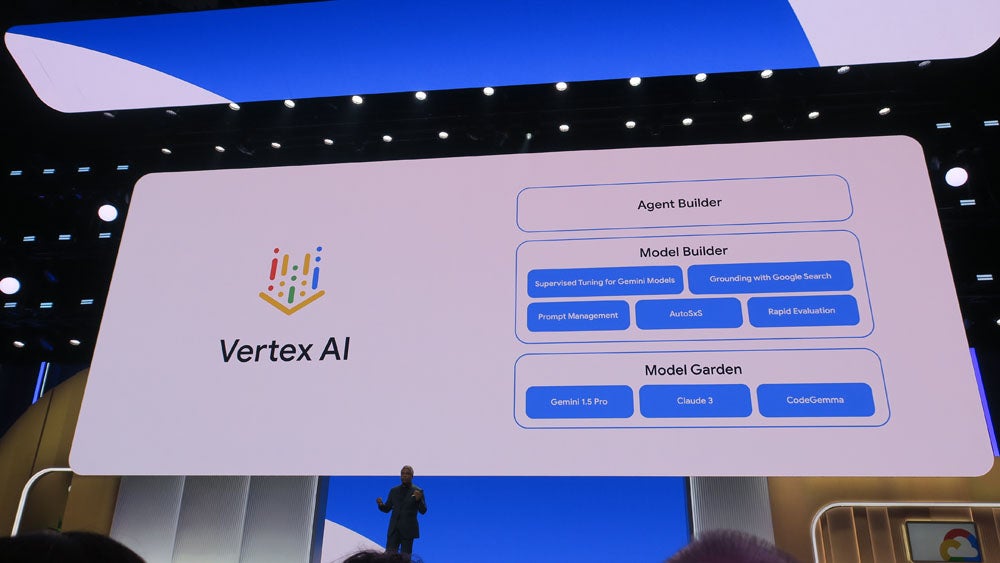

PoC(概念実証)から本番環境での展開に進めている顧客に共通していることは、AIを活用するためのプラットフォームを導入していること。Google Cloudは「Vertex AI」としてそのプラットフォームを提供し、モデルの発見、チューニング、オーグメント、デプロイを支援する。

ポイントは選択肢。顧客は複数のモデルの中から比較して最善のモデルを使うことがができる。ツール、データベース、アプリケーションも然りだ。最善のものを選ぶことができる。

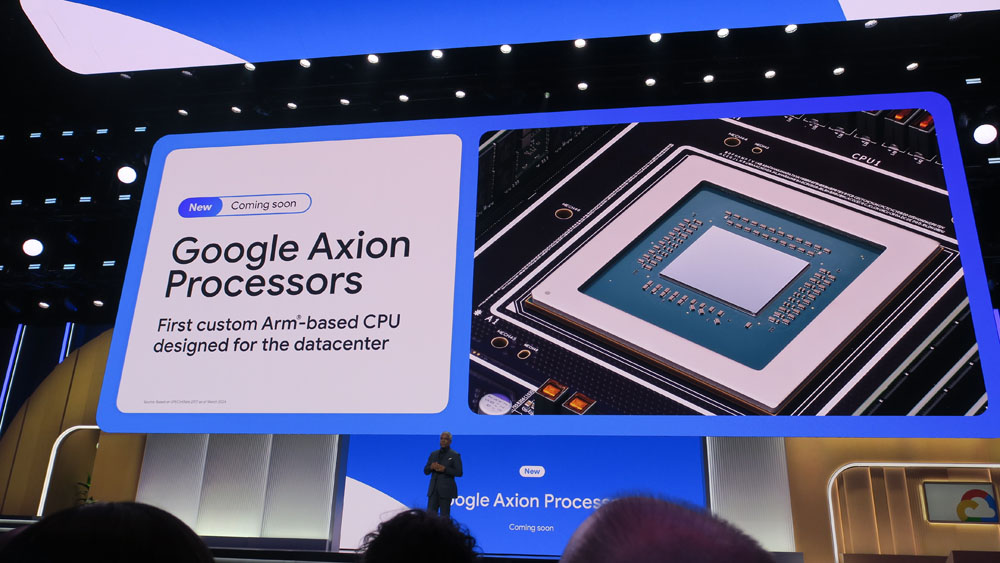

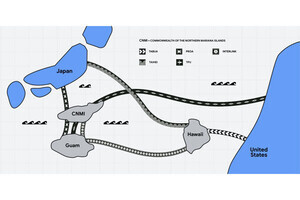

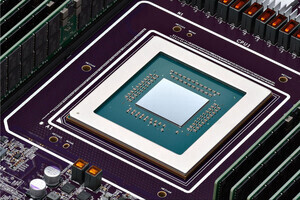

プラットフォームの提供に加え、Google Cloudはチップからシステムまでを垂直的に最適化している。ここでは、ArmベースのカスタムCPUを発表したほか、新しいIntel XeonプロセッサやNvidiaのBlackwellアーキテクチャのサポートも発表した。会期中、アジア太平洋地域の新しい海底ケーブル計画も発表した。

チップからモデル、エージェントまですべてのシステムを構築でき、垂直的に最適化することで、品質、コスト、拡張性に優れ、異なるテクノロジーが混在する環境でもシステムを統合できる。

選択肢は重要だ。1つとして同じ企業はなく、生成AIにおけるシステムのニーズは各社で異なるからだ。

「Vertex AI Agent Builder」と「Axion」について

--AIエージェントおよび「Vertex AI Agent Builder」についてはどうですか?

クリアン:これまで生成AIといえばチャットボットだったが、マルチモーダルなモデルではチャットに限定されずさまざまなことができる。エージェントはチャットボット以上のもので、情報を理解、推論し、意思決定を支援する。他のエージェントや人間と会話ができる自律的なソフトウェアだ。

テクノロジーやAIが進む方向性として、単に人を段階的に支援するだけでなく、モデルが洗練されていくに連れてできることが豊かになっていくと想定している。

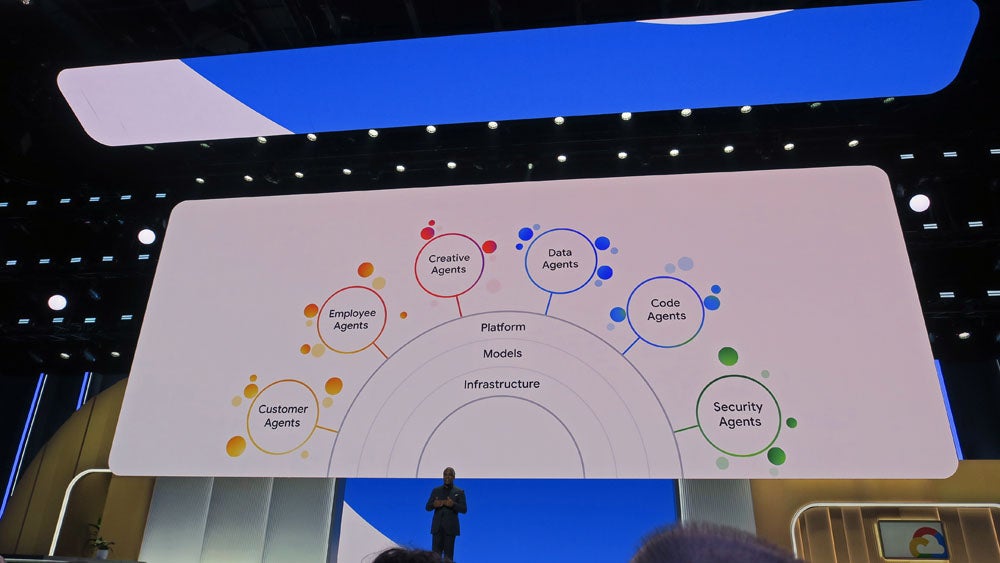

基調講演では、顧客を支援するカスタマーエージェント、従業員を支援するエンプロイーエージェントなど6つの分野のエージェントを切り口に紹介した。すべて、Google Cloudの顧客が実際に構築しているエージェントだ。

例えば従業員のエージェントでは、従業員が福利厚生に関するメールを受け取り、メールを要約し、福利厚生システムを見てその情報を他のプログラムと比較する。そして、自分がそのプログラムを利用する資格があるかを確認する。

これらすべてを結びつけて横断的に調整するシステムが必要であり、SaaS(Software as a Service)ベンダーが組み込む生成AIでは限界がある。

フランスの通信キャリアであるOrangeは、顧客の質問に答える会話型のエージェントを導入した。Agent Builderを用いて、請求書に関する情報、コンタクトセンターにある情報などを参照できるようにしている。

--「Axion」(GoogleのArmベースCPU)の発表が、既存の提携関係に与える影響は、どうでしょうか?

クリアン:われわれは長年、さまざまな種類のシステムに取り組んできた。自社でチップを設計しており、典型的なコンピューティングではAMD、Intelなどとの協業を続けている。イベントでは、Intelの第5世代のXeonのサポートを発表している。

ここでの狙いは、選択肢だ。各プロセッサはそれぞれ、シングルスレッド、シングルコア、マルチコアなど最適化されているワークロードが異なる。

Googleは10年以上前からAIシステムに取り組んでいる。TPU(Tensor Processing Unit)の設計は2012年に始まり、2014年にローンチした。12年の歴史がある。その後、さまざまな種類のアクセラレーターが必要と分かり、われわれのモデルには13種類のアクセラレーターを揃えている。

トレーニング用、推論用と用途に合わせたTPUを用意するほか、NVIDIAとも協力している。大規模トレーニング用の最新のH100だけでなく、L4も提供している。NVIDIAとは、チップの最適化に加え、ソフトウェアの最適化でも協業している。

われわれが独自のシステムの取り組みを進めることは、これらの企業と競合することにはならない。われわれは密に協業するパートナー関係を構築しており、顧客にさまざまなシステムの選択肢を提供することを最優先している。

実際、AIユニコーン企業の90%、AIスタートアップの60%がGoogle Cloudを利用している。彼らは最もAIの専門性が高い企業であり、パフォーマンスとコストを重要視する企業だ。そのような企業がGoogle Cloudを選んだのは、われわれに選択肢があるからだ。

「われわれはAWSよりも前にAnthropicに出資している」

--ハルシネーション(幻覚)対策としてのグラウンディングについての考え方を教えてください。

クリアン:LLMでは、モデルの“事実性”を向上させることに取り組んでいる。つまり、モデルが答えを出す時、事実に基づいているということだ。

イベントでは、Google検索のグラウンディングを発表した。これが持つ意味は大きい。なぜなら、ある特定の日にトレーニングが終了したモデルに対して、その後に起きた情報についてユーザーが質問することがある。

Google検索は世界中で使われており、信頼されている情報源だ。モデルが答えを生成する際に、Google検索の回答と比較して事実に基づいているかどうかを検証できるようになる。

このほかにも、ハルシネーションをゼロに近づけるために、さまざまな新しいテクニックに取り組んでいる。

--競合について。Anthropicの「Claude 3」をサポートするが、AnthropicはAWS(Amazon Web Services)も出資していますが?

クリアン:顧客は、モデルを提供するプロバイダが1社の資本に占有される状況を望んでいないはずだ。

それから、われわれはAWSよりも前にAnthropicに出資している。だが、AnthropicをGoogleに縛り付けるつもりはなく、選択肢として提供している。顧客はGeminiやClaudeを目的に応じて使いわけたいと思っており、そのための標準化されたツールを望んでいる。我々はVertex AIでそれを実現する。

今年のGoogle Cloud Nextは、過去最大の規模になった。Googleはクラウドでは後発であり、来場いただいたすべての顧客、パートナーは他社を選ぶこともできた。だが、ここに足を運んでいただいた。

われわれの成功は、顧客とパートナーを支援する素晴らしいチームがあり、専門知識とソリューション、そして製品を提供しているからだ。未来を占うことはできないが、実績を見ることは最善の方法だ。我々はこれまでの道のりを土台に、さらなる成功に向けて事業を拡大していく。