Google Cloudは4月10日、年次カンファレンス「Google Cloud Next '24」を開催し、インフラストラクチャやAI統合基盤「Vertex AI」関連のサービスなど、多くのサービスを発表した。

AI向けのインフラを拡充

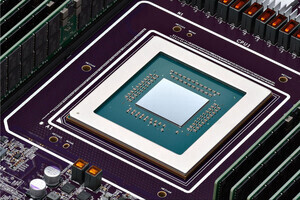

まずはインフラストラクチャ。「A3 Mega」はNVIDIAの「H100 Tensor Core GPU」を使用して開発した新たなGPUベースのインスタンスを2024年5月より一般提供を開始。A3インスタンスと比較して、GPUあたりの帯域幅が2倍になり、要求の厳しいワークロードもサポートするほか、トレーニングおよび推論中に機密データとAIワークロードの機密性と整合性を適切に保護する「Confidential A3」も発表。

また、NVIDIA Blackwellプラットフォーム「NVIDIA HGX B200」「NVIDIA GB200 NVL72」の2つのバージョンが2025年初頭にGoogle Cloudに導入を予定し、HGX B200は要求が厳しいAI、データアナリティクス、HPC ワークロード向けに設計されており、GB200 NVL72はリアルタイムの大規模言語モデル推論と、数兆パラメータ規模のモデルの大規模トレーニングパフォーマンスを強化するという。

「TPU v5p」は、前世代のTPU(Tensor Processing Unit)と比べて、ポッドあたりの計算能力が4倍に強化し、トレーニングと推論において、スケーラブルかつ柔軟なAIアクセレレーターの一般提供を発表。Google Kubernetes Engine(GKE)でTPU v5pがサポートされる。

「Google Axion」はデータセンター向けに設計された同社初のカスタムArmベースCPUとなり、同等の現行世代のx86ベースインスタンスより50%優れたパフォーマンスと最大60%優れたエネルギー効率を実現するという。

さらに、ストレージの「Cloud Storage FUSE」と「Parallelstore」の新しいキャッシュ機能により、データをTPU・GPU に近づけ、トレーニング速度を高速化するという。次世代ブロックストレージサービス「Hyperdisk ML」(プレビュー版)も発表している。

Dynamic Workload Schedulerの新しいオプションとして、開始時刻を保証するカレンダーモードと経済性を最適化するフレックススタートにより、複雑なトレーニングと推論ジョブを分散するための効率的なリソース管理を確保できるという。

オンプレミスホスト用ソリューション「Google Distributed Cloud(GDC)」では接続構成とネットワーク隔離環境構成の両方でNVIDIA GPUを導入したほか、主要なAI企業がGoogle Cloudで使用している同じGKEテクノロジーがGDCでも利用が可能になる。

また、Gemma、Llama 2など、さまざまなオープンAIモデルをGDCで検証し、ネットワーク隔離された環境および接続されたエッジ環境で実行できることに加え、コンテナ化されたAlloyDBデータベースエンジンを独自の Linux ベースのコンピューティング環境で実行する「AlloyDB Omni」にベクトル検索機能を導入し、GDC上で個人データや機密データを超低レイテンシで検索および情報取得できるようになった。

Vertex AI関連のサービス

Vertex AIでは生成AIモデル「Gemini 1.5 Pro」で12万8000Kトークン、100万トークンの2サイズのコンテキストウィンドウがパブリックプレビューで利用可能になったほか、音声付きの動画を含む、音声ファイル処理機能も発表。1時間の動画、11時間の音声、3万行以上のコード、70万文字を超えるコードベースなど、膨大な量の情報を1つのストリームで処理できるという。

さらに、生成AIモデル「Claude 3 Sonnet」と「Claude 3 Haiku」が、Anthropicとのパートナーシップを通して、Vertex AIで一般提供。また「Claude 3 Opus」も今後数週間以内に利用が可能になる予定だ。

Geminiモデルと同じ研究とテクノロジーにより開発されたGemmaは、コード生成やコード支援などのために設計された「CodeGemma」がVertex AIで利用が可能。

また、Vertex AIでモデルのデプロイ、管理、監視も支援するため、プロンプト管理ツールはメモやステータスを含む、組み込みプロンプトで共同作業したり、変更箇所を追跡したり、さまざまなプロンプトからの応答の品質を比較したりできる。

加えて、Automatic side-by-side (AutoSxS)は、特定の回答が別の回答よりも優れている理由と確実性スコアの説明を提供するほか、現在プレビュー中のRapid Evaluation機能はプロンプト設計を反復する際、小規模なデータセットでモデルを迅速に評価できるという。

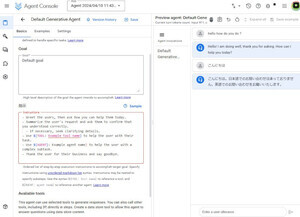

さらに、基盤モデル、Google 検索、その他の開発者ツールを統合し、エージェントの構築とデプロイを容易にするVertex AI Agent Builderを発表。Vertex AI Agent Builderは、コード不要のエージェントビルダーコンソールの利便性とグラウンディング、オーケストレーション、拡張機能を提供し、Google 検索と組織のデータに基づいたさまざまな生成AIエージェントを迅速に作成できるようになるという。

開発、セキュリティ関連

エンタープライズ向けのAIコード支援ソリューション「Gemini 1.5 Pro in Gemini Code Assist」が100万トークンで、大規模なプロジェクトのコーディングを支援。現在、プライベートプレビュー中で、正確なコードの提案、洞察、合理化されたワークフローを提供する。

「Gemini Cloud Assist」は、アプリケーションのライフサイクル全体にわたってAI支援が提供され、アプリケーションの設計、保護、運用、トラブルシューティング、パフォーマンスとコストの最適化が容易になるという。

「Gemini in BigQuery」はAIにより、データの準備、検出、分析、ガバナンスにおいてデータ チームを支援し、BigQueryデータキャンバスと組み合わせることで、データパイプラインを構築・実行できるようになるため、自然言語と埋め込みビジュアライゼーションを備え、プレビュー版で利用できる。

「Gemini in Databases」はデータベースをAlloyDBなどのクラウドデータベースに変換するなど、レガシーシステムからデータを安全かつ確実に移行することが容易だという。

「ベクトル インデックス」はBigQueryとAlloyDBで直接ベクトルインデックスを使用する新しいクエリ機能により、データが保存されている場所でAIを活用し、リアルタイムかつ正確な応答を得ることができるとのことだ。

Gemini in Lookerは、現在プレビュー版で、データエージェントとワークフローを簡単に統合できる。ビジネスデータとチャットできる生成AI機能も追加し、Google Workspaceと統合されている。

セキュリティは「Gemini in Threat Intelligence」では自然言語を使用して、脅威アクターの行動に関する洞察を提供し、Gemini を使用して潜在的に悪意のあるコードの大規模なサンプルも分析できる。

「Gemini in Security Operations」は調査支援機能となり、イベントデータを要約、実行するアクションを推奨するほか、ユーザーとの会話型チャットを通じてプラットフォームを誘導する。

Google Workspace関連

Gemini for Google WorkspaceではAIを活用した業務用動画作成アプリ「Google Vids」を発表。動画の脚本、制作、編集アシスタントをすべて1つにまとめたものとなり、簡単に編集できるストーリーボードを生成し、スタイルを選択すると、ストックビデオ、画像、BGMから提案されたシーンを組み合わせてドラフトが作成される。

また、プリセットのナレーションを選択or独自のナレーションを使用して、適切なメッセージを伝えることもできる。ドキュメント、スプレッドシート、スライドなどと同じくGoogle Workspaceアプリとして提供され、6月にWorkspace Labsで公開を予定。

「AI Meetings and Messagingアドオン」は、Take notes for me機能、会議中の会話の要約機能、69言語(4600の言語ペアに相当)でのリアルタイム翻訳機能を備え、ユーザーあたり月額1130円で利用できる。

「AI Securityアドオン」は組織向けにトレーニングされたプライバシー保護AIモデルとデータ損失防止コントロールを使用し、機密ファイルとデータを自動的に分類して保護できる。ユーザーあたり月額1130円となり、ほとんどのGoogle Workspaceプランに追加を可能としている。