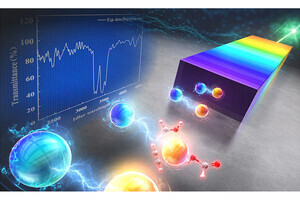

立教大学は2月6日、音声や画像のような信号を異なる周波数の成分に分解する数学的手法「フーリエ変換」を用いて、「グローバルフィルタ」と「注意機構」のメリットを兼ね備えた、大量のメモリを必要としない新しい画像認識手法を開発したことを発表した。

同成果は、立教大大学院 人工知能科学研究科の立浪祐貴大学院生、同・瀧雅人准教授らの研究チームによるもの。詳細は、2月20~27日にカナダ・バンクーバーで開催される米国人工知能学会が主催する国際会議「AAAI-24」で発表される予定で、同会議に採択された論文の査読前プレプリントが「arXiv」で公開されている。

生物は、周囲から得た情報のうち重要なものを自ら判断し、対象に焦点を当てて認識して必要な判断などを行う。生物のこの能力をAIに応用したのが“注意機構”だ。これは深層学習モデルが広範な範囲から重要な情報を自ら判断し、その情報に適切に注目することを可能にする仕組みで、長距離の依存関係を学習するのに適しているとされる。またコンピュータビジョンにおいては、同機構によりモデルが画像内で関連性の高い領域に注目することで、モデルが物体やパターンをより正確に認識できるようになると考えられている。

ただし注意機構の課題に、大量のメモリを必要とするという点がある。同機構では、入力する全要素に対して個別の重み付けを計算し、その結果をメモリ内に保持するため、特にコンピュータビジョンモデルにおいては、画像の解像度が増えるほど入力要素数が大きくなり、必要なメモリも増大することで計算時間も急激に増えてしまうことになる。つまり、モデルが高解像度の画像を扱う場合、物理的リソースの制約から高価なハードウエアが必要となり、経済的負担を生む可能性があるとされている。

そうした中、近年になってこの問題を回避できる手法として提案されたのが、「高速フーリエ変換」(フーリエ変換を効率的に計算するアルゴリズム)ベースの仕組みである“グローバルフィルタ”だ。注意機構と同様に長距離の空間依存性を学習することが可能な同手法は、高速フーリエ変換に加え、周波数領域における要素ごとの掛け算、逆高速フーリエ変換というシンプルな要素で構成される。そのため、解像度が増えても大量のメモリを必要とすることもなく、計算量も穏やかに増加するのみとなる。

しかし現状、グローバルフィルタは最先端の性能を達成しているとはいい難いとのこと。そこで研究チームは今回、グローバルフィルタと注意機構の隔たりに注目し、その隔たりを埋めるための動的フィルタを提案したとする。

グローバルフィルタと注意機構で大きく異なる点は、データの扱い方だ。前者はデータとパラメータを掛け合わせるため、データに依存しない演算が行われる。それに対し後者は個別の重み付けを計算するため、データに依存する演算となる。このように、両者の間にはデータに依存するか否かの差分がある。

そこで今回の研究では、グローバルフィルタに注意機構の利点であるデータに依存する手法を採用し、データに掛け合わせるフィルタを動的に生成する仕組みである動的フィルタを導入したという。同フィルタはデータに応じて重みが計算され、その重みと少数の基底フィルタから、データに応じたフィルタが生成される。研究チームは、この手法であればグローバルフィルタの利点を活かしつつ、注意機構のようなデータ依存性を実現できるとしている。

次に、提案手法の動的フィルタを取り入れた「DFFormer」と、動的フィルタと畳み込みニューラルネットを併用した「CDFFormer」という新たな画像認識モデルが提案された。グローバルフィルタと注意機構の間には、そのものの差だけでなく、それらを採用しているよりマクロなアーキテクチャの間にも差があるとのこと。研究チームはその差を埋めるために、最先端の精度を達成したアーキテクチャ上に動的フィルタを搭載し、フェアな比較の下で動的フィルタの有用性を確認したとする。これらのモデルは、注意機構を利用しない先端的な画像認識モデルに対して、競争的な精度が達成されているとした。

そして、注意機構を使用する最先端のモデルに対しては、従来よりも精度が近づいており、注意機構の抱える問題を克服できているとする。つまり、高解像度の画像認識においても、グローバルフィルタと同様、相対的に少ないメモリ消費や計算時間で済むことが確かめられたのである。

なお、今回開発されたDFFormerとCDFFormerの成功により、高速フーリエ変換ベースの手法が再評価される可能性があるとのこと。近年、注意機構を使用した巨大なモデルばかりが注目される傾向にあったが、動的フィルタのように訓練や推論時の経済的負担が少ないアプローチが重要視される契機にもなる可能性があるという。また研究チームは、動的フィルタを通して、注意機構に関する理解を深める研究が促進されることも期待されるとしている。