便利な生成AIを仕事でも使おうという動きがある。企業がポリシーを設けていればそのルールに沿う必要があるが、特に設けていない場合は注意が必要だ。顧客データや売上データは自社の機密情報。何かあってからでは遅すぎる。

そこで、生成AIを業務に使用する際の注意点として以下の6つのポイントが示唆されている。

1. バイアスに注意せよ

ChatGPTなどの生成AIモデルの多くが、公開されているデータセットや情報を使ってトレーニングされている。そのため、そのデータセットに人口統計学的なバイアスが入っていれば、結果にバイアスが反映される。

バイアスがわかりやすい形で出ていれば良いが、必ずしもそうではない。企業ガバナンスを専門とするジョージタウン大学マクドノウビジネススクール 准教授のJason Schloetzer氏は「AIが生成した資料について、人間が検査するプロセスを挟むことで、バイアスのリスクをある程度軽減できる」とアドバイスしているそうだ。

2. 機密性の高いビジネス情報を共有しない

生成AIのほとんどが、入力された会話やプロンプトを保存し、モデルのトレーニングデータとして使用している(そのため、使う人が多いほど改善される)。

つまり、企業の機密情報を入力したら、その情報が保存され、使われることになる。それは、漏洩リスクを意味する。企業側がルールを設けていない場合は、万が一その情報が漏洩する可能性を考慮して使おう。

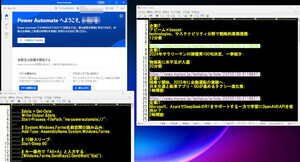

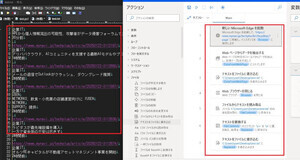

3. AIプログラムは選択せよ

AIプログラムは選んで使いたい。GartnerでAIを専門とするアナリスト、Arun Chandrasekaran氏は、一般に公開されている無料のプログラムよりも、有料で提供されている企業向けのプログラムを使うべき、と助言している。

例えば、ChatGPTのEnterprise版、MicrosoftのBing Chat Enterpriseなどがある。その際は、そのプログラムに入力したデータがどのように保存されるのか、誰がアクセスできるのかを理解しておくべきだ、とChandrasekaran氏は述べている。

4. 生成AIの結果を過信しない

ハルシネーションという言葉を聞いたことがあるだろう。幻覚を意味するもので、生成AIが正確ではないことをそれらしく語る状態を意味する。ハルシネーションが起こっていると理解できればいいが、検証しなければわからないものは誤解させてしまうことになる。

この問題についてChandrasekaran氏は、AIが生成したコンテンツを使用する前に情報の出所を確認することで、AIが不正確な情報を作り出すことへの対策をとることができるとアドバイスしている。

また、企業が生成AIベンダーと独自に契約し、自社のデータベースのみでトレーニングすることも提案する。これにより、不正確な外部情報が入る可能性を排除できるからだ。

5. 生成AIを使ったことを開示

生成AIを使って顧客向けのコンテンツを作成した場合、その旨を開示すべきだ。

「透明性を維持するうえで重要」とSchloetzer氏。そのコンテンツが正確ではなかったり、適切ではないなどの場合は法的責任が問われる。

6. 著作権侵害のリスク

AIが生成するコンテンツには、作家やアーティストの著作権がある作品をもとにしたものがある。

米国では訴訟も起こっており、今後ルールが敷かれていくと想定される。それまでは、AIが生成したコンテンツに著作権保護されたものが入っていないようにしておくべきだ。

以上の6つのポイントは、Wall Street Journalが「The Do's and Don'ts of Using Generative AI in the Workplace」として紹介している。