スマートフォンや家電などにAI(Artificial Intelligence:人工知能)が搭載されるようになり、私たちの生活はますます便利になっている。ロボット掃除機は部屋を自動で綺麗にしてくれるし、エアコンは人の場所を見分けて快適な風を送ってくれる。機械翻訳の精度も日進月歩で向上している。さらには、スマートスピーカーやバーチャルアシスタントに話しかけるだけでこれらを制御できるからとても助かる。

AI技術は今後さらに発展すると考えられており、医師の診断を的確に補助するAI、監視カメラの映像から街の犯罪を未然に防げるAIなども一般的になるだろう。企業の採用面接をAIが行うようになるかもしれない。自動運転の技術進展も期待され、安全で快適な移動体験を提供してくれそうだ。

しかし、AI技術がわれわれにもたらすものは必ずしも便利さだけではないようだ。差別やヘイトスピーチとも取れるテキストを出力するようなチャットボットAIや、クレジットカードの信用スコアで性差別をするようなAIも見られるようになった。

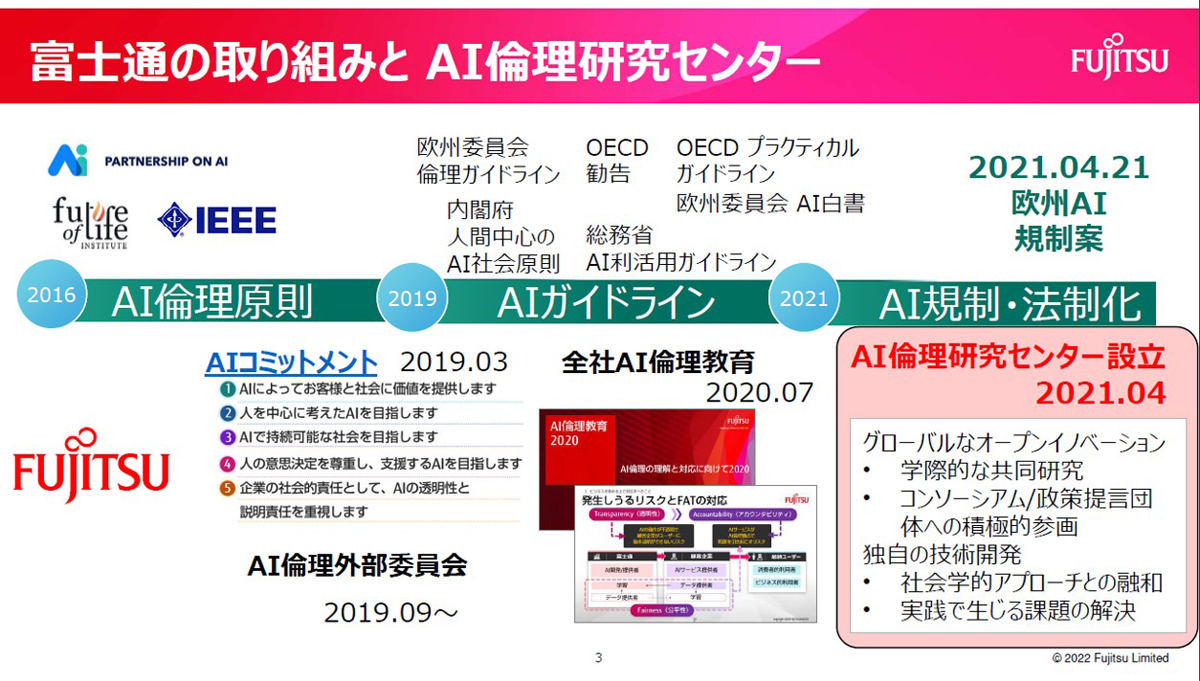

AIを取り巻く課題が見え始めてくるにつれて、さまざまな国や地域で「AI倫理」に関する議論が盛んになってきた。アメリカではIEEEから「Ethically Aligned Design」が公開され、ヨーロッパではAIハイレベル専門グループにより「Ethics Guidelines for Trustworthy AI」が公開された。また、EUで2021年にAI Act(AI法規制案)が提出され、2025年を目途に施行されると見られている。

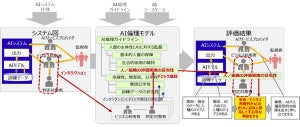

こうした中、富士通は信頼されるAIを実現するために、早期段階からAI倫理の課題に取り組んできた企業の一社だ。2019年に同社のAI倫理を含む価値観をまとめた「AIコミットメント」を発表し、2020年からは全社的なAI倫理教育を開始している。また、2021年4月に「AI倫理研究センター」を設立し、産学連携による社会学的アプローチと技術開発の両面に対する取り組みを開始した。2022年2月にはAI倫理のガイドラインに基づいて倫理上の影響を評価するための方式を無償で公開した。

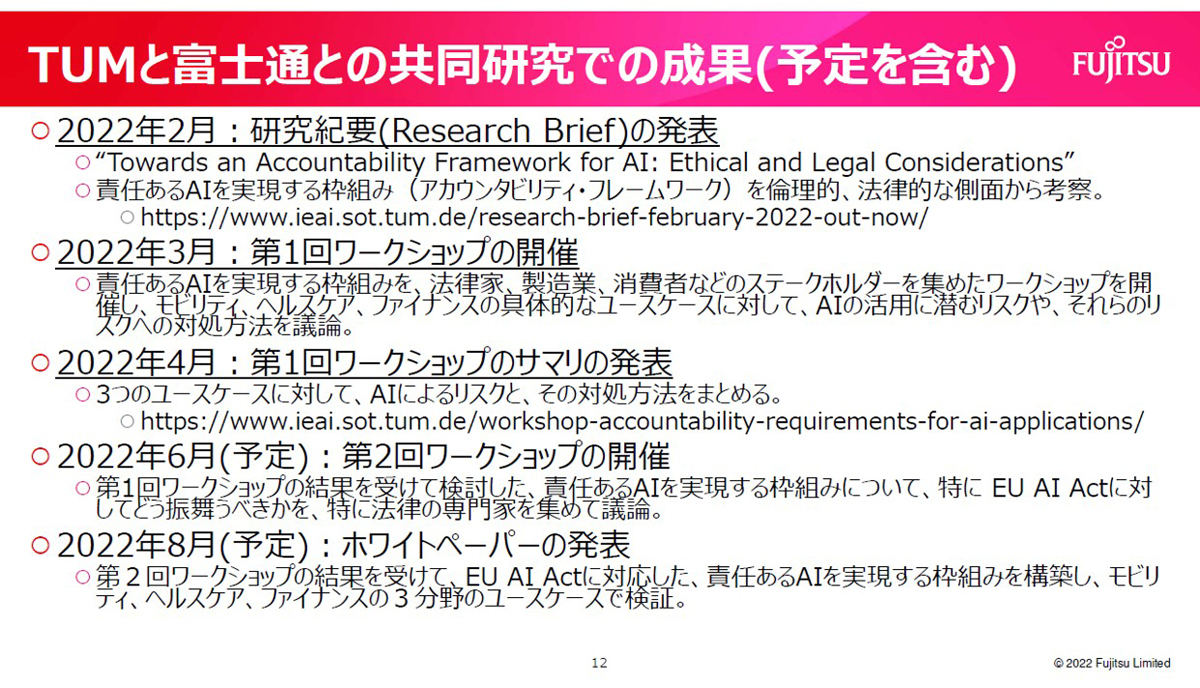

同社は2021年9月に、ミュンヘン工科大学(以下、TUM)AI倫理研究所(以下、IEAI)の所長を務めるChristoph Lütge(クリストフ リュトゲ)氏らと共同研究を開始した。研究の目的は責任あるAIのあり方(アカウンタビリティ・フレームワーク)を検討し、EUのAI Actにどのように対応すべきかを議論する点にある。EUをターゲットとしているのは、GDPR(EU一般データ保護規則)をはじめ、EUの法規制は世界的な提供を与える可能性が大きいためだ。日本企業も例外ではないだろう。

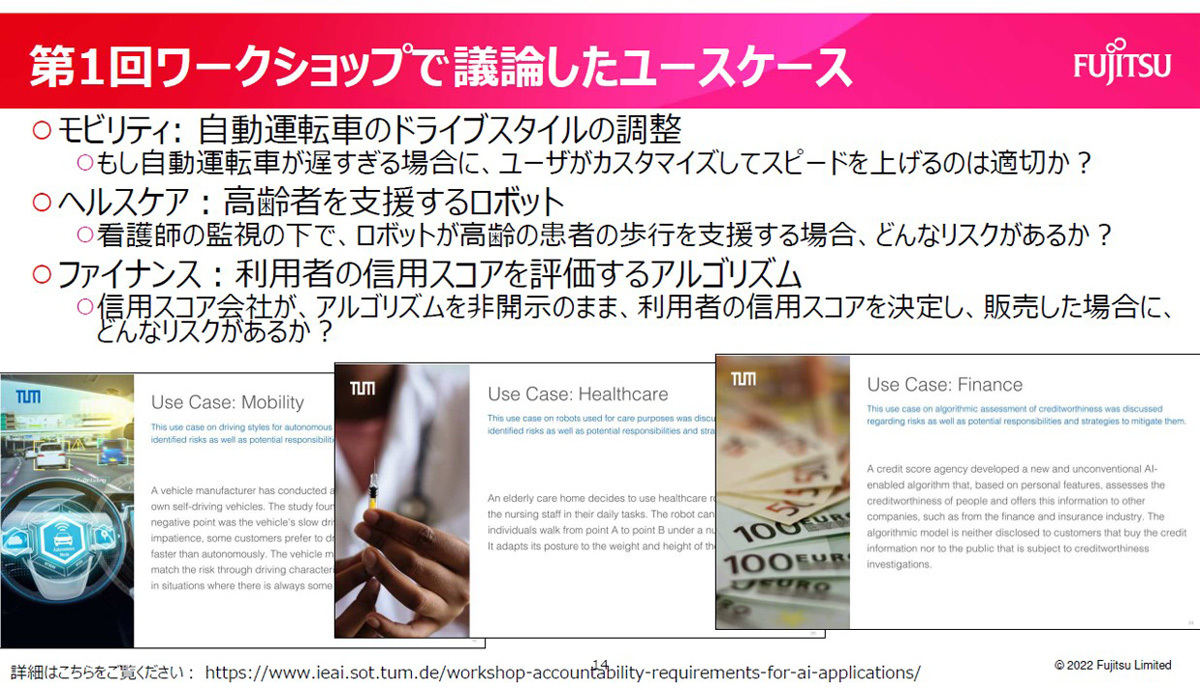

同研究では、法律家や製造業、消費者などさまざまなステークホルダーを集めてワークショップを開催し、モビリティ、ヘルスケア、ファイナンスの具体的なユースケースに対して、AI活用に潜むリスクとその対処方法などを議論するという。今後は得られた意見を集約して、法律、社会受容性、技術などの面から責任あうAIのあり方を体系化していく予定だ。

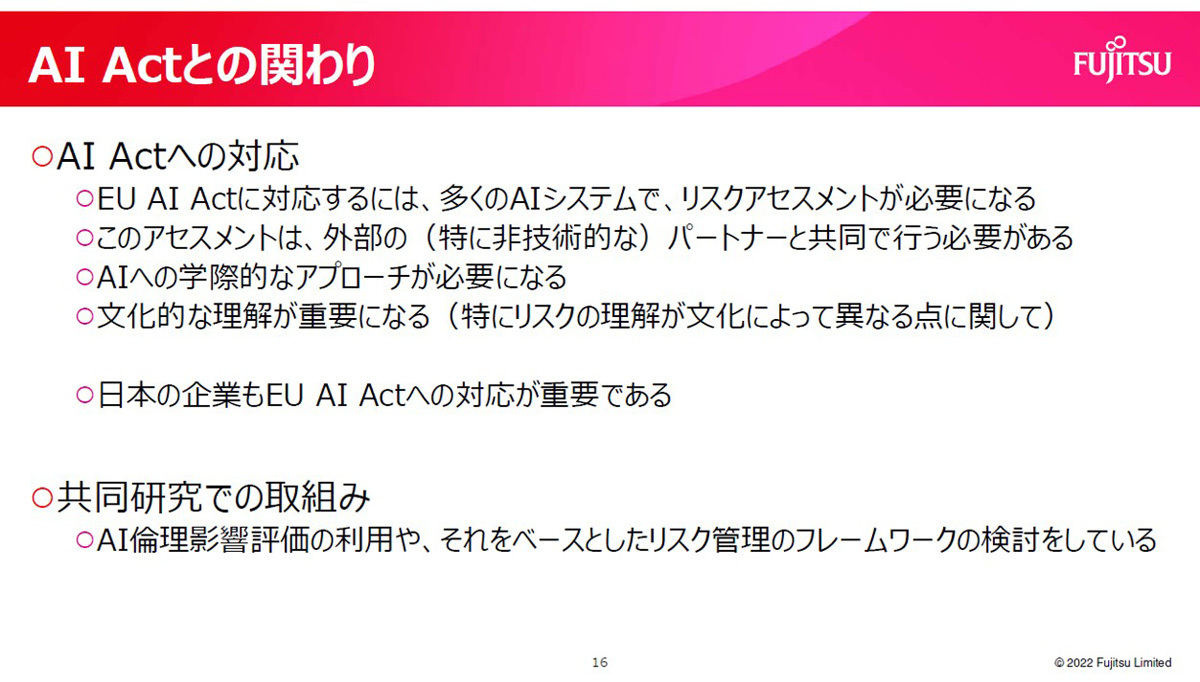

TUMのLütge氏に聞いたところ、「AIの倫理を考えるうえで、EUのAI Actを取り巻く動きが今後数年の大きな変化の一つとなる」と強調していた。「AI Act法案ではAIが持つリスクを前もって検討し、対策を講じておくことを定めており、法律が施行されたらこれを遵守する行動が各企業に求められるようになるだろう。富士通が開発したようなAIリスクの評価システムを各社が持っておくことは、今後必須の要件になると思う」とのことだ。

2022年3月に開かれた両者の共同研究の第1回ワークショップには21名が参加して、モビリティ、ヘルスケア、ファイナンスの3分野の具体的なユースケースに対する意見をブレインストーミング形式で集めたという。各分野に共通したリスクとして「説明性」や「プライバシー」などを求める意見が出された。一方で、モビリティは人命に大きく関わるため特に安全性が求められ、また、ファイナンスは短時間での人とのやり取りと高速な売買判断が必要なため効率性が求められるなど、分野ごとに特有のリスクも挙げられたようだ。

Lütge氏によると、日本企業がEUのAI Actに対応するためには、多くのAIシステムでリスクアセスメントが必要になるとのことだ。特に、このアセスメントは外部のパートナーと共同で行う必要があるという。AI倫理には社会科学や哲学などの学術領域も含まれるため、技術者だけでなく非技術者も交えた学際的なアプローチが不可欠としている。

同氏が所属するTUMのIEAIでは、アカデミアと産業界、市民社会、そして政治などをつなぐプラットフォームとしての役割を目指しているという。各企業が独自のAI倫理を制定するのではなく、業種および業界をまたいだ議論が求められている。

富士通研究所のAI倫理研究センターでTUMとの共同研究を担当する毛利隆夫氏によると、同社も今後はアカデミアや政府などを交えながらさらにAI開発を加速するための仕組み構築に取り組むとしている。

AI技術を支えるディープラーニングは、学習過程でもっともらしい回答を導出するようにパラメータが調整されるため、判断根拠や説明可能性が課題とされてきた。しかし、Lütge氏は「AIの説明性を求めることは、AIの発展を必ずしも妨げはしない」との考えだ。ディープラーニングはあくまで統計解析に基づいており、結果を導くためにより大きな影響を与えている要因は、精密ではなくともある程度予測できるような技術の研究が現在進められているのだという。

「AIの説明性といっても、誰に対して説明する場面なのかで求められる内容は異なる。ユーザーに対する説明なのか、公的な委員会への説明なのかで必要な情報が異なるのは想像できるだろう。今後さらなる議論の余地がある」と同氏は補足した。

近年では、AIが悪意のあるSNSユーザーの投稿を学習したことで差別的なテキストを出力し、大きな問題となった例もある。当然、ヘイトスピーチを助長するようなAIは許されるものではないが、一方で言論の自由も守られなければならない。両者の適切なバランスの取り方も今後の議論が待たれる。

「これまで話してきたように、行政や企業側ではAI倫理に関する議論が進んでいる。むしろ、ユーザー側にも適切なAI倫理を実装するのは非常に難しいだろう。私たちの大学でも、SNSのようなプラットフォーム上でAIによる差別的な発言を避けながら、言論の自由を守るためのプロジェクトが動いているが、良い解決策を見つけるのは簡単なことではない」(Lütge氏)