安全なAI活用を目指す非営利団体のOpenAIは現地時間6日、機械学習のニューラルネットワークを用いた可視化プロジェクト「Activation Atlases」のソースコードとデモページを公開したことを公式ブログに掲載した。

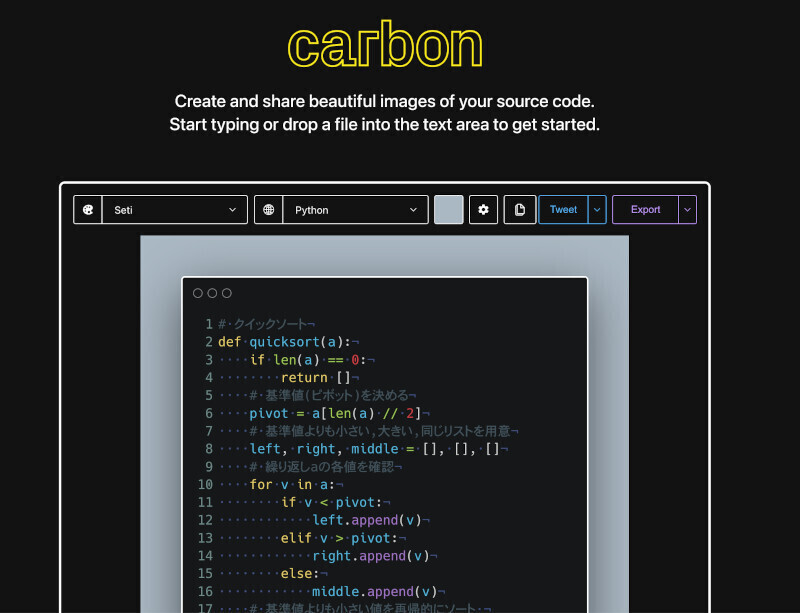

デモページには、ニューラルネットワークのモデルInception v1を用いて、大量の画像画像から抽出されるあたかも銀河のようなマップがWebアプリケーションの形で提供されている。スクロールして個々の写真を拡大していくと個別の画像が表示され、オンマウスで各物体の値がたとえば、desk(机)0.07、printer(プリンター)0.06、submarine(潜水艦)0.06のように特徴の比率を表示する。

Googleの研究者と共同で開発したという「Activation Atlases」は、異なる学習を行う数百万のデータから似たものを2Dで配置、グリッドで区切り各セルの平均をビジュアライズしている。多くの実績を残しているニューラルネットワークがとかくブラックボックスになるという指摘に応えようとする試み。寄稿者のChris Olah氏とLudwig Schubert氏は、ニューラルネットの中で起きていることを把握することは難しいことを強調している。

モデルやリソースが弱ければ人による攻撃も可能だが、「Activation Atlases」を使えば人間の目による気付きが可能になるとフライパン(frying pan)と中華鍋(wok)の例を示している。人間はフライパンと言えば平たく、中華鍋は底が深い形状を思い浮かべるものだがデモは"麺"(noodles)がその分岐点に入ってくる。モデルが食べ物によって区分できることを学んだためだが、想定している答えとは異なることを人の目で把握できる。

両氏はGoogle研究者と共同でこの作業を行えたことを嬉しく思うと述べ、安全性関連の研究がAIの社会貢献に役立つと信じているとブログを結んでいる。