今回は、複数の人物が存在するシーン中で、どこのエリアが人々の注意を集め得るかを推定する、Social Saliency Predictionについて紹介します(参考文献: Park and Shi, “Social Saliency Prediction”, CVPR’15)。

Joint attention

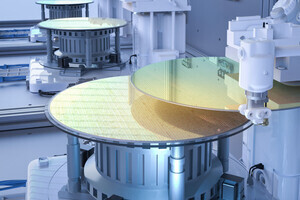

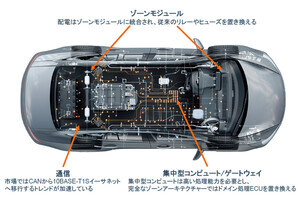

まずは、Social Saliency Predictionの関連研究について触れておきます(参考文献:Park, Jain, and Sheikh, “3D Social Saliency from Head-mounted Cameras”, NIPS’12)。この研究では、図1のように複数の人物が存在するシーン中で、全員がカメラを頭部に装着していることを前提として、複数の人物がどのエリアを同時に見ているか(Joint Attentions、Gaze Concurrences)を推定する手法を提案しています。各カメラから得られた画像系列を入力とし、SfM(Structure from Motion)の技術を用いて各カメラの位置、姿勢を求めます。その結果から、図2のように3次元空間中のどのエリアを同時に見ているかを推定できます。

|

|

図1 “3D Social Saliency from Head-mounted Cameras”の概要 |

図2 複数のHead-mounted Cameraを用いたJoint Attentionの推定結果 |

Social Saliency Prediction

先に述べた複数のHead-mounted Cameraを用いたJoint Attentionの推定結果を学習データとして用い、人の位置とJoint Attentionの関係性を学習します。具体的には、人物間の相対的位置を特徴量とし、Joint Attentionとの距離が閾値以内の位置をPositive、閾値以上の位置をNegativeとして、2クラスのアンサンブル分類器を学習します。

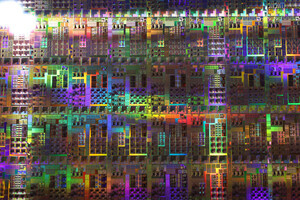

Joint Attention推定時は、1台のHead-mounted CameraからSfMを用いて複数の人を検出し、位置を求めます。そして、その複数の人の位置を入力として、学習済みの分類器を用いてJoint Attentionを推定します(図3、動画1)。この手法では、検出した人の視線方向、頭部の方向を求める必要はなく、位置のみからJoint Attentionを推定することができます。画像中から人を検出し、視線方向または頭部の方向を求めることは技術的には可能ですが、安定かつ高精度に求めることが難しいため、位置のみから推定できるというのは大きなメリットです。

<動画1 Social Saliency Predictionの結果>

学習には複数のHead-mounted Cameraを用いていますが、実際にSocial Attentionを求めるときは1台のカメラのみあれば推定できます。店舗内の人の注視領域の推定など、いろいろ応用できるかもしれません。

著者プロフィール

樋口未来(ひぐち・みらい)

日立製作所 日立研究所に入社後、自動車向けステレオカメラ、監視カメラの研究開発に従事。2011年から1年間、米国カーネギーメロン大学にて客員研究員としてカメラキャリブレーション技術の研究に携わる。

日立製作所を退職後、2016年6月にグローバルウォーカーズ株式会社を設立し、CTOとして画像/映像コンテンツ×テクノロジーをテーマにコンピュータビジョン、機械学習の研究開発に従事している。また、東京大学大学院博士課程に在学し、一人称視点映像(First-person vision, Egocentric vision)の解析に関する研究を行っている。具体的には、頭部に装着したカメラで撮影した一人称視点映像を用いて、人と人のインタラクション時の非言語コミュニケーション(うなずき等)を観測し、機械学習の枠組みでカメラ装着者がどのような人物かを推定する技術の研究に取り組んでいる。

専門:コンピュータビジョン、機械学習