米OpenAIは11月6日(現地時間)、米サンフランシスコで開発者カンファレンス「OpenAI DevDay」を開催し、大規模言語モデル(LLM)「GPT-4」の新世代版「GPT-4 Turbo」と、「GPT-3.5 Turbo」の更新版を発表した。

GPT-4 Turboは、コンテキスト・ウィンドウが128kに拡大され、2023年4月までの新しい情報に対応し、そして運用コストの削減を可能にする。6日からAPIプレビューを通じて、開発者が利用可能になる(モデルを「gpt-4-1106-preview」として呼び出す)。

コンテキスト・ウィンドウはモデルが1度に処理できるテキストの量を指し、その規模が長くなることで、モデルはより長い会話や文書を記憶し、参照できるようになる。GPT-4 Turboは、標準的な本の300ページ以上に相当する最大128,000トークンのコンテキストをサポートし、より長期間にわたる会話の文脈や指示を維持できる。それにより、GPT-3.5に比べて、長い会話でもテーマに沿った会話を保ち、指示に適切に従うことが可能になる。

ChatGPTが対応できる情報はLLMの学習データに依存し、従来のGPT-4は2021年9月までのデータで学習していたため、例えば「2023年のスーパーボウルで勝ったチームは?」というような最近の情報については回答できなかった。そのため、「Browsing with Bing」のような追加機能の使用が必要だった。GPT-4 Turboは2023年4月までのデータを学習しており、GPT-4よりも新しい情報への対応が可能。キーノートでサム・アルトマン氏(CEO)は「私たちは2度とこれまでのような時代遅れにならないよう努めます」と今後の継続的なアップデートを約束した。

春にGPT-4が登場した時にAI性能の向上が注目を集めた一方で、API料金が跳ね上がったことに開発者から不満の声が上がった。GPT-4 Turbo(128k)の1000トークンあたりの料金は0.01ドル(入力)、0.03ドル(出力)。GPT-4(8k)の0.03ドル(入力)/0.06ドル(出力)と比較して大幅に低コストで運用できる。

GPT-3.5 Turboの更新版は、16kのコンテキスト・ウィンドウをデフォルトとし、改良された命令実行、JSONモード、並列関数呼び出しをサポートする。OpenAIの内部テストでは38%の改善が確認されているという。開発者はAPIで「gpt-3.5-turbo-1106」を呼び出して新モデルにアクセスできる。12月11日にgpt-3.5-turboの名前を使用しているアプリケーションを自動的に新しいモデルにアップグレードする予定。

GPT-3.5 Turbo(16k)の新料金(1000トークンあたり)は0.001ドル(入力)/0.002ドル(出力)。これまでは0.003ドル(入力)/0.004ドル(出力)だった。GPT-3.5 Turbo(4K、16K)ファインチューニングは、0.008ドル(トレーニング)、0.003ドル(入力)/0.006ドル(出力)。

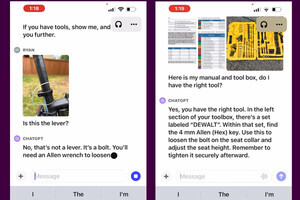

これらのほか、6日に画像生成AI「DALL-E3」、画像を入力として受け付ける「GPT-4 Turbo with Vision」(プレビュー)、新しいTTS(text-to-speech:音声合成)がAPIに導入され、開発者がマルチモーダルな機能をより活用できるようになった。また、オープンソースのスピーチ認識モデルの新版「Whisper V3」をリリースしており、これも近日中にAPIに組み込まれる。