7月2日未明から継続していたKDDIの大規模障害について、同社では5日夕方をめどに復旧宣言を行う意向を示した。現在はほぼ正常な状態に戻っているが、ユーザーの利用動向やネットワークの状況などをチェックし、最終的な判断を示す考えだ。

KDDIの障害報告では「音声通話・データ通信含め全国的にほぼ回復」と安全面に振った表現をしているが、基本的には正常運用できており、仮にまだつながりにくい端末があっても、再起動で復旧する模様だ。

これまでの経過

同社では障害発生(7月2日未明)翌日の3日に、髙橋誠社長らが障害の説明をしている。翌4日には復旧作業が完了し、復旧のめどが立ったことで、改めて現状について技術的な説明が行われた。

現在判明している障害の発生状況や影響回線数などは前日の時点から変わっていない。3日11時に西日本エリアで復旧作業が完了し、17時30分に東日本で復旧作業が終了。ネットワーク試験・検証の上で復旧とする計画だったが、内部では想定外の事象が発生していたという。

音声通話の復旧が遅れた理由

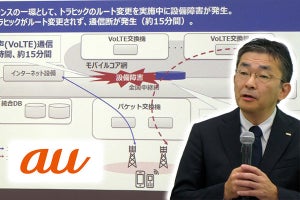

今回の障害ではVoLTE交換機の輻輳、加入者データベース(DB)の輻輳、加入者DBのデータ不一致という3段階の問題が発生。最終的にデータ不一致の解消でシステム負荷が落ちて解消に向かうことが想定されていた。これが3日の説明会の時点の状況だった。

ところが、作業が完了した後も負荷が落ちなかった。作業自体は完了して、データ通信が復旧したものの、この負荷によって音声通話の復旧が遅れた。そのため、4日午前7時には、サイト上に「流量制御などの対策を講じているため、音声通話がご利用しづらい状況が継続しております。」との文面を公表。水面下で原因の調査を行っていた。

その結果、同社が使う18台のVoLTE交換機のうち、6台が加入者DBに対して過剰な信号を送っていることが判明。加入者DBへのアクセス集中によって負荷が高まっていたため、4日12時18分〜13時18分までの間に、この6台をネットワークから切り離すことで過剰信号の送出を停止させた。

この結果、VoLTE交換機、加入者DBの負荷が正常に戻り、ユーザー端末の発着信成功率が向上。14時51分をもって、これまで行ってきた流量制御を解除した。これによって、基本的には正常通りの利用が可能になったことになる。現状で音声、データがつながりにくいという場合は、端末の再起動を行うと正常に戻るようだ。

とはいえ、このまま正常な利用が可能で、ネットワーク、トラフィックに問題がないかを確認するため、同社では5日夕方頃まで観測を行う。問題がないと判断すれば完全復旧とする、という。

携帯ネットワークにおける輻輳の問題の根深さ

このVoLTE交換機の過剰な信号がなぜ発生したかは、現時点で不明。それまでの問題だった3段階の障害が解消したことで顕在化した問題とのことだが、過剰信号の送出自体は、データ不一致の問題の中で起きた事象だという。ただ、この発生がいつ起きたのか、障害の最初のきっかけだったルーター故障に起因したものかなど、問題の原因は明らかになっていない。

現在は、切り離した6台を除く12台のVoLTE交換機でネットワークを構成。もともと冗長化などを踏まえた余裕のある設備容量で、問題なくネットワークが運用できるという。切り離した6台は原因調査を行い、問題を解決して復旧させる計画。

モバイルネットワークにおける輻輳の問題は根深い。2021年にはNTTドコモで大規模障害が発生。新設備切り替えで不具合が発生し、切り戻しを行ったところIoT機器が大量に信号を送ったことで、輻輳が発生して障害が長引いた。

KDDIはこれを教訓としていくつかの対策を実施。主にIoTを多く扱う認証系のシステムと電話系のシステムを分離する設計として、同様の問題を回避しようとしていた。さらにVoLTE交換機で輻輳が起きてもすぐに復旧できる手順と設計を検討していて、まさに今回の障害でも、この手順を行ったという。

ところが、この手順でも復旧できなかった。「想定よりも大きく、広くなった」(吉村氏)ということで、今後はなぜ復旧できなかったかの原因も究明していく。

携帯各社は、LTE初期の2011年頃にも障害を起こしており、その頃は音声の回線交換とデータのパケット交換という別の方式だった。現在はVoLTEとなり、「音声とデータが一緒になった」(同)ことで、ネットワークにおける処理が複雑になった。

今回の障害では、「復旧手順の中で、もう少しこのことを考える必要があったのではないか」と吉村氏。「今後も色々なサービスが複合的になり、(複雑になるので)そうしたものに対しての手順もしっかり考えなければならない」。吉村氏は個人的な考えとしてそう話す。

原因究明と再発防止策が急務

従来よりも複雑になったネットワーク運用の中で、さらにスマートフォンは常にネットワークに接続しようと動作するため、障害が発生すると輻輳の引き金にもなりかねず、今回の原因究明と再発防止策の検討は、KDDI1社にとどまらず重要になってくるだろう。

KDDIは障害の復旧に全力を注いできたということで、原因究明はこれから。障害のきっかけとなったルーター交換においては、輻輳の発生なども考慮してシミュレーションを実施、バックアップも用意した上での作業だったが、想定を上回る問題が発生し、長期間にわたる障害を発生させてしまったという。

完全復旧が5日夕方となると障害発生から80時間を超えることになる。このまま完全復旧ということになれば、次は原因究明と再発防止策の策定が急務となるだろう。髙橋社長が陣頭指揮を執って原因を明らかにした上で再発防止策につなげて、さらなる強靱なネットワークの構築を求めたい。