ネットアップは12月11日、都内で「NetApp Innovation 2019」を開催した。本稿では基調講演の模様をお届けする。

まず、始めに登壇したネットアップ 代表取締役社長の岩上純一氏は「昨今、データに関する企業の視点が急速に進化している。これまでのデータの保管・保護からクラウドの活用・最適化とマイクロサービス化により、データの利活用に取り組み、データを使ったマネタイズに結びつけなければならない。そのためには、より高度なデータ管理環境が必須となり、企業のデジタルトランスフォーメーション(DX)は必要不可欠だ」との認識を示す。

これを受けて、米NetApp Senior Vice President ONTAP Data ServicesのBrendon Howe氏は「DXにより、すべてが変化し、そのインパクトがわれわれにも及んでおり、これは継続して今後も起こるものだ」と述べた。

同社によると、組織としてデータを中心に事業を進めていくことは難しく、すべての側面が変化しており、さまざまなサービスがクラウドで展開されることで変化が加速しているからだという。近年では生成された大量のデータを活用し、多様なサービスが提供されていることから、デジタル変革の基盤はデータとなっており、データの成長に伴う課題は多様なサービスに対応しなければならないという。

デジタル変革に対し、同社ではクラウド利用によるイノベーションを促進する「Inspire」、クラウド利用を加速して新しいサービスを実現する「Build」、クラウドと連携するフラッシュとITアーキテクチャを提供する「Modernize」の3つの柱をベースにアプローチしている。

そこで、同社はこれら3つの柱を基づいた製品として、主要なパブリッククラウド上にサービスをデプロイ、実行、監視、管理、維持するために「NetApp Cloud Data Services」を提供している。これはAmazon Web ServicesやMicrosoft Azure、Google Cloud Platform、プライベートクラウドなど、主要クラウド上にクラウドデータサービスを各ユーザーのニーズに合わせて利用することを可能としている。

クラウドサービスを考える上で同社は「クラウドストレージ」「データサービス」「オーケストレーション、インテグレーション、コントロール」「クラウドアナリティクス」の4つの階層を構築している。

そして、これらの階層によりクラウドに関する4つのイニシアティブをカバーしており、従来のワークロードをパブリッククラウドに拡張する「Cloud Volumes ONTAP」、既存のプライマリワークロードを展開する「Cloud Volumes Service」プライマリワークロードの構築とリファクタリングとアプリケーションを構築する「NetApp Kubernetes Service」、オンプレミスとワークロードの監視を行う「NetApp Cloud Insights」を備える。

特に、同氏はCloud Volumes Serviceを重点的に説明した。同氏は「簡単にわれわれのストレージサービスをパブリッククラウドで走らせることが可能だ。迅速にプロビジョニングできることに加え、スパイクが発生するようなアプリケーションの変更も容易にできる」と説く。

続いて、登壇した米NetApp Senior Technical DirectorのSantosh Rao氏は、同社製品のAIとディープラーニングについてプレゼンテーションを行った。

同氏は「AIは、さまざまな状況で戦略的に採用されており、APACはAIとディープラーニングのハブになると言われている。ディープラーニングは、GPUベースのシステムと新しいアーキテクチャにより、データから学習し、ニューラルネットワークベースのデータサイエンスを提供する」と説明した。

データそのものが鍵であり、データが増加すれば増加するほどインサイトの精度が向上するという。そして、近年AIはヘルスケア、製造、通信、政府機関/防衛、金融、小売など、さまざまな業種に広がりを見せている。

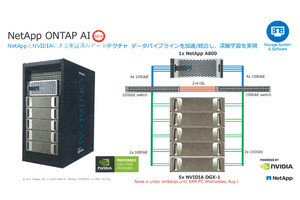

同社では、AIの活用が進む状況下において8月に発表したNVIDIAの深層学習向けサーバ「DGX-1」とクラウド対応オールフラッシュストレージ「NetApp AFF A800」を基盤とする実証済みアーキテクチャ「NetApp ONTAP AI」を提供している。

Rao氏は「コンバージドされた実証済みのプラットフォームであり、企業のAI/ディープラーニングの展開を可能とし、シンプルでデプロイしやすい集約型ソリューションだ。これにより、複雑さを解消し、推測による構成作業を排除するほか、小規模構成からのスタートでき、システムの停止なしで拡張を可能としており、エッジからコア、クラウドまでのデータパイプラインを統合できる」と、アピールする。

オプションとして、既存のファイルシステムのデータなどを移行することを可能とするほか、ディープラーニングに取り組む際にONTAPにデータを実装・導入するだけでデータコピーを取らずに実現できるという。また、モデルトレーニングのためにコールドデータ階層からのデータ移動やStorageGRIDからデータを移行することが可能なことに加え、データとGPUをパブリッククルドにプロビジョニングできる。

従来型の機械学習はCPUのクラスタが数百ノードまで拡大し、コンピューティングのスプロール現象やデータの過剰コピー、階層化機能がないといった課題を抱えている。しかし、ONTAP AIでは、例えばHadoopの既存データをNFSのフォーマットに変換させることができるため、機械学習とディープラーニングの橋渡しをすることを可能としている。

最後に、Rao氏は「DXやAIのプロジェクトには大量のデータとともに、高いパフォーマンスが必要となる。そして、ファイルシステム、オブジェクト、非構造化データがあり、エッジ、コア、クラウドのパイプラインのカバーも必須だ。われわれのソリューションによりDXとAIのプロジェクトに必要となるものに加え、ストレージの効率化とキャパシティを提供できる」と胸を張っていた。