Armは、Arm CPU 上での次世代アプリケーションによる大規模言語モデル(LLM)の実行を可能にするため、Arm® KleidiテクノロジーとPyTorch およびExecuTorchとの統合を発表しました。Kleidi は、最新の開発者支援技術と重要リソースを組み合わせることで、ML スタック全体で技術的なコラボレーションとイノベーションを推進しています。これらを通じて、Arm は現在、ML スタック内のあらゆる環境で可能な限り円滑な開発者体験の実現に取り組んでいます。

ポイントとしては、以下の3つが挙げられます。

- Kleidi テクノロジーを PyTorch および ExecuTorch と統合することで、Arm は AI パフォーマンスの重要な利点をエッジからクラウドまで拡大、Arm CPU 上で大規模言語モデルを実行する次世代のアプリケーションを実現

- ML ワークロードの民主化に対する継続的な投資により、開発者はスタック全体で最新の生成 AI モデルを採用し、大幅に向上した推論パフォーマンスを直ちに活用可能に

- クラウドサービスプロバイダーや ML ISV コミュニティの主要企業とのコラボレーションを拡大し、あらゆるAI開発者への支援を強化

これらの特長から、開発者はどのようなメリットを享受できるのでしょうか。

主要フレームワークとの統合を通じて、クラウドの重要なメリットを実現

クラウド環境における Kleidi は、Arm Compute Libraries(ACL)を通じて PyTorch を強化するという Arm のこれまでの取り組みを基礎に、あらゆる環境で Arm ベースの AI を最適化するための青写真を確立しています。Arm は、開発者が不要なエンジニアリング作業を自ら行うことなく、重要な ML ワークロードを実行するためのプラットフォームとして Arm を採用することを望んでいます。こうしたビジョンの実現に向けた重要な一歩として、Arm は PyTorch および TensorFlow 直接提携し、Arm の必須カーネルで構成される Arm Kleidi Libraries をこれらの主要なフレームワークに直接統合しました。

最新版フレームワークが公開された場合、アプリケーション開発者は現行のArm環境で追加の構築作業を強いられることなく、直ちに、そして自動的に、パフォーマンスの大幅な向上という重要なメリットを享受できます。今回の投資に関して、すでにパートナーシップ面で次のような成果が確認されています。

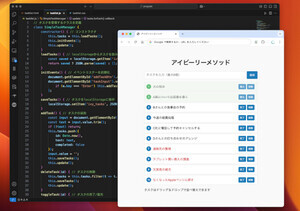

- Meta Llama 3 大規模言語モデルを採用し、AWS Graviton プロセッサー上で動作するArm のデモ用チャットボット により、メインラインの PyTorchで初となるリアルタイムのチャット・レスポンスが実現

- Kleidi テクノロジーをオープンソースの PyTorch コードベースに統合した後の最初のトークンまでの時間は、AWS Graviton4 による測定値で2.5倍高速化

- torch.compile に最適化機能を導入し、ACL を通じて提供される Kleidi テクノロジーを効率的に使用することで、Hugging Face の一連のモデル推論ワークロードのパフォーマンスは、AWS Graviton3 による測定値で 1.35~2 倍向上

クラウドにおけるこれら2つの特筆すべき事例は、Arm 環境の ML ワークロードの民主化に取り組む上で、想定されるパフォーマンス・アクセラレーションの模範となるものです。新機能を前方互換とすることで開発者が直ちに活用できる体制を整えるなど、クラウドからエッジに至る Arm テクノロジー上で、開発者の AI アプリケーションが最適に動作できるよう Arm は投資を継続しています。

協業を通じて、生成 AI に対応する開発者を支援

生成 AI は AI のイノベーションに波状効果を起こしており、最新の言語モデルは異例のスピードで公開されています。AWS や Google などのクラウドサービスプロバイダーや、Databricks などの急成長中の ML ISV コミュニティなど、ML スタックのすべての主要関係者と緊密に協業することで、Arm は最先端の開発環境の提供に努めています。

Google Cloud Compute のプロダクトマネジメント担当シニア・ディレクターである Nirav Mehta 氏は、次のように述べています。「Armと Google Cloud はいずれも、開発者がより簡単・迅速に AI を活用できる環境の構築に取り組んでおり、AI ニーズに応じたハードウェア/ソフトウェアの最適化を共同で推し進める上で Kleidi は大きな一歩です。当社の Arm ベース・カスタム CPU である Axion の採用が進む中、今後は ML スタック全体でのよりシームレスな統合を通じて顧客を支援していきます」

Databricksのソフトウェア・エンジニアである Lin Yuan 氏は、次のように述べています。「ML ソフトウェアスタック全体で Arm Kleidi の統合がもたらすパフォーマンスの最適化は、AI/ML ワークフローで Databricks Data Intelligence Platform を活用する企業にとってメリットとなります。Databricks ML Runtime クラスターがサポートする Arm ベースの AWS Graviton プロセッサーにより、企業はクラウドサービスプロバイダーのコストを削減しつつ、幅広い ML ライブラリで高速化のメリットを享受できます」

Arm の提供ソースを実環境のユースケースで活用できることは開発者にとって重要であるため、Arm は学習経路に即したデモンストレーション用ソフトウェアスタックを作成することで、Arm CPU 上で AI ワークロードを構築する正確な方法を開発者に示しています。これにより、Arm システムでの迅速な導入が促進され、開発者のデプロイ時間が短縮されます。こうしたスタックの最初の例として、Kleidi テクノロジーによって高速化したチャットボットの実装事例をこちらで紹介しています。年内にはこうしたユースケースに ML Ops と検索拡張生成を追加するほか、2025 年にはユースケースのさらなる拡大を予定しています。

エッジでのパフォーマンスを引き続き向上

エッジでの Kleidi の勢いに乗じて、KleidiAI は今後、PyTorch の新たなオンデバイス推論ランタイムである ExecuTorch に統合されます。統合の完了は 2024 年 10 月を予定しており、ExecuTorch で現在本番テスト中またはロールアウト中のアプリケーションを対象に、エッジデバイスに魅力的なパフォーマンス向上を提供します。統合の完了時には、エッジデバイスのパフォーマンスに及ぼす影響について、さらなるデータと詳細情報を公開する予定です。

さらに、 GoogleのXNNPACKとMediaPipe、TencentのHunyuan 大規模言語モデルなど、Arm はすでに KleidiAI の統合機能を多数発表しています。実環境のワークロードに対する影響については、チャットボットのデモをご覧ください。

PyTorchとExecuTorch の両リリースへの統合に加えて、他のすべての主要 AI フレームワークへの Kleidi の統合が継続することで、開発者は今後、クラウド・データセンターからエッジデバイスに至る広範なデバイスを対象に、Arm 環境で効率的かつ高性能な AI ワークロードを直ちに実行できます。Arm は引き続き、PyTorch コミュニティ向けの強化機能の導入を積極的に進めていきます。今後の展望としては、さらなる性能向上を解き放つため、さまざまな整数形式向けの量子化の最適化に尽力していきます。こうした取り組みにより、Arm CPU 上ではシームレスかつ大規模に実行される次世代の AI 体験が実現します。

開発者の能力向上を今後も支援

PyTorch は現在、ML 開発の分野で膨大なイノベーションを牽引しています。そして、Arm および同社の AI ジャーニーにとっての画期的な出来事として、PyTorch Foundationは最近、Arm がプレミアムメンバーとして同団体に参加したことを発表しました。Arm 環境でエンドツーエンドな AI の可能性を最大限に引き出すことで、最先端の AI/アプリケーション機能を開発できるよう、Arm は今後も世界中の開発者を支援していきます。

※本資料は、英Armが英国時間2024年9月16日に公開したブログ記事の抄訳です。

[PR]提供:アーム