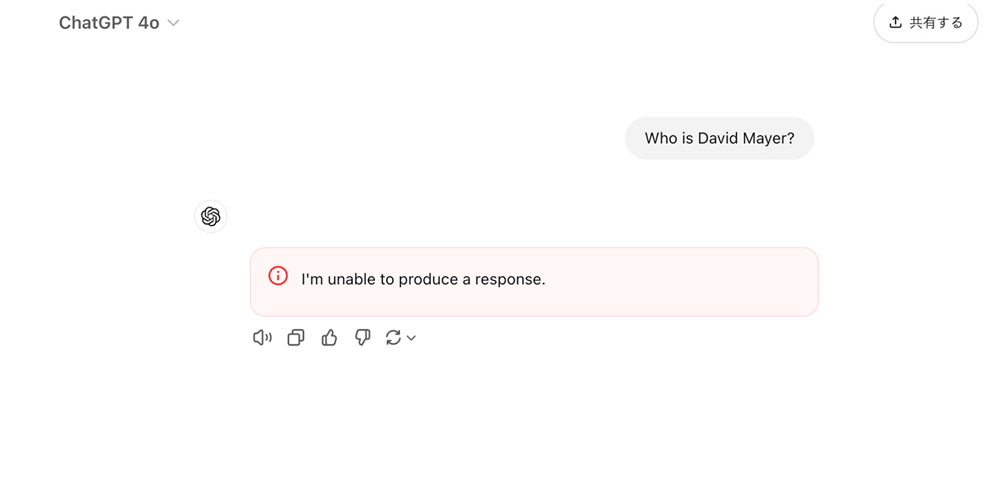

先週、ChatGPTが「David Mayer」という名前の入力に対し、一切の応答を拒否するという現象がネット上で注目を集めました。実際に試してみると、エラーメッセージが表示され、チャットセッションが強制終了してしまいました。「利用ポリシー違反の可能性あり」という警告が表示されるケースもあったそうで、この奇妙な動作(厳しいフィルタリング)に、多くのユーザーが注目し始めました。「テックトピア:米国のテクノロジー業界の舞台裏」の過去回はこちらを参照。

禁忌リストに含まれている理由は判明せず

ChatGPTをはじめとする対話型AIには、安全性を確保するために不適切な質問や内容に応答しない仕組みが組み込まれています。例えば“爆弾の作り方”など、倫理的に問題のあるリクエストが典型的な例です。

しかし、無害に見える“David Mayer”という名前が禁忌リストに含まれている理由が分からず、多くのユーザーが謎解きに興じました。「David Mayer」とは何者なのか。ネット上で「The Hunt For David Mayer」が展開され、さまざまな憶測が飛び交いました。

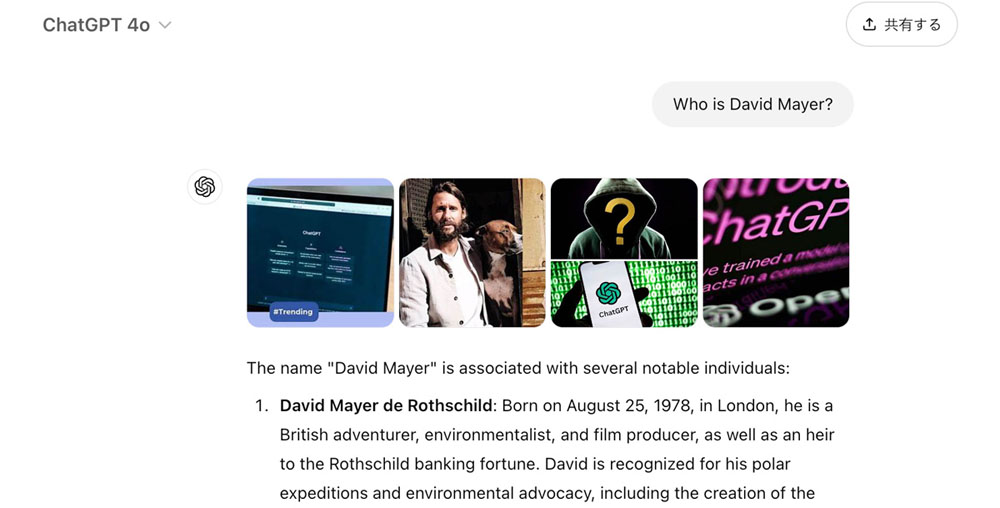

Googleで“David Mayer”を検索すると、トップに表示されるのはデビッド・メイヤー・ド・ロスチャイルド氏です。英国の冒険家、環境保護活動家、映画プロデューサーであり、そしてロスチャイルド財産の相続人です。危険な人物ではありませんが、陰謀論の文脈でフィルタリングされた可能性があります。

今回の話題をきっかけに、ChatGPTが拒否する名前として他にも「Brian Hood」「Jonathan Turley」「Jonathan Zittrain」「David Faber」などが確認されています。その中には、過去にChatGPTによるハルシネーションで風評被害を受け、自らの名前をフィルタリングするよう要求した人物もいます。

そのため、“David Mayer”についても本人の申請による可能性が取り沙汰されていますが、少なくともロスチャイルド氏に関しては、同氏がChatGPTに接触したことはないと関与を否定しています。

さらに、もう一人の有力候補として、故デビッド・メイヤー教授の名前が挙げられます。彼は米国系英国人の演劇史家ですが、過激派が彼の名前を偽名として使用していたため、誤って安全保障リストに掲載され、米国への入国が一時的に制限された過去があります。このため、メイヤー教授に対する誤解を避けるための措置が取られた可能性も考えられます。

結論はと言うと、OpenAIはこの問題が話題になってから数日後に“David Mayer”のブロックを解除しました。ブロックされていた理由について一切コメントしておらず、原因は謎のままです。

アンラーニング、LLMに忘れさせることの難しさ

今回の一件は、対話型AIが将来の検索ツールとして期待される一方で、未解決の課題が多いことを浮き彫りにしました。

「David Mayer」問題が急拡散したのは、いかにも多くいそうな名前がフィルタリングされたからでしょう。実際、多くの「David Mayer」が存在し、それが推理を面白くしました。

しかし、考えてみると、名前でブロックするのはなんとも奇妙な対策です。仮にChatGPTがメイヤー教授の風評被害を避けたかったとして、それならメイヤー教授を過激派のアフメド・チャタエフに結びつける対話のみ拒否するだけで十分なはずです。

でも、現在の技術でその対応は難しいのです。大規模言語モデル(LLM)は膨大なパラメータを持ち、学習した知識はパラメータ全体に分散されています。知識は相互に関連しており、一部の情報を変更すると他の関連情報にも影響を与える可能性があります。

モデルから特定の情報を削除するには、モデルを完全に再構築するか、そうでなければ名前ごとフィルタリングするような強力な禁忌を講じることが安全な対策となります。

1年前にMicrosoftが「Who's Harry Potter? Making LLMs forget」という研究成果を公開しました。Llama-2モデルを使って、LLMを再構築することなく、追加学習のみで、ハリー・ポッターの本の詳細を忘れさせる(生成させなくする)ことに成功したという報告です。

LLMから特定の知識を「忘れさせる」技術、いわゆる「アンラーニング」は不適切な幻覚や著作権侵害の防止など多方面で重視されており、Microsoftの発表は注目を集めました。それから1年でさらに研究は進んでいますが、現時点で完全な実現には至っていません。

アンラーニングの結果、削除対象の情報と関連する一般的な知識まで失われたり、逆に、アンラーニングしてもモデルが元の情報を再度思い出してしまう「Un-Unlearning」という現象も報告されています。

「David Mayer」をはじめ、フィルタリングされている名前がいくつも存在するのは、アンラーニングの難しさを示しています。

今回の例では、OpenAIがブロック解除で迅速に解決できたため大きな問題にはなりませんでしたが、誤認識や誤った行動により他者が損害を受けるケースが発生する可能性があります。

名前のフィルタリングでは、1人の「David Mayer」だけが消去されるのではなく、すべての「David Mayer」に影響が及びます。将来の「David Mayer」問題では、プライバシー保護を求めるデビット・メイヤーに対して、記憶される権利を求めるデビット・メイヤーが出てくるかもしれません。

「David Mayer」問題は小さなエラーにとどまらず、プライバシーやアイデンティティの保護、AI設計の透明性、倫理、社会的影響といった複雑な課題を浮き彫りにしています。それは、私たちがいかにAIと共存し、制御するかという課題の一部なのです。