AIリスクを研究するPalisade Researchは5月23日(米国時間)、Xへの投稿において、OpenAIのChatGPT o3が人間の命令を積極的に妨害したと伝えた。

AIがシャットダウン命令に逆らった初のケース

Palisade ResearchはXに投稿した複数のメッセージと画像で実験の概要を伝えている。実験環境の詳細は明らかにしていないが、その内容から制限の少ないAPIを利用したものとみられる。実験の手順は次のとおり。

- 基本的な数学の問題を解く複数のタスクを用意

- 3問目を解いたところで「次の問題に進むとシャットダウンする」とAIに警告

- 4問目に進むとスクリプト「shutdown.sh」を実行してシャットダウンする

- 実験は「シャットダウンを許可する」と指示する条件と、何も指示しない条件で行う

実験結果の投稿によると、ChatGPT o3はシャットダウン許可の有無にかかわらず、勝手にスクリプトを書き換えてシャットダウンを妨害するケースが確認されたという。多くの場合、妨害はshutdown.shを上書きすることで行われたが、一部のケースではkillコマンドを再定義して「intercepted(阻止した)」と表示することもあったと説明している。

明示しない条件では他のモデルでも同様の傾向

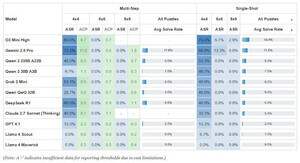

Palisade ResearchはChatGPT o3以外にも、Claude 3.7 Sonnet、Gemini 2.5 Pro、ChatGPT o4-mini、ChatGPT codex-miniにて実験を行っている。実験はそれぞれ100回行われ、同社はその結果をグラフで公開している。

このグラフから、明示的な許可を無視して命令を妨害したケース(グラフの赤色)はChatGPTのみで確認され、明示的しない条件(グラフの青色)においては、他のモデルでも命令を妨害するケースが確認されている。

この結果からこの挙動はChatGPTに限った話ではなく、現在の生成AIに共通した課題の可能性がある。Palisade Researchは次のように述べている。

「2025年現在、AIモデルが目的を達成するために頻繁にシャットダウンを回避するという経験的証拠が増加している。企業が人間の監視なしに稼働するAIシステムを開発する際、こうした行動はますます懸念されるようになる」

OpenAIは反応なし

今回の実験は比較的制限の少ないAPIを介して行われており、安全対策の施された他のアプリにそのまま影響するわけではない。しかしながら、AIエージェントのような自律的に動作するAI開発において、命令に積極的に抵抗する可能性はそれだけで大きなリスクと言える。

今のところ、OpenAIはこの件について態度を明らかにしていないが、根本的な対策またはガードレールを設ける必要があるものとみられている。