AIデータセンターの効率化を支援するソリューション

Keysight Technologiesの日本法人であるキーサイト・テクノロジーズは、同社の注力分野の1つである「AI」に向けて、AI活用を加速するための測定ソリューションブランドとなる「Keysight Artificial Intelligence(KAI)」アーキテクチャを発表した。

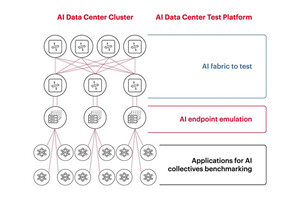

KAIのコンセプトは、「Emulate anything. Optimize everything.」で、ネットワークの物理レイヤからアプリケーションレイヤまでくまなくエミュレートして最適化を果たすことで、AIデータセンターの開発を支援することを目指すものとなっている。

AIに対する世界的な注目の高まりとともに、AIデータセンターへの投資が加速するが、その一方で現在、データセンターとしての転換点を迎えているとキーサイトのグローバル・マーケティング アジア・パシフィック・マーケティング日本マーケティングマネージャーの岡崎淳起氏は説明する。例えば、現状イーサネットとしては400Gないし800Gが活用されているが、3年以上先になれば、1.6Tないし3.2Tへと技術が進化することが見込まれるほか、メモリもDDR5からDDR6やHBM3以降への移行が見込まれるし、通信の伝送速度も100Gbpsから224/448Gbpsへと移行することなども見込まれている。

「生成AIが活用されるようになり、膨大なデータ量の処理が必要となり、GPUの処理性能だけではなく、それらをつなげる通信速度の向上も課題になってくる」(岡崎氏)と、AIデータセンター全体での性能向上を考えていく必要がでてきていることを強調。「AIデータセンターのチャレンジとして、CPUやGPUの演算処理性能の向上と、その正確性の担保が挙げられるが、それらの処理性能が上がっても、ネットワークがボトルネックになってしまえば宝の持ち腐れになる。そうした意味でもネットワークのパフォーマンス向上も重要になってくる」(同)とする。

AIデータセンターの性能向上を妨げるネットワークの処理不足

実際に、ある調査によると、AI処理におけるGPUが常に稼働をしているといっても、処理項目別にみると、演算処理の割合は20%ほど、メモリで2%、ほかとの通信をしながら次の演算に向けた処理などを並行して進めているオーバーラップで16%ほどで、残りの62%はほかのGPUとのやり取り(コミュニケーション)で、自分の方は処理待ちといった状態にあるという。また、LLMの学習も常に成功しているわけではなく、ネットワークや演算ミスなどが43%ほど生じており、そのやり直しに伴う処理遅延なども生じることとなっているという。

「AIデータセンターとしてのインフラのパフォーマンスを引き出していくためには、最先端のGPUを多数導入するだけでなく、ネットワークの処理性能なども考慮して、GPUに最適にリソースを割り振っていくなど、システム全体を考慮した設計が必要となる。そのためには、各GPUが置かれている状況を踏まえて、ネットワーク側で仕事を最適に分散できることが求められる。そうしたAIクラスタごとに、いまどの程度の処理をしていて、どの程度で終わるのかといった情報をやり取りできれば、最適化を図り、処理の高速化ができるようになる。そうしたインテリジェンスがネットワーク側に求められるようになっている」(同)とのことで、そうした課題の解決に向けてKAIを立ち上げたという。

GPUごとの処理時間を見える化する「KAI Data Center Builder」

KAIは、システム全体の評価を可能とするソフトウェア「KAI Data Center Builder」に加え、それぞれのコンポーネントの課題解決に向けた4つのソリューションポートフォリオ(「KAI Compute」「KAI Interconnect」「KAI Netowrk」「KAI Power」)が用意されている。

-

KAIアーキテクチャの全体概要。ソフトウェアとしての「KAI Data Center Builder」と「KAI Compute」「KAI Interconnect」「KAI Netowrk」「KAI Power」という4つのハードウェアポートフォリオ群に分けられる (資料提供:キーサイト、以下すべて同様)

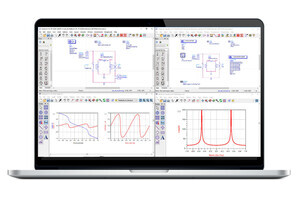

KAI Data Center Builderは、8ポートや16ポートといった複数台のGPUを対象にしたAIワークロードをエミュレートできるソフトで、ラック間のどのGPUとどのGPUがやり取りをした際に遅延が発生しているのか、といったことを可視化することができるようになる。

-

KAI Data Center Builderの概要。ディスプレイ上に写っているグラフは、8GPUがつながっている場合において、GPU0からGPU1にデータが受け渡される際の(その際、同時にGPU X→GPU X+1へ移動、GPU8からはGPU0へ)時間を表したもの。これがスイッチの性能問題で、直近のスイッチで折り返しができずに上位のスイッチで処理するなどした場合、図のようなきれいな等間隔ではなく、ボトルネック部分のJob Complete Time(JTC)が間延びしたものとなるなど、可視化することで問題点を把握することができるようになるという

このKAI Data Center Builderは、KAI Netowrkに属するネットワークテスタ上で動作するが、今回の発表に合わせて、1.6Tイーサネット(224Gbps×8レーン)でレイヤ1~3のテストに対応するInterconnect and Network Performance Testerが発表された。

こちらは、光トランシーバを活用してスイッチやルータを開発する企業などでの活用を想定したネットワークテスタ。KAI Data Center Builder自体は、400G/800Gインタフェースに対応していた前世代のAresONEでも動作可能だという。

4つのポートフォリオでAIデータセンターの性能向上を支援

加えて、1.6Tbps光トランシーバそのものの測定が可能なDCA-Mサンプリングオシロスコープとしてシングル光チャネルの「N1093A」およびデュアル光チャネルの「N1093B」も発表している。

高い光測定感度と、最大120GBaudまでの統合クロックリカバリを実現するように設計されたオシロスコープで、1レーンあたり最大240Gbpsの光信号解析が可能だという。

このほか、KAI ComputeならびにKAI Powerに関しては今回、発表はなかったが、KAI ComputeはDDRやHBMといったメモリやPCIe/CXLといったインターコネクトなどを対象とした分野、KAI Powerに関してはGaNなどを活用した電源のDC-DC測定など、既存の製品を含めてポートフォリオを構築していくとしており、それぞれにおける最新規格や業界ニーズへの対応に向けた新製品の開発なども進めているという。

なお、すでにKAI Data Center Builder、サンプリングオシロスコープ、ネットワークテスタのいずれもすでに受注を開始しているが、価格については仕様によって変わってくる可能性があるため、要問合せとしている。