国内外を問わず、LLM(Large Language Models:大規模言語モデル)の開発が日進月歩で進められている。応答の正確性やモデルサイズ、マルチモーダルな機能など、特徴は千差万別だ。近年デジタルサービスの提供を強化するリコーも、LLMの研究開発に注力するうちの一社。同社はこれまでに、130憶パラメータや700憶パラメータなど複数のモデルを発表している。

ところで、リコーといえば、やはり複合機をはじめとするOA(Office Automation)機器を中心に、オフィス業務を支援するハードウェアやサービス展開のイメージが強い。そこで今回、リコーが手掛けるLLMについて、開発の背景やリコーならではの強みについて取材した。

「知識創造」を目指すリコーのAI開発を振り返る

リコーはドキュメントの検索性能向上やOCR(Optical Character Recognition / Reader:光学文字認識)の高度化を目的として、1990年代から現在のAI開発につながる研究開発を行っていた。しかし、当時は第2次AIブームも落ち着いたころで、いわゆる「冬の時代」とされる時期だ。

次なる転機は2010年代、ディープラーニングの発明に端を発する第3次AIブーム。このころから、リコーの研究組織においても言語解析や画像解析に本格的に取り組み始めたという。2018年に発表されたBERT(Bidirectional Encoder Representations from Transformers)などの技術により、同社の強みであるドキュメント処理が高度化し始めた。

リコーのデジタル技術開発センターで所長を務める梅津良昭氏は、「当社の柱となる事業で扱ってきたドキュメントの活用を、AIによって進化させたかった。ドキュメントの作成や検索だけでなく、過去に蓄積したドキュメントを使って新しい企画を生み出すなど、『知識創造』とも呼ぶべき技術を作りたかった」と、当時を振り返った。

生成AIが広く一般的になる前、2020年7月に米OpenAIがGPT-3を発表。リコーも同モデルのベータ版を研究開発に利用していたそうだ。しかし同社が知識創造のために求める日本語性能は満たしていなかった。

そこでリコーは、オープンソースの英語モデルをベースとしながら高い日本語性能を持つLLMを国内で提供するための研究開発を開始したとのことだ。将来的には、顧客対応や資料作成など業務での活用が可能なAIエージェントの構築を目指す。現在は、少しずつ業務で使える機能を追加している段階とのことだ。

梅津氏は「LLMの開発は、2023年の春くらいまでは社内でもメインストリームではなかった。生成AIがなんとなくすごそうというのは少しずつ知られるようになっていたが、本当に自社で開発できるのか、疑問視されていた」と語る。研究チームは試行錯誤の連続だったという。

最も苦労したのは、AIエンジニアリング。特にクラウド上で多量のGPUを稼働させる工程だった。同社の研究チームには大学院などのアカデミアで経験を積んだ人材が多く、クラウド上で高速な学習に最適な環境を構築することに慣れていなかったそうだ。AI学習に適したストレージの選定や効率的な死活監視など、研究ベースの開発から産業化に向けた開発へと改善を繰り返した。

リコーならではのLLMの強みと特長

日本語に特化したLLMを手掛ける企業は、大きく2つのタイプに分けられる。まずは、フルスクラッチでゼロから独自の日本語LLMの構築を目指す企業。もう一つは、Llamaシリーズのような海外製のオープンソースモデルを日本語でチューニングし国内向けに提供する企業だ。リコーのLLMは後者に当たる。

「海外ベンダーが提供するモデルは、数カ月に1回ほどのペースでアップデートされる。このモデルをベースとして日本語性能が高いモデルを構築できれば、非常に早くコンスタントに当社のLLMを提供できる」と、梅津氏はその戦略の狙いを語った。

海外の大手ITベンダーが提供するモデルは、追加の学習計画を立てやすいというメリットもあるそうだ。

そうした中で、リコーは日本語に特化したトークナイザーにこだわりを持っている。これにより、海外製のモデルであっても日本語の語彙や表現をうまく扱える独自のLLMとしてチューニングしているとのことだ。リコーの中国の研究チームとも連携することで、アジア圏の言語に対応可能なLLMも強みとしている。

リコーが手掛けるLLMには特徴がもう一つある。それは、GPUを使わずにLLM専用のAIチップを用いて学習しているという点。これにより、汎用的なGPUを用いる場合と比較して約8割の時間とコストで学習を完了できるという。推論タスクにおいても低コストかつ短時間で応答するため、業務内での効率的なLLM活用を支援する。

同社がLLMを提供し始めてから、企業独自のLLMを構築して保有することの利点を訴えてきたそうだ。2024年7月に突如発表された「GPT-3.5 Turbo」の終了などに伴い、独自のLLMを社内で保有したいというニーズが高まっているという。ここに「リコーのLLMに企業独自のデータで追加学習して、自社ならではのLLMを一緒に構築できる」ことをメッセージとして打ち出している。

オンプレミスでのLLM導入も可能としているため、ユーザー企業が保有する既存のサーバなども活用しながら独自のLLMを保有できるようになるという。クラウドで提供されるモデルと比較して、急な仕様変更やアップデートに伴う互換性の確認などの手間が低減されるため、企業の業務で安定して使い続けるために社内にLLMを保有したいとするニーズに対応する。

今後の具体的なソリューション展開は?

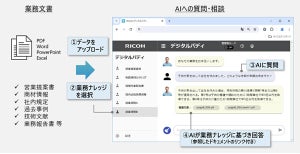

リコーは6月下旬、日々の業務をまるで相棒のように支援するAIサービス「RICOH デジタルバディ」の提供を開始した。取材時点では、その裏側のモデルにOpenAIやAnthropicが提供するLLMを採用しているという。今後は、これをリコー版LLMもしくはユーザー企業独自のプライベートLLMでも使えるように準備しているとのことだ。

デジタルバディは、単一のモデルを全社員が使うのではなく、部署や個人の業務に特化したバディをそれぞれ構築し、裏側では複数のLLMを使い分けながら業務を効率化できるようなサービスだ。

リコージャパンでAIソリューションセンターのセンター長を務める児玉哲氏は「まだお客様のAIの活用シーンや期待値が定まっていない状況なのですべての要望に対応できるかはわからないが、すでに個別対応でカスタマイズしたRICOHデジタルバディの提供を開始している。また、AIエージェントの相談も増えており、個別提供を開始している」と語る。

続けて、「AIエージェントについても、横展開できるものは今年度中にパッケージサービスとして広くお客様に提供していきたい」と筆者に明かした。

リコーは研究組織を持ちLLMを開発しているが、全国に展開する販売企業であるリコージャパンとのシナジーも強みとして活用する。AIソリューションの開発と販売を同じグループ内で手掛けているため、顧客業務の課題を深く理解し対応できるのだという。同時に、長年顧客のオフィス業務の効率化を支援してきたリコーグループならではのノウハウも取り入れる。

「当社はもともとAIやLLMの基盤技術を作る気はなく、あくまで人間の仕事をアシストするようなサービスを提供したいと考えている。パートナー企業による販売ではなくリコーグループが一丸となってお客様に提案することで、お客様の悩みをすぐに社内の研究チームやエンジニアにフィードバックできる強みもある。今後もユーザーの業務の手助けをして仕事の生産性を上げていくようなお手伝いができれば」(梅津氏)