NECは9月18日、LLM(Large Language Models、大規模言語モデル)の信頼性を向上するハルシネーション対策に関連する機能を10月末より順次提供開始すると発表した。これに先立ち、同日に都内で「BluStellarを支える生成AI×セキュリティ技術説明会」を開催し、同社のDX(デジタルトランスフォーメーション)事業における価値創造モデル「BluStellar」のキーテクノロジーの1つとして定義しているセキュリティ技術について説明した。

NECでは、生成AIのサイバーセキュリティへの応用と生成AI出現に伴う新たなリスクへの対策という2つの観点からセキュリティ技術の研究開発に取り組んでおり、今回の説明会では新技術を含めたセキュリティ関連技術についてデモを交えて紹介された。

生成AIがもたらす新たなセキュリティリスク

最初に登壇したNEC セキュアシステムプラットフォーム研究所 所長の藤田範人氏は、生成AIがもたらす新たなセキュリティリスクとして「生成AIを用いた詐欺やサイバー攻撃」「ディープフェイクの悪用や偽・誤情報による社会への影響」「ハルシネーション(生成AIが事実と異なることをもっともらしく回答してしまう)」といった内容が顕在化したことを説明した。

今回の説明会で紹介された「LLMを用いたセキュリティリスク診断」「偽・誤情報分析」、10月末に提供開始予定の「ハルシネーション対策機能」という3つの技術は、上記の対策技術として開発されたものだ。いずれの技術も生成AIを活用している。

NECでは、社内DXをリファレンス化し、顧客向けオファリングへ反映する「クライアントゼロ」の取り組みを進めており、今回発表されたセキュリティ技術についても実践中だという。

LLMを用いたセキュリティリスク診断

LLMを用いたセキュリティリスク診断は、LLMと各種セキュリティツール、NECのサイバー攻撃リスク自動診断技術との連携によって非専門家でもセキュリティ診断が実施可能になるというサービス。

同サービスは、企業存続を脅かすサイバー攻撃が増加し、適切なセキュリティ対策がより重要になっていることや、セキュリティリスク診断の手順書はあるものの、非専門家が実施するには難しいという課題があることを背景に開発された。

NEC セキュアシステムプラットフォーム研究所 植田啓文氏は「サイバー攻撃の増加に伴い、セキュリティリスク診断を行い、事前にサイバー攻撃に備えることが重要視されている」と説明した。

説明会では、2023年12月に発表された「脆弱性診断」「攻撃ルート分析」という2つの内容に加えて、対策の要望に合わせて効果的な対策の組み合わせを提案する「対策立案」、読み手に合わせて対応根拠や業界/攻撃者動向などの参考情報を提示する「レポート作成」という技術を新たに開発したことを説明した。

今後は、システム管理者向けのレポート生成サービスを2024年度中に事業化を予定。また、レポート内容を拡充し、現場で働く人に向けた診断支援や、経営層などへの報告に対するサポートも行う方針とのこと。

偽・誤情報分析

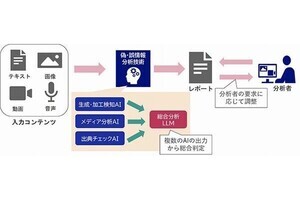

NECは、総務省「インターネット上の偽・誤情報対策技術の開発・実証事業」の下で、複数種類のデータ(テキスト、画像、動画、音声)で構成されている情報コンテンツが偽・誤情ではないかをAIで分析評価する支援ツールの開発に着手したことを発表した。

同技術の開発背景としては、偽・誤情報がインターネット上に氾濫し、日常的に触れる機会が増加しており、社会を不安定化・混乱させるリスクが増加していることや、生成AIの民主化などで容易に作成可能になり、さらなる増大が予想されることなどが挙げられている。

加えて、偽・誤情報対策としてはファクトチェックが有効であるものの、現状は人手をかけて分析しており、効率面に課題があるという。

これを解決するために開発中の同技術では、情報コンテンツが生成・加工データでないかを評価し、メディア(画像・動画・音声)の内容を抽出して、真偽を分析した上で総合的な評価を実施する。なお、LLMを活用することで、ファクトチェック機関が作成するレポートや記事に近い形式で出力される。

今後は、同技術を用いてファクトチェック業務の容易化・効率化を目指すとし、具体的には年内から実証実験を予定している。

ハルシネーション対策機能

ハルシネーションとは、AIが事実に基づかない「もっともらしい嘘」を生成してしまう現象のこと。LLMは利便性をもたらす一方で、ハルシネーションの混入の懸念があるため、業務で活用するにはハルシネーションへの対策が不可欠とされている。

特に金融・医療・法律といった領域での活用に際しては、重大な問題を起こしてしまう可能性もあり、誤った情報に基づく意思決定には細心の注意を払う必要がある。

そして、10月末から提供を開始するハルシネーション対策機能は、NECのテキスト分析技術およびLLMに関するノウハウを元に開発されたもので、LLMが文章生成の元にした文章と生成した文章を比較して、齟齬があった場合は矛盾箇所を提示する機能。

単純な単語の比較だけではなく、文章の意味を比較して判断することが可能で、情報の抜け漏れ、重複、元の文章と意味が変わった箇所などを提示する。

同機能をLLMによる文章の要約に用いることで、要約前後の文章を比較しハルシネーション有無の判定が容易になるため、人的な確認作業の負担が軽減され、要約精度のさらなる向上が期待できるという。

また、RAG(Retrieval Augmented Generatio:検索拡張生成)に代表される情報検索用途においても、LLMに質問し得られた文章に対して、その根拠となる元の文章を提示することも可能であり、LLMが生成した文章の正確性を効率的に確認することも可能となる。

NECは今後、LLMの信頼性を向上に向けて、人物名や地名といった固有表現の一致度合いをスコア化する機能や文章に含まれる一貫性を検証する機能なども追加しハルシネーション対策機能をさらに強化するとともに、一部の機能についてはオンプレミス環境に対しても適用範囲を広げる予定。