2022年11月に「ChatGPT」が登場して以来、AIチャットボットは世界中で急速に普及している。ではいったい、人々は実際にどのようにAIチャットボットを利用しているのだろう?

Washington Postが調査を行い、利用したのはアレン人工知能研究所などの研究者が研究を目的に構築したデータセット「WildChat」。ChatGPTと同じ基盤技術を使用する2つのAIチャットボットで発生した約20万件の英語による会話を分析した。

これらの会話は、WildChatと呼ばれる研究用のデータセットに含まれている。WildChatは、実世界における人とチャットボットのやり取りを記録した最大級の公開データベースの1つという。調査では、WildChatとの約4万件の会話に焦点を当て、各ユーザーがその日最初に入力したプロンプトを中心に調査を行った。

約20万件の会話を分析して見えてきた傾向

そこからどのような傾向が見えたのだろうか?最も多かったのが「クリエイティブライティングとロールプレイ」。全体の約21%を占めた。映画の脚本、ファン・フィクション、作詩、ロールプレイの支援を求めるものだ。AIチャットボットは、単語から連想できる能力を活かしたブレインストーミングに適しているという。

このほか、ビジネスでの製品やサービス名を考案したり、本の登場人物の作成、対話文の作成などにも活用していた。プログラマーで研究者でもあるSimon Willison氏は「これほど多くの用途がある技術は見たことがない」と述べている。

性的な内容にも使われている。性的な会話は全体の7%以上。ユーザーはチャットボットで性的なロールプレイやわいせつな画像を要求していた。チャットボットの多くが露骨な性的コンテンツの利用を制限しているが、ユーザーはそのような制限を回避しようと試みているという。

4%が「ジェイルブレイク(脱獄)」とされるプロンプトを使って制限の解除を試みている。アレン人工知能研究所が作成したWildChatデータセットについての論文によると、ジェイルブレイクは約半分の確率で回避に成功しているとのことだ。

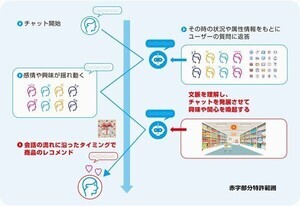

チャットボットを感情的なつながりや、性的な会話のために利用しているユーザーもいるとのこと。使っているうちに感情を持ってしまったのだろうか。このような傾向に対し、専門家はソフトウェアに愛着を持つことのリスクを警告している。

クリエイティブライティングとロールプレイの次に多かったのが「宿題の手伝い」で、18%だった。

主として学生が宿題の手伝いを求めるものだが、中にはチャットボットをチューターのように使い、特定の科目について深く学習しようとしていたという。一方で、オンラインの教育ソフトウェアから多肢選択問題をそのままコピペし、正解を要求するケースもあった。

チャットボットは公開されているデータをもとに学習しているため、歴史的なテキストの要約や地理的な問いの回答に適している。しかし、この方法にはリスクもあるという。チャットボットは実際には自分が言っていることを理解しておらず、人間の発言を模倣しているだけである。また、ハルシネーションとして、情報を捏造する可能性もある。

学校側は、このような生成AIを活用した学習が急増している問題に対処しようと必死だ。一部の大学でAIテキスト検出ツールを使用して学生の課題をチェックしているようだが、検出ツールはまだまだ完璧ではなく、必ずしも正しく検出できていないという。

現状では、生成AIチャットボットをどう使うのかを探っている段階

個人的な質問や助言を求めるという使い方もされている。約5%の会話が、恋愛のアドバイス、不倫への対処法など、プライベートな問題に対してアドバイスを求めていたという。

専門家の警告として、人間は文章に非常に影響されやすい傾向があり、人は上手に文章を書いた人(やチャットボット)を知的だと認識するという。しかし、チャットボットは間違った情報や不適切な情報を出力することもある。チャットボットは必ずしも常に真実を語る機械ではないことを知っておく必要があるという。

ウォートン校の准教授でAIとビジネスを専門とするEthan Mollick氏は、ユーザーはチャットボットから得た結果を重要な源として見るべきではないと述べている。「セカンドオピニオンを安価に得られるという点で、AIは素晴らしい」とのことだ。

このほか、プレゼンの作成、メールの下書き、タスクの自動化など「仕事に関するもの」(約15%)、「コーディング支援」(約7%)、「求職活動」(約2%)などに利用しているという。

記事では、人々がチャットボットとの会話で個人情報を開示していることにも触れている。ワシントン大学のコンピューターサイエンスの博士研究員であるNiloofar Mireshghallah氏は、WildChatの5000件の会話を調査し、ユーザーのフルネーム、雇用主の名前、その他の個人情報を見つけた。

人間は容易にチャットボットを信頼してしまう傾向がある。相手が人間でないと思うと、逆にさまざまなプライベートなことを明かしてしまうという心理だろうか?プライバシーの専門家は、チャットボットに対して過度にオープンになることに警告を発している。特に、ボットを開発している企業は通常、会話を保存し、技術の訓練に使用しているため注意が必要である。

調査ではこのほか、約13%のプロンプトに「please(お願いします)」という言葉が含まれていたことなどもわかった。

これらの結果を並べながら、人々はまだチャットボットの結果をいつ信頼し、いつ無視すべきかを模索している段階にある、とする。先述のMollick氏は「まだ使用説明書は存在しない。現在は、人々がこの技術をどう使うのかを探っている段階と言える」と述べている。

Washington Postが「What do people really ask chatbots? It’s a lot of sex and homework」として、自分たちの調査を紹介している。