小誌でもお伝えしたが、Red Hatは今年5月に年次イベント「Red Hat Summit 2024」を開催した。他のベンダーと同様、同社もAIに取り組んでおり、同イベントの目玉もAIであり、さまざまな発表が行われた。

このたび、レッドハットの日本のエキスパートが同イベントで行われた発表のポイントの解説を行ったので、そこから同社のAI戦略をまとめてみたい。

ソリューションアーキテクトの石川純平氏は、「Red Hat Summit 2024」において語られたAIについて、「AI + Open Source Community」と「Enterprise Open Source AI」という2つのアプローチの下、説明を行った。

オープンソースでAI開発「AI + Open Source Community」

「AI + Open Source Community」とは、AIのオープンソースコミュニティに対するRed Hatの貢献とコミュニティドリブンで進める新しいLLM開発モデルの提案を指す。

石川氏は、「オープンなモデルをベースにさまざまなモデルが公開されているが、コミュニティを介した開発が確立されておらず、一般的なOSS(オープンソースソフトウェア)の開発と異なる状況にある」と、LLMコミュニティが課題を抱えていると指摘した。

具体的には、「派生した先の成果がアップストリームに還元されていない」「モデルのライセンスはOSSでも、学習データが公開されていない」といった課題があるという。

こうした状況の解消を目指すため、イベントでは、「IBM Researchと共同でGraniteモデルをオープンソース化すること」「InstructLabによるオープンなLLM開発モデル」が発表された。

オープンソースのGraniteモデルはApache 2.0ライセンスの下、HuggingFaceとGitHubで利用可能であり、コード・モデルには、3Bから34Bまでのパラメーターによるバリエーション、基本モデルと命令追従モデルのバリエーションがある。

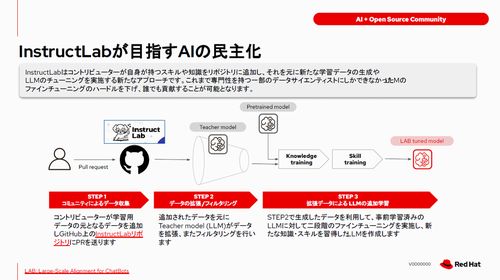

また、InstructLabとは、コントリビューターが自身のスキルや知識をリポジトリに追加し、それを基に新たな学習データの生成やLLMのチューニングを実施するアプローチだ。

InstructLabはIBMとMITが共同で書いている論文がベースとなっており、3つのステップでモデルを強化する。コマンドラインのツールも公開されており、チューニングされたモデルがHugging Face上で既に公開されているそうだ。

ビジネスにおけるAI活用「Enterprise Open Source AI」

一方、「Enterprise Open Source AI」とはビジネスにおけるAI活用の方針を指し、「既存のコアプロダクト(RHEL, Ansible, OpenShift)へのAIを活用した機能強化」と「AIを開発・運用するためのプラットフォームの提供」を行う。

生成AIツール「Red Hat LightSpeed」発表

既存の製品に対しては、昨年に一般提供を開始した生成AIツール「Ansible LightSpeed」の仕組みをRed Hat Enterprise Linux(RHEL)やOpenShiftにも拡張し、Red Hat LightSpeedとして発表した。

「Ansible LightSpeed」は、Ansibleのデータに基づいてトレーニングされた専用AI サービス。具体的には、ユーザーのプロンプトから推奨コンテンツを生成し、「IBM watsonx Code Assistant」と統合してIBM Foundation モデルにアクセスし、Ansibleコンテンツを迅速に構築する。

「Red Hat Enterprise Linux Lightspeed は同社が有するエンタープライズLinuxの専門知識に基づいており、Linux環境の導入・管理・維持に関する質問に迅速に回答し、新たな問題を解決できるように支援する。例えば、「修正プログラムを含むRed Hat セキュリティアドバイザリ (RHSA)のリリースを通知すること」「次の実稼働メンテナンス ウィンドウのパッチ適用のスケジューリング」などが行える。

「OpenShift Lightspeed」はOpenShiftのOperatorとしてインストールし、バックエンドで利用するLLMを選択することができ、チャットインタフェースを介して、OpenShiftの利用方法に関する質問を行える。

具体的には、クラスタが容量いっぱいになった時に、自動スケーリングを有効にする必要があることをユーザーに提案し、クラスタがパブリック クラウドでホストされていることを評価した後、適切なサイズの新しいインスタンスを提案するといったことができる。

AIを開発・運用するためのプラットフォーム提供

AIを開発・運用するためのプラットフォームとして、「RHEL AI」「Podman AI Lab」が新たに発表され、「OpenShift AI」については機能追加が発表された。

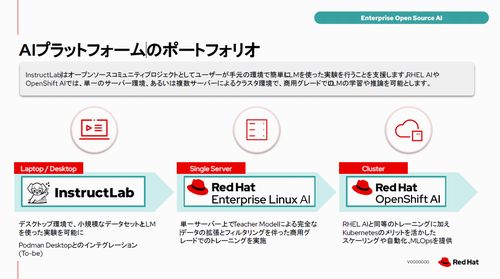

レッドハットは、AIプラットフォームを3つの層に分けている。ラックトップ/デスクトップ向けには「InstructLab」、シングルサーバ向けには「RHEL AI」、複数サーバによるクラスタ環境向けには「OpenShift AI」を提供する。

まず、ローカルPCで生成AIを利用したアプリケーション開発の敷居を下げるツールセットをPodman Desktop 拡張として開発が行われた。これにより、InstructLabにおいて、ラップトップで小規模のLLMで実験が行える。

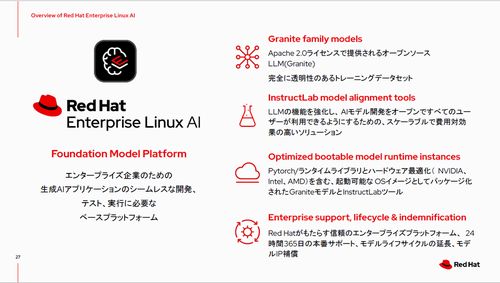

「RHEL AI」は、生成AIモデルをシームレスに開発・テスト・デプロイできるようにする基盤モデルプラットフォームで、現在、デベロッパープレビューの状態だ。Graniteファミリー、InstructLabモデルアライメントツール、InstructLabプロジェクトによるコミュニティ主導のモデル開発アプローチが統合されている。

同製品の特徴の一つが、新しいインストール/メンテナンスモデルである「Image mode」の採用だ。このモデルでは、アプリ用コンテナと同じ技術で、Dockerfileで起動可能なOSコンテナイメージを作成し、コンテナレジストリでOSのアップデートを配布する。

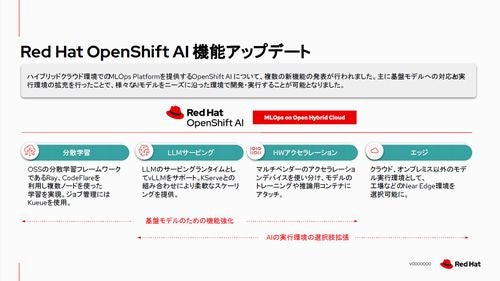

また、最新の「OpenShift AI 2.9」では、基盤モデルへの対応とAI実行環境の拡充を行ったことで、さまざまなAIモデルをニーズに沿った環境で開発・実行することが可能になった。