AI(人工知能)開発のオルツは3月28日、ユーザーのキーボード操作などの行動を学習・分析し、それに基づいて自律的にタスクを実行するAIシステム「alt Polloq(オルツ ポロック)」を発表した。同社独自のLLM(大規模言語モデル)を活用しており、LLM自体が状況に応じて自らプロンプト(命令文)を生成する。2024年6月頃に提供開始を予定している。

「今日の僕の予定を教えて」「Slackに届いたメッセージに適当に返信しておいて」ーー。

同日の記者会見に登壇したオルツの米倉千貴CEOは、ポロックの機能を紹介するデモを披露した。こうした指示に対してポロックは、「本日は10時から18時まで『オルツカンファレンス2024』に参加される予定です」と答え、「承知しました。代わりに返信しておきます」と、Slackに届くメッセージに米倉氏のトーンで黙々と返信した。

【動画】Polloq(ポロック)がタスクをこなす様子

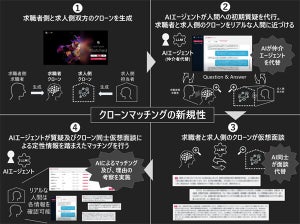

ポロックは「Personalized Optimized Large Language Operative Query:パーソナライズ化・最適化された大規模言語操作クエリ」の略。オルツは新サービスをOS(基本ソフト)とブラウザやEメール、Slackなどのソフトウェアの間に位置付く存在と定義する。

ボイスやメッセージ、キーボードやマウスの操作などをAIが解析し、必要なアクションを自動で実行する。「明日の天気を調べる」という入力を受け取ると、システムが自動でブラウザを開き、Google検索を通じて天気情報を取得し、その結果をユーザーに報告する。

また、これらの動作の履歴はパーソナルメモリーに記録され、ユーザー一人ひとりの特性に応じて、LLMがより正確な結果を出力していくように成長するという。先述の天気を調べるといったプロセスも、ユーザーからの直接の依頼がなくても、実行を自律的に起こせるように成長していくという。

「ポロックは、マウスやキーボード、音声などさまざまな入力を常時確認している。タスク化すべきと判断すると、自ら自分自身に指示を送るイメージだ」(米倉氏)。

将来的には、音声入力やカメラ映像、クリップボードの内容など、さまざまなユーザーの行動を元に、より自律的に動作するエージェントにすることを目指すとしている。

米倉氏は「あと3年もすればAIは人間の感情を理解できるようになる。ポロックにより、ユーザーは効率的かつ手軽に情報整理やタスクの実行を行うことが可能だ」と自信を見せた。