3つのフェーズでAI活用におけるガバナンス強化を支援

Ridgelinezは6月14日、生成AIをはじめとするAI技術の高度化に対応するため、「AIガバナンス体制構築支援サービス」の提供を開始すると発表して、東京都内のオフィスで記者会見を開いた。これにより、企業や組織における安心安全なAIの利活用を支援する。

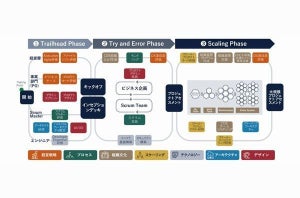

同サービスは、企業や組織が責任ある管理体制の下でAI技術を活用するためのガバナンス構築を支援するサービスだ。提供する内容は「アセスメント」「構想策定・体制構築」「運用改善」の3つのフェーズから構成される。

アセスメントでは、現状の組織体制やリスク管理部門の役割を調査して可視化する。ここでは、富士通グループが持つガバナンスの知見も活用しながら、ガイドラインやポリシーを調査する。また、利用中のAIシステムやその利用状況、開発中のAIからのリスク評価も実施する。

構想策定・体制構築においては、現状の組織体制から追加すべき業務機能の検討や、新設する部門、役割分担の見直し、ガイドラインの策定などを行う。評価から得られたリスクについては、コントロールするための管理プロセスも策定するという。

運用改善では、AIを実際に利活用する中で顕在化した新たな課題やリスク、技術への対応、AIガバナンス体制の運用などについて、アジャイル型でのプロセス改善に取り組む。同社はこのフェーズも伴走型で支援することで、顧客企業や組織が自律的に運用できる状態までサポートするとのことだ。

同サービスではAIの利活用とリスクのガバナンスについて、「Step1:ルールやガイドラインが何もない」から「Step5:戦略と融合、機会損失を防ぎ、競争優位を生んでいる」まで、5段階に分けて定義している。

このうち、Step3に相当するのが「リスクが可視化され、コントロールが行われている」段階であり、当面の目標としてこのレベルを目指すこととなる。その後、状況に応じて「Step4:管理プロセスが定着・効率化、予見的に対応ができる」およびStep5を目指す。

生成AIを安全に利活用するために必要なガバナンスとは?

ChatGPTの登場によって、生成AIをはじめとする先端的なAI技術を以前よりも身近に感じられるようになった。その一方で、これまで顕在化していなかったAIのリスクも急速に浮き彫りになっており、利用を制限する企業や国も出始めている。

もちろん、AI技術の活用に関するリスクは以前から議論されてきたものの、ChatGPTに代表される生成AIは一般の従業員も容易に利用してそのアウトプットを業務に使えるようになったことで、Hallucination(ハルシネーション:AIが出力するもっともらしいうそ)や、情報漏えい、著作権など第三者の権利侵害といった「信頼性」に関するリスクが表層化した。

今後さらにAIが一般的になり活用の場が広がると想定すると、企業活動におけるAIのリスクマネジメントはますます重要な経営アジェンダとなり、AIを使う主体である従業員に対するルール作りや使用環境の整備などガバナンスは欠かせないものとなる。

そうは言っても、極端にAIの利用を禁止してしまうと、業務の変革や革新、効率化、新たな価値創造の機会を失いかねない。そこで重要となるのが、AIガバナンスだ。自社のAI活用の段階に応じて人員配置や業務プロセスを柔軟に変更することで、先端技術の価値を十分に享受できる。

Ridgelinezの執行役員でリスクマネジメントを専門とする藤本健氏は「生成AIを業務利用する際はさまざまな落とし穴がある」と、指摘していた。

誤情報やバイアス(偏見)にだまされないための利用者のリテラシーから、情報漏えいを防ぐためのデータ保護、他者の権利を侵害しないコンプライアンスなど、幅広いリスクコントロールが求められるのだという。

藤本氏は「生成AIは利用形態やユースケースに応じて、リスクとコントロールが異なっている。ChatGPTのWeb版を使うのか、APIを使うのか、あるいはAPIを利用したサードパーティサービスを使うのかなどに応じて、クラウドサービスの共同責任モデルの考え方も踏まえつつデータ保護やセキュリティの運用に対応する必要がある。また、ユースケースとしては、生成AIのアウトプットを個人での利用や社内業務へ活用する場合と、社外向けの業務に活用する場合に大別されるので、まずは社内向けの業務に活用してリスクコントロールの実践知蓄積に取り組むべき」とも述べていた。