全世界で、それこそ秒単位でつぶやかれる情報。書籍や衣料品等、さまざまな品物が手に入るショッピングサイトでの購買データ。鉄道系ICカードを使用した際に蓄積される乗車記録……。近年、日々蓄積されていくさまざまな情報、いわゆる「ビッグデータ」を有効活用しようとデータマイニング手法が登場している。「Japan IT Week春」でもビッグデータに対して多様なアプローチを試みるサービスやソリューションが出展されていたが、今回ピックアップしたのは、インターネットでのアンケート調査などでお馴染みのマイボイスコムが出展していた「TextVoice」だ。

|

マイボイスコムブースに出展されていた「TextVoice」。同じテキストマイニングの事例としてテキストから性格を自動判断するというものも。採用試験や昇格試験で書かれた文章よりAIを用いて性格を16タイプに判定するという |

|

こちらは、今回ピックアップした「TextVoice」ASPサービスの製品紹介Webサイト。「あなたの想像力を刺激する」というキャッチコピーよろしく、この手軽さと多彩な分析結果が得られるということに「おお! 面白そう!」とワクワクさせられたのは筆者だけではないのでは? |

この「TextVoice」は、例えば「もう少し味付けが薄いほうが好みです」や「ボリューム的にさびしい気がしますが、価格に見合っていると思います」といった自由回答によるテキストデータを驚くほど手軽に分析が行えるASPサービスなのだ。先ほど、「驚くほど手軽」と称した理由は、「TextVoice」にログインして分析したいテキストデータが蓄積されたCSVファイルを指定し、あとは実行ボタンをクリックするだけ。たったこれだけのアクションで任意の情報を、誰でも使うことができるのは特筆すべきだろう。

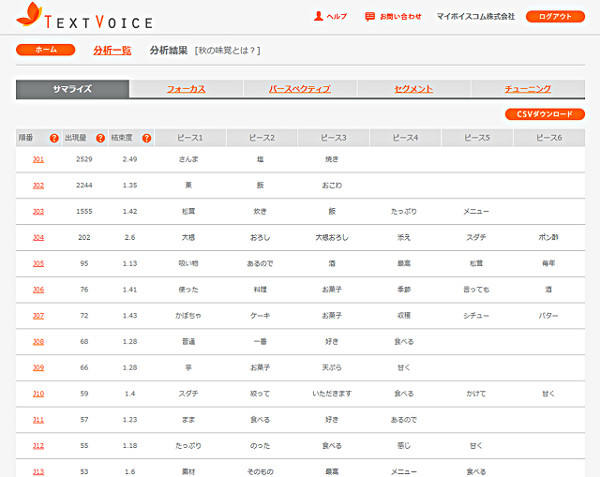

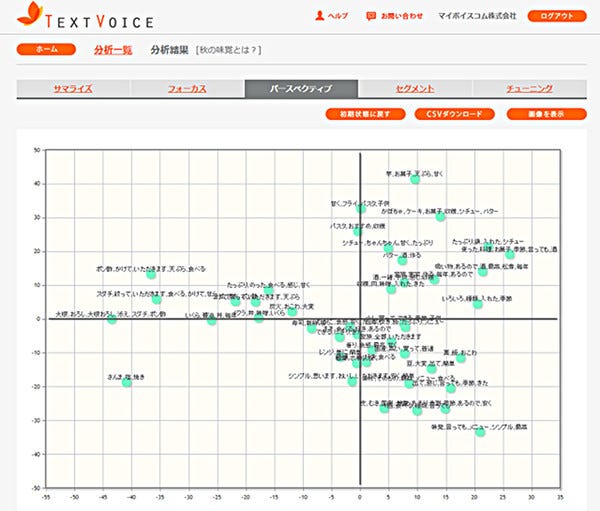

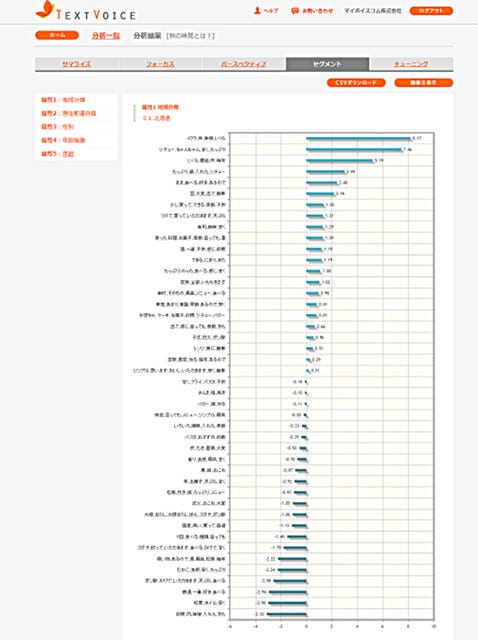

手軽でありながら、この「TextVoice」は4つの視点での分析結果を得ることができることも本サービスの特徴と言えよう。文章のなかにどのような言葉が登場したか、その出現量や結びつきの強い語句をピースとして最大6個表示してくれる「サマライズ」、結束度の高い注目すべき意見を抽出することが容易な「フォーカス」、グリッド上に配置された語句の位置関係から潜在する大きなパターンを読み解く「パースペクティブ」、性別や年齢といった属性と強く繋がりを持つ内容を抽出する「セグメント」、以上の分析がわずか数分で行えてしまうのだ。ちなみに、用意したCSVデータに約3,000件のレコードが記録されていた場合、2分程度で分析が完了するという。また、1回の分析で最大15MB未満のデータ(おおむね10万件程度)まで分析可能とのこと。

|

こちらは「フォーカス」の分析結果画面。出現量が多く結束度の強いワード、ここでは「さんま・塩・焼き」は無視できない重要な意見として捉えることができ、出現量は少ないが結束度は高い「大根・おろし・大根おろし・添え・スダチ・ポン酢」は注目すべき意見として解釈することができる |

|

こちらは「セグメント」の分析結果画面。この例では、地域分類で「北海道」に当てはまる属性下においては「いくら」というワードは関連性が強く、「ちゃんちゃん」というフレーズから「鮭」を思い描いている人も多いのではと見受けられる |

ここで気になるのが「TextVoice」ASPの利用料はというと、初期費用は20万円(税別)で月々発生する費用がひとりの利用で10万円(税別)、同一の事業所で5名の利用で12万円(税別)となっており、契約期間は6カ月単位での契約となっている。

自社での顧客サービス改善の糸口を探す、新たな商品開発の指針を模索するといった顧客から寄せられた声を分析したい、サービスや製品に対して顧客が思った事柄が蓄積された言葉を分析し、解釈を加え仮説を組み立てるなどテキストマイニングによって、データに裏打ちされた実行プランを練ることも可能な「TextVoice」。ビッグデータを所有しているビジネスオーナーなら、その導入を検討してみてはいかがだろうか。溢れかえっていた無数の言葉から、ビジネスにとって掛け替えのない資産を生み出すことができるのだから。