SuperMicroの基調講演でも説明したように、今年は液冷サーバーをかなり各社が本腰を入れて展示していた。昨年も一応展示はあったのだが、殆どのベンダーが撮影不可で、ingrasysだけが撮影OKだったのだが、今年は(相変わらず撮影不可のベンダーもあったが)少なからぬメーカーが液冷サーバーを撮影OKの状態で展示していた。

ちなみに液冷と一言で言っても実際には何種類か方法がある。SuperMicroはDLCを前面に押し出していたが、現在使われている方法は

- DLC(Direct Liquid Cooling):1相式、つまりチップを冷却して温度が上がった冷却液を、そのままクーリングタワーに送り出して冷却し、再びチップに送り込む方式。冷却液は、なのでサーバー外部から供給する形となる。冷却液として水を使う事が可能で、コスト削減の観点から水を利用するケースが増えている。

- DTC(Direct to Chip Liquid Cooling):2相式、つまりチップを冷却する一次冷却液と、その一次冷却液を冷やす二次冷却液から構成される(クーリングタワーにはこの二次冷却液が送られる格好になる)。この方式のメリットは、より沸点の低い冷却液を一次側に利用して、沸騰冷却を行える事である。沸騰冷却は、通常の液冷よりもより効率的に熱をチップから奪う事が可能であり、効率が高い。ちなみに原子炉なども同じように2相式であるが、こちらはそもそも原子炉の温度が高すぎる&一次冷却水が放射能汚染される危険性があり、直接外部で冷却するのは危険という理由なのであって、方式が同じであっても目的は異なる。

- CLLC(Closed-Loop Liquid Cooling):1相式に構造は近いが、最大の違いは冷却システムもサーバーの中に収めている事。コンシューマ向けの簡易水冷CPUクーラーを考えてもらうのが判りやすい。冷却能力に制限はあるが、外部にクーリングタワーを設ける必要がない点が評価される。

- 液浸:サーバー全体を冷却液にドブ漬けし、その冷却液を外部のクーリングタワーで冷却するという方式。かつて理化学研究所に置かれていたPEZY Computingの菖蒲とか東京工業大学のTSUBAME-KFC、古いところではCray-2などがこの方式を採用しており、昨年も数社がこの液浸のソリューションを展示していた(なぜか今年はサーバーでは見かけなかった)。ちなみにこの液浸の場合、不活性の液体(3Mのフロリナートが有名だが、TSUBAME-KFCは油を利用している)を使う関係で、この調達コストが結構馬鹿にならない。

あたりが主な方式になる。昨年はDLCとCLLC、それと液浸のソリューションがあったのだが、今年は各社DLCに方式が統一された様だ。

SuperMicroは基調講演で示したラックを会場に展示していた(Photo01,02)が、肝心の内部構造などは公開されていない。4Uサーバー1台あたり、供給と排出のホースがそれぞれ6本づつ用意されているのはもう少し検討の余地はありそうな気もするのだが、むしろサーバーシャーシ内部でこれを分岐させたり合流させたりするより、それぞれ別に用意した方が低価格で同じ効果が得られるという判断なのかもしれない。

GIGABYTEも液冷サーバーを展示していた(Photo03)が、こちらはラックの左右に供給/排出経路を設けている格好。サーバーシャーシの要求に合わせてホースの数を自由に増減できる格好で柔軟性には富んでいる様に思う。

ASRockは6U8X-GNRWDLC B200という、Dual Xeon 6+B200×8構成のサーバーユニット(Photo04)を展示したが、供給/排出のホースがそのまま出ているだけという状況(Photo05)で、ちょっとまだSolutionというレベルに達していない印象を受ける。

MiTACはIntelのD50DNPをそのまま利用したソリューションを展示していた(Photo06,07)。

-

Photo07: ただし肝心の供給/排出部は見えず。Data Center GPUが左側に、右側の奥にXeonのソケットが縦に2つ並んでいるのが見える。その両脇はDIMM用のサーマルジャケットだろうか?

AICはSlimなDual Xeon向けソリューションを展示していた(Photo08)。ASUSはラックの展示は無く、GB200×2+XC7用のシャーシのみを展示しているが、こちらはだいぶ考えられた構造になっている(Photo10)。GB200用のクーラーは、Cooler Masterによるものの様だ(Photo11)。また昨年も展示したInventecは、今年はArtemis 2U System(Photo11)の内部を公開してくれた(Photo12)。

-

Photo08: 4th/5th Gen Xeon Scalable向けで、それぞれ最大350WまでのTDPに対応とされている。供給/排出のホースが汎用のバンジーで繋がってるあたりはちょっと大丈夫か?という気もしなくはない。

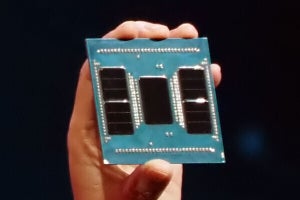

ちなみにServerでは無いが、ASUSのブースで展示されていたAI用ワークステーションがこちら(Photo13)。スペックは

CPU: Threadripper Pro 7995WX(常時全コア4.5GHzにOC駆動)

CPU Cooler: Nexalus SP5 Waterblock

M/B: ASUS Pro WS WRX90E-SAGA SE

Memory: Kingston DDR5-5600 32GB RDIMM×8

GPU: NVIDIA RTX 4090 with Nexalus Single Slot cooler×7

Storage: WD 4TB NVMe SSD×2+Samsung 870 QVO 8TB×2

Power: ROG Thor 1600W Titanium ATX×2+Phanteks Revolt SFX 1200W

というお化けマシンであるが、ここまでやるならもうラックに収めてDisplayとUSBだけ手元に引っ張った方が早いのでは? と思わなくもない。まぁ中々の化け物であった。