12年前にフランスで創業し、EclipseベースのETL開発ツールやJavaのパイプライン処理を行うESB基盤で人気を博したTalend。企業で高まるデータ分析ニーズに応えるように、さまざまなアプリケーションを展開、昨年にはNASDAQ市場に上場するまでに成長した。いま力を入れているのはIoTなどで求められるリアルタイム分析だという。TalendのCTO、ロラン ブリー(Laurent Bride)氏に、取り組みの進捗や今後の戦略について話を聞いた。

-- Talendはデータに関するさまざまな製品を展開していて、わかりにくいところがあります。いったい何をしている会社なのでしょうか?

創業時のビジョンは「データインテグレーションビジネスをディスラプトする」ことでした。商用のデータ統合製品を提供していた企業が競合です。われわれはJavaアプリケーションでのデータのパイプライン処理をOSSで提供するという戦略で挑み、市場をディスラプトすることができました。

その後、さまざまなデータ活用のニーズに応じて機能を追加していきます。現在Talendは、さまざまな企業データを統合してビジネスで活用するためのデータ統合プラットフォームとなっています。

-- ETLツールであったり、データマートを作る基盤であったりします。どういう製品ポートフォリオになっているのですか?

まず、あらゆるデータにアクセスできるTalend Data Fabricという基盤があります。その基盤の上には、ユーザーやメタデータ、ポリシー、グループなどを管理するレイヤーがあり、さらにその上で、企業のニーズに合ったさまざまなアプリケーションが展開されます。アプリケーションには、マスターデータ管理やデータプリパレーション、データクオリティ、データガバナンスなどがあります。

このほか、Talend Data Fabricの横に、スケジューリングやオーケストレーションを行うTalend Administration Center(TAC)/TMCというブロックのレイヤーもあります。こうした全体構成を指して、データ統合プラットフォームと呼んでいます。

-- マスターデータ管理やデータプリパレーションなどは独立した製品なのでしょうか?

ユーザーからは、機能を拡張するプラグインのように見えます。アプリケーション開発には、Talend Studioというアプリケーションを利用します。Talend Studioの画面上で、マスターデータ管理や、データプリパレーション、データクオリティなどの機能を自由に追加していくことができます。

データ統合プラットフォーム製品のなかには、単独の製品をつなぎ合わせて、一体的に見せているものもあります。Talendはそうではなく、プラットフォーム上でアプリケーションが統合されていることが大きな特徴です。

-- ほかにTalendのプラットフォームはどんな特徴を持っていますか?

幅広いコネクティビティが挙げられます。900を超えるコネクタやコンポーネントを使って、さまざまなデータソースからデータを収集することができます。

例えば、ビッグデータについては、Apache Hadoop、Apache Spark、Sparkストリーミング、NoSQLデータベースなどと接続することができます。他社の製品との違いは、SparkやMapReduceのネイティブコードを生成することができることです。

それをClouderaやHortonworks、MapRといった主要なHadoopディストリビューションにデプロイすることができます。デプロイ環境は、オンプレミスはもちろん、AWS、Azure、GCPなどのクラウドに対応します。

開発生産性が高いことも特徴です。パイプラインはGUIを使って設計し、データもドラッグ&ドロップで統合、加工していくことができます。このようにして、一貫したビューでデータのライフサイクルを管理できるため、5分の1のコストで5倍のパフォーマンスを出すことができるのです。

-- 具体的にどう作業するのか簡単に教えていただけますか。

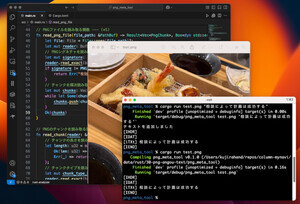

例えば、データプリパレーションを行う場合、さまざまなデータソースからデータを集めてきます。ここでは、データソースがマーケティングツールのMarketoのCRMデータ、Amazon S3に保存したログデータ、Clouderaで構築したオンプレミスのデータレイクにあるデータだったとしましょう。それらはStudioの画面上から簡単に集めてくることができます。

次に、データを加工します。集めたデータは数十万件でスプレッドシートに表示されています。シート上では、キャンペーンに使うためのメールアドレスがないデータを削除したり、ソートや比較がしやすいよう表記を統一したりといった作業を行います。修正すべき箇所をカラー表示したり、操作をガイドをしてくれますので、IT知識があまりないマーケターでも簡単に加工ができます。

それが済んだら、GUIでデータ処理のパイプラインを作ります。加工したデータにどんなフィルタをかけるかやどのサービスにデプロイするかなどをドラッグ&ドロップで作成していきます。こうしたパイプラインの処理の裏側では常にJavaコードが生成されています。

-- こうした処理を実行するタイミングは、バッチでもリアルタイムでもいいのでしょうか?

そうですね。MapReduceなどのバッチ処理のほか、フォルダを監視してファイルが追加されたら実行したり、データベースを監視してデータが取り出されたら実行したりといったことができます。IoTでのユースケースなら、Apache Kafkaトピックのメッセージを受けて、Sparkストリーミングでデータをリアルタイム処理するといったこともできます。ビッグデータのリアルタイム処理は、いま特に力を入れている領域です。

-- ビッグデータのリアルタイム処理は、IoTなどで特にニーズが強いようです。

さまざまなユースケースをカバーできるよう、AMQPやMQTTなどのIoTプロトコルや、MongoDB、couchDB、cassandraなどのNoSQLデータベースをサポートしています。データの収集から、収集したデータの分析とアプリケーションとしての配信までを行うことができます。

-- 今後の展開を教えて下さい。

大きな戦略としてアプリケーションを増やしていくことがあります。現在取り組んでいるのは、Web上でパイプラインを作成できるアプリケーション「Data Streams」、インベントリを使ってデータ資産を管理するアプリケーション「Data Catalog」、データ資産を検索するアプリケーション「Data Discovery」、データの出自を管理する「Data Lineage」などです。

例えば、Data Discoveryでは、さまざなクラウドにあるデータ資産を横断的に検索できます。またData Lineageでは、製品間、I/O、アプリケーションの実行、ソーシャルなどのリネージを確認できます。ソーシャルデータを誰が作成して、どこで実行され、どの製品に保存されているかなどを把握できるようにします。

-- 機械学習やAIなどへの対応はどうでしょうか?

プラットフォームとしては、機械学習の技術はすでに活用しています。タスクの自動化などに役立っています。また、AIについては、データやメタデータの品質を管理するData Stewardshipというアプリケーションで活用しています。

例えば、データセットのなかから条件に合致したものを抽出したい場合に、マッチングした97%をAmazon RedShiftに送り、残りの3%はData Stewardshipに送って機械学習をさせます。教師データを使ってトレーニングし、次回からは、より精度の高いマッチングができるようになります。

-- 最後にメッセージをいただけますか。

データを使うさまざまなユーザーに対して、幅広くユースケースを提供していこうとしています。新しいアプリケーションを開発するのもそのためです。さまざまなアプリケーションを提供することで、どんな小さな取り組みからでもはじめられるようになります。ぜひTalendを試してみてください。