米西海岸時間の18日、米サンフランシスコでGoogleの開発者向けカンファレンス「Google I/O 2016」が開催され、同社CEOのSundar Pichai氏などによる基調講演が行われた。モバイル関連を中心に基調講演での発表内容についてレポートしよう。

VRによるパノラマライブ配信

例年通り、基調講演の様子はYoutubeによりライブストリーミング配信が行われたのだが、今年は4月にサービスが開始されたばかりの「Youtube 360」を使い、360度のパノラマストリーミング配信も行われた。Googleが配布しているVRヘッドセット「Cardboard」に対応しており、AndroidやiOS用のYoutubeアプリとCardboardを併用すると、立体的なパノラマ映像を楽しめる。「Google I/O Keynote 360」などで検索して確認してほしい。

音声認識は文脈を理解可能に

基調講演の冒頭にはGoogleのスンダー・ピチャイCEOが登壇。ユーザーがモバイルに移行していることを紹介し、それに合わせてモバイル検索機能をコンテキストベースのものに強化したことを明らかにした。デモではアーティストのビヨンセを検索後、「彼女」といえばビヨンセのことだと理解して検索できる。さらに「Googleフォト」でも「ハグ」や「食べる」といった動詞を使った検索で、該当する動作の写真が選択できるようになっている。

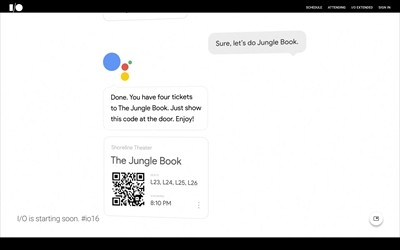

こうした強化の背景にあるのが「Google Assistant」だ。Google Assistantでは、例えば「映画を見たい」というと、現在地の周囲で上映中の映画をリストアップする。続いて「子供も一緒」とすると家族向けの映画に絞り込まれ、映画名を選ぶと人数を確認され、確認が終わるとオンラインで次の上映回のチケットを取得し、入り口で掲示するQRコードまで表示される、といった具合に、まるで気の利いたコンシェルジュにお願いするかのように、次々と処理を進められる。

これは音声認識の精度が高まっていることはもちろん、会話の内容から文脈を把握して正しいデータを検索し、適切な処理を選べるということで、人工知能とディープラーニングを使った音声認識技術の進化が想像以上に進んでいることを表している。

筆者は古い人間なので、デモを見てアップルが88年に公開したコンセプトビデオ「Knowledge Navigator」を思い出してしまった。この伝説的なビデオでは、南米とアフリカの気候変動データをもとにビジュアル化するところまでアシスタント任せにしているが、Google Assistantが進化すればGoogleスプレッドシートなどと連動し、従来ならデザイナーなどに任せていたような作業も自動化できるようになるだろう。「OK Google」と比較しても格段の進化ぶりにはかなり驚いた。日本語対応がどの程度になるかも含めて気になるところだ。