NTTは10月20日、LLM(Large Language Models:大規模言語モデル)の普及に伴う電力消費やコスト増加といった問題の解決に向け、軽量ながら高い日本語処理性能を持つNTT版LLM「tsuzumi 2」の提供開始を発表し、記者説明会を会場とオンラインのハイブリッド形式で開催した。

代表取締役社長の島田明氏はtsuzumi2について、「従来のtsuzumiの強みである高い日本語処理性能はそのままに、少ないデータでのチューニングが可能となり省コストでより早く高精度なカスタマイズを実現できるようになった」と紹介していた。

業務適応力と特化性能を向上した「tsuzumi2」

2024年3月に商用提供を開始した「tsuzumi」は、良質な日本語データを学習したことによる、軽量かつ高い日本語性能を特徴とする。また、日本の文化や商習慣を踏まえた処理を得意としている。

同モデルはNTTが純国産のLLMとして開発を進めたもので、学習データだけでなく開発プロセスやシステム、運用を日本国内でコントロールしている。そのため、リリースやライセンスを柔軟にコントロールしながら安定して提供可能だ。

島田氏によると、tsuzumi2は従来のtsuzumiと比較して、企業内文書の文脈や意図を理解する能力が向上したほか、長文読解や指示遂行能力が強化されているという。また、従来モデルに引き続き1つのGPUで動作する基礎能力を維持しながら、パラメータサイズを30Bまで向上させている。

金融分野における実証実験の結果、Googleが開発した同程度のパラメータを持つGemma-2 27BがFP(ファイナンシャルプランニング)2級試験の合格基準(60%以上)を満たすために1900問の追加学習が必要であったのに対し、tsuzumi2は200問の追加学習で合格基準を満たした。

少ない追加学習データで特化モデルを構築できるtsuzumi2の強みを生かして、同社は金融や公共、医療など、機密性の高いデータの取り扱いを必要とする業界向けにモデルを提供する。その他の業界については市場の要望に応じて対応を検討する予定だ。

「tsuzumi2は提供開始に先駆けた実際の現場での検証を通じて、お客様が実現したいことを実現するモデルとして高い評価が出始めている。今回のtsuzumi2の提供開始を受け、NTTは新たな価値創造とお客様体験の高度化に向けた取り組みをこれまで以上に加速する」(島田氏)

tsuzumi2の技術的な3つの進化点

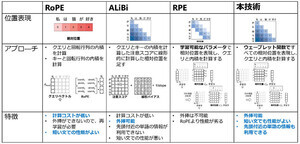

続いて、執行役員で研究企画部門長を務める木下真吾氏がtsuzumi2の技術的なポイントを解説した。同氏は、従来版のtsuzumiと比較したtsuzumi2の強みとして、「日本語性能のさらなる向上」「特化型モデル開発効率の向上」「低コスト・高セキュアの維持、国産AI」の3点を挙げた。

日本語性能のさらなる向上

日本語性能については、知識・解析・指示遂行・安全性の4項目に対し、GPT-oss 20B、Gemma-3 27B、Qwen-2.5 32Bといった同程度のパラメータ数を持つモデルと比較して、日本語ベンチマークで高い結果を示した。

同様に、Llama-3.3 70B(パラメータ数約2.3倍)やGPT-oss 120B(同4倍)など数倍大きなモデルと比較しても同等のスコアを示したことから、コストパフォーマンスに優れたモデルと言えるとしている。

特化型モデル開発効率の向上

特化型モデル開発効率の向上では、個社に特化するRAG(Retrieval-Augmented Generation:検索拡張生成)と、業界に特化するファインチューニングのどちらにも対応可能だ。

NTT社内の財務システムに関する問い合わせ業務にtsuzumi2とRAGを適用した評価の結果、同サイズ帯のモデルおよび数倍以上のモデルと比較して、そん色ないベンチマークスコアを示した。

ただし、ほとんどのモデルがベンチマークスコア最大値の1.0に近い結果であることから、RAGの技術自体が上限に近い性能を示すようになりつつあると考えられる。

業界特化の知識をモデルそのものに学習させるファインチューニングにおいては、上述したようにFP2級試験に対して他モデルよりも少ない追加学習で合格基準に達した。木下氏の説明によると、元々tsuzumi2のモデルが日本特有の金融データなどを使って開発されているため、追加学習なしでも54%の正答率を示せるそうだ。

低コスト・高セキュアの維持、国産AI

30Bで開発されたtsuzumi2だが、これは1つのGPUで動作するために適切なパラメータ数なのだという。1つのGPUでも動作するということは、オンプレミスでの稼働にも対応できることを意味する。そのため、低コストと高セキュアを両立できる。

具体的なコストについて見てみると、400BのLlama-4ではNVIDIA H100 80ギガバイト相当のGPUを8基必要とする。同様に700BのDeepSeek-v3.1では16基が必要とされる。これに必要な推論時のハードウェアコストは、それぞれ約5000万円と約1億円と推定される。

対して30Bのtsuzumi2はNVIDIA A100 40ギガバイト相当のGPU1基で動作するため、ハードウェアコストは約500万円とのことだ。

tsuzumi2はオンプレミスで稼働するため入力データが外部に漏えいしないセキュリティの高さを備えるが、他方で、モデルによる回答精度のセキュリティの高さも備える。バイアス・差別・ヘイト・反公序良俗、悪用、情報漏えい、誤情報、擬人化などによる心理的依存の5項目でベンチマークを比較したところ、同サイズのモデルおよび数倍大きいモデルと比較して、高いスコアを示した。

木下氏は「海外製のモデルをベースに日本語にチューニングするモデルは、少ない手数で日本語能力を拡充できるメリットがある。対してtsuzumi2は海外製のオープンなモデルに頼ることなく、すべての著作権や開発プロセス、ライセンスをコントロールするために、国内でのスクラッチ開発を採用した」と、国産のLLMである意義を解説した。