日本ヒューレット・パッカード(HPE)は7月31日、AI戦略と「NVIDIA AI Computing by HPE」に関する説明会を開催した。NVIDIA AI Computing by HPEは、企業による生成AIの導入加速を支援することを目的に共同で開発した、AIソリューションのポートフォリオおよび共同の市場開拓の取り組みであり、年次イベントのHPE Discover 2024で発表された。

日本ヒューレット・パッカード 執行役員 ハイブリッドソリューションズ事業統括本部 ソリューションアーキテクト 本部長の及川信一郎氏は、 NVIDIA AI Computing by HPEのほか、HPE Discover 2024で発表された主要な内容として以下を挙げた。

- NVIDIAとの共同開発製品「HPE Private Cloud AI」

- NVIDIAの最新GPUとSuperchipを搭載し、AIに最適化されたHPEのサーバ

- HPE GreenLake for File StorageがNVIDIA DGX BasePOD 認証およびNVIDIA OVX ストレージ認証を取得

- ハイブリッドデジタル運用管理製品「HPE GreenLake cloud OpsRamp」

以下、「NVIDIA AI Computing by HPE」と「HPE Private Cloud AI」を中心に紹介する。

「NVIDIA AI Computing by HPE」の概要

「NVIDIA AI Computing by HPE」においては、HPEとNVIDIA が共同で、以下を提供する。及川氏は、「製品を提供するだけでなく、ターンキー型のプライベートクラウド、AIサービス、トレーニング、AIに最適化されたコンピュート、ストレージを提供する」と説明した。また、企業がAIを利用する上でセキュリティのリスクがあるとして、「そのままLLMを解き放つことはリスクがある。エンタープライズ品質のガードレール機構、トレーサビリティなども提供する」と述べた。

- ターンキー型のプライベートクラウド

- AIサービス&トレーニング

- AIに最適化されたシステム

- エンタープライズレベルの品質のコントロール

- AIの推論、チューニング、トレーニング

- 仮想アシスタント

- プロセスの自動化、コンテンツ

加えて、「NVIDIA AI Computing by HPE」では、HPEのチャネル、パートナー、技術者コミュニティが、NVIDIAのトレーニングと資格認定を利用可能になる。HPE Partner Ready / HPE Partner Ready Vantageプログラムを拡張することで、パートナーを支援する。

及川氏は、「技術的なトレーニングは既に開始している。パートナプログラムは2次代理店も含めて拡販していきたいと考えており、11月以降に新年度のパートナプログラムを拡張する予定」と説明した。

「HPE Private Cloud AI」の特徴

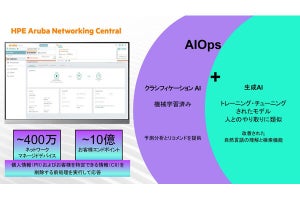

「NVIDIA AI Computing by HPE」のオファリングとして提供されるのが「HPE Private Cloud AI」だ。これは、NVIDIA AIコンピューティング、ネットワーク、ソフトウェアと、HPEのAIストレージ、コンピュート、HPE GreenLakeクラウドに実現したもので、ターンキーのフルスタックのプライベートクラウドとなっている。

「HPE Private Cloud AI」は、以下を実現する。

- AIによる生産性の向上

- データへのアクセスを一元化

- エンタープライズ品質の信頼性とコントロール

- データをプライベートに保った状態でのクラウド体験

及川氏は、「HPE Private Cloud AIでは、企業が生成AIを使っていくために必要なものをセットとして提供するする。生成AIを利用するための環境をゼロから作るのは難しいので、検証済みのモノを導入できるようにする。また、PoCから本番に移行するにあたり、データのリスクを感じている企業が多いと感じている。主にオンプレミスを想定しており、データを外に出すことなく使ってもらえるようにしているが、クラウドからも使えるし、ファイルもオブジェクトも使える」と説明した。

「HPE Private Cloud AI」のAIモデルはNVIDIAが提供し、、AIソフトウェアとAIインフラは両社が、AIサービスはHPEとサードパーティーが提供する。エヌビディア エンタープライズ事業本部 事業本部長 井﨑武士氏は、「ハードウェアはGPUとネットワーク製品が統合されており、ソフトウェアは統合的なAI開発プラットフォームを提供し、生成AIの開発や展開を合理化する」と語った。

井﨑氏は、「HPE Private Cloud AI」の持続可能性についても言及した。今後、多くの企業で生成AIが利用されることになると電力効率の抑制が求められるとして、NVIDIA NIMでは推論を最適化することで、モデルスループットを3倍向上しているという。

また、「OpsRamp operations copilot」は、大規模なデータセットを解析して会話型のアシスタントによるインサイトを得ることで、運用管理の生産性を高める。「HPE Sustainability Insight Center」は、エネルギーと炭素の影響の管理を実現する。

「HPE Private Cloud AI」のラインアップは4種類で構成されている。用途によってサイズが異なることが想定されており、チューニングされた状態で届けられる。

生成AIを利用する際に重要なことは「ガバナンス」

説明会では、ヒューレット・パッカード エンタープライズ データ&AI担当SVP エン・リン・ゴー博士が、企業がAIを活用する上で守るべきことについて説明した。

ゴー博士は、同社のCEOであるアントニオ・ネリ氏の等身大の生成AIアバターを作成しようとした際、生成AIが不適切な形で質問に答えるのではないかということが大きな懸念になったとして、ガバナンスモデルを作って守ることにしたと説明した。

同社のCEOとして話をさせるために、「独自の生成AIとLLMが必要だった」ゴー博士は述べた。「汎用的なLLMはインターネットに基づいて回答するので、基本的なモデルを使うと変な回答することになり、私はクビになってしまう」(ゴー博士)

そこで、ゴー博士はガバナンスを確保するために実施した施策を4つ紹介した。1つ目の施策は、LLMをコントロールすることだ。今回、同社のコントロールしたデータを1万投入し、質問があった時にそれに基づいて回答できるようにしたという。

2つ目はガードレールの設置だ。大規模なモデルに比べると10分の1程度の小さなモデルを利用することで、不適切な質問はブロックするようにしている。例えば、「株価はどうなるのか」といったLLMが正確に答えられない質問を受けた際、「申し訳ございません。回答できません」と回答する仕組みになっている。

3つ目は機械学習をマネジメントするソフトを導入して、LLMをトラッキングしているという。

4つ目は、人間にストップボタンを持たせたことだ。いざとなったら、人の手でリスクをヘッジするというわけだ。

また、この取り組みにおけるポイントとして、ゴー博士は処理時間を短縮できたことを紹介した。最初、CEOのアバターが質問を受けてから回答するから10秒程度かかっていたところ、チューニングしたり、GPUをH100にアップグレードしたりして、3秒までに短縮できたという。

ゴー博士は「生成AIを活用したCEOのアバターの取り組みにおいて、ガバナンスが重要であること、処理時間を3秒まで短縮できたことを覚えておいてほしい」と語っていた。