Amazon Web Services(AWS)は12月2日(現地時間)、年次技術カンファレンス「AWS re:Invent 2025」において、同社の最新世代AIチップ「Trainium3」を搭載した「Amazon EC2 Trn3 UltraServers」の一般提供開始を発表した。あわせて、現在開発中の次世代チップ「Trainium4」について、NVIDIAの「NVLink Fusion」を採用する計画を明らかにした。NVIDIAの技術を取り入れることで、開発サイクルの短縮とAIインフラの柔軟性向上を図る。

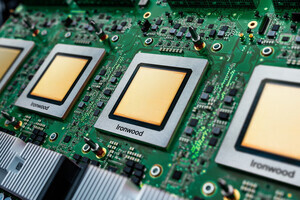

Trainium3は3nmプロセスで製造され、FP8演算で2.52PFLOP(ペタフロップス)の性能を発揮する。144GBのHBM3eメモリを搭載し、帯域幅は4.9TB/sに達する。これは前世代(Trainium2)と比較して、メモリ容量で1.5倍、帯域幅で1.7倍の大幅な強化となる。

Trn3 UltraServerは、最大144個のTrainium3チップまで拡張可能で、システム全体で362PFLOPのFP8演算性能を提供する。相互接続には、Trn2 UltraServer比で2倍の帯域幅を持つ「NeuronSwitch-v1」を採用。これにより、前世代比で最大4.4倍の計算性能、3.9倍のメモリ帯域、そして4倍の電力効率改善を実現した。

次世代チップ「Trainium4」は、FP4演算で少なくとも6倍の性能向上、4倍のメモリ帯域幅の拡大が見込まれている。最大の特徴は、NVIDIAのインターコネクト技術「NVLink Fusion」への対応だ。

大規模なAIモデルの構築には、多数のアクセラレータを単一のファブリックで接続する強力なネットワークが不可欠である。Trainium4がNVLink Fusionに対応することで、NVIDIA製GPUやその他のアクセラレータを同一ラック内に混在させて運用可能となり、ワークロードに応じて最適なチップを使い分ける「ヘテロジニアス構成」が現実的な選択肢となる。また、実証済みのNVIDIAエコシステムを活用することで、インフラ構築に伴うコストとリスクを低減し、より迅速かつ安定的にトレーニング環境を導入・拡張できる利点がある。

AIチップ市場では長らくNVIDIAのGPUが一強状態にあったが、近年ハイパースケーラー(巨大クラウド事業者)による独自チップ開発の動きが活発化している。先ごろ、Googleが最新モデル「Gemini 3」の学習に自社開発チップ(TPU)を用いたことが判明し、NVIDIAによる市場独占の一角が崩れる可能性として注目を集めたばかりだ。

こうした「脱NVIDIA」の潮流に対し、AWSは独自チップ「Trainium」を進化させつつ、次世代製品ではNVIDIAのエコシステムとも連携する独自の「全方位戦略」を打ち出している。

NVIDIAにとって、チップを独自開発するAWSは競合関係にある。しかし、カスタムチップの採用が拡大する市場動向を踏まえれば、今回の提携は合理的な戦略転換といえる。AWSのような巨大ベンダーがNVIDIAの通信規格を採用すれば、AIサーバー市場におけるNVLinkの地位はより盤石なものとなる。「チップ単体の競合」を受け入れる代わりに「インフラ(通信・ラック)」を提供し、AIデータセンターの「プラットフォーム企業」へと事業構造を拡大することで、チップ開発競争の激化に左右されない持続可能な収益基盤の構築が可能となる。