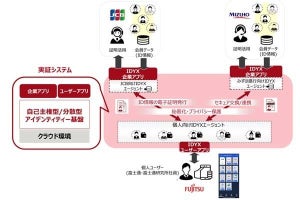

富士通研究所は29日、AIを意図的に誤判定させるような偽装攻撃に対する耐性強化技術を開発したことを発表した。

偽装攻撃では正規操作のなかの合間に攻撃を混ぜるなど敢えてAIモデルに誤判定を誘因する手法を用いる。新たに開発された技術は、正規操作のデータをもとに模擬偽装攻撃データを自動で生成、これを複数のAIモデル(元の学習データに強いAIモデル/偽装攻撃データに強いAIモデル)で学習させることで"偽装攻撃データらしさ"を作り出し、自動でアンサンブルな学習を行う。

効果実証では、偽装攻撃テストデータに対しての判定精度が約88%まで向上するなど未対策の環境(24%) に比べて大きな差が見られる。失敗するものも単純なルールで対応できるため、実質的に偽装攻撃を防御できるとしている。