知能メディア処理研究室の研究内容とは

GPUサーバを利用して、さまざまな研究を行っている知能メディア処理研究室。ここからは、実際に研究を行っている学生のお2人、大社綾乃氏、志賀優毅氏も交え、お話を聞いていこう。

──知能メディア処理研究室で行っている研究について、具体的に教えてください。

山田氏:当研究室では、欲しい情報が簡単に入手できる便利な社会を目指して、人の身の回りのものを知覚する研究を行っています。実際に事例を紹介しますと、書いてある処方箋を指先に付けたカメラで認識して、文字を電子化することで、薬剤名や処方量の読み間違いをなくすという研究などがあります。ほかにも、大規模画像データベースを利用した高速検索やマンガ画像を対象としたコンテンツ検索、装着型カメラ画像に基づいた行動認識など、画像を対象とした知的な情報処理を取り扱っています。これから、その一端を説明させていただきます。

|

指先に付けたカメラで処方箋に書かれた薬剤名や処方量を認識するシステム |

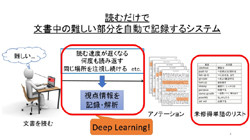

「読むのが難しい」と感じた部分を自動で記録

大社氏:ディープラーニングというと、画像を用いた研究を思い浮かべると思うのですが、私は視点情報を組み合わせた研究を行っています。私の研究の最終目標は、読むだけで文書中の難しいと感じた部分を自動的に記録して、学習補助に役立てるというものです。例えば、文書を読んでいて難しいと感じた場合、読む速度が遅くなったり、必要に応じて読み返したりといった動きが表れます。こういった人間の視点行動を記録して、難読箇所をフィードバックさせるというシステムになります。

具体的には、ディスプレイの下部に「アイトラッカー」というデバイスを設置し、眼球運動を測定しています。これは、読者が画面中のどの部分を見ているかを測定するものです。このデバイスによって、文書を読んでいるリズムを学習することによって、難しいと感じた箇所を推定しています。単語の注視時間のみ、出現頻度のみを利用した学習に比べ、ディープラーニングを用いることによって検出精度は約90%にまで向上しました。

こちらの処理は、25名分の385文書の視点データを記録し、約20万のデータを入力した場合、従来のサーバでは200回学習するのに丸1日かかっていたのですが、GPUサーバを導入することによって、だいたい1時間前後で終わるようになり非常に助かっています。被験者が難しいと感じた単語の適合率は現在34%と十分ではありませんので、精度向上のために、特徴量の再考やデータ量を増やすことなどが必要になると考えています。

読書内容を自動的にカテゴリ分けするシステム

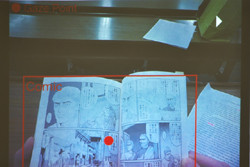

志賀氏:私が研究している内容は、読書内容の自動検出です。例えば、10~11時は小説、12~13時はコミック、13~15時は論文を読んだ……といったように、文書カテゴリや読んだ時間を知ることができます。今までも可視化サービスはいろいろありましたが、記録は手動で行わなければならないため、非常に手間がかかるものでした。自動で読書内容を識別することで、より正確な読書行動を知ることが可能となります。人は読書行動から多くの知識を得ていますが、こういった行動を可視化することによって知的習慣の学習改善につながるのではないかと考えています。

検出には2つの方法があります。1つは「モバイル アイトラッカー」というメガネ型のデバイスによって眼球の動きを追い、視点情報から読書行動を識別する方法です。もう1つがウェアラブルカメラを使った方法で、一人称視点の映像を得ることができます。この2つの情報にディープラーニングを組み合わせることで、カテゴリの識別精度を向上させています。

現在行っている実験では、読書行動と識別できたものが82%、識別対象のうち正しくジャンルを認識したものが85%となりました。この認識は、ディープラーニング上に5万枚ほどの画像を読み込ませて学習させることで行っているものです。GPUサーバを導入して、ディープラーニングを利用できるようになってから、こちらの精度はかなり向上したと思います。