Appleは2024年6月10日(現地時間)、WWDC24の基調講演において、今年秋にリリースが予定されるOSのアップデートについて発表を行いました。もっとも時間を割いたのは、iOS/iPadOS/macOSに共通して搭載される新しい人工知能「Apple Intelligence」の紹介です。Apple IntelligenceによってiPhoneはどう変わるのでしょうか。発表内容をもとにポイントをご紹介します。

Apple Intelligenceとは?

生成AIを活用したサービスは、この1〜2年で非常に身近なものになりました。すでにバリバリお使いの方も多いと思いますが、逆にほとんど使う機会のない方もいるでしょう。両者の違いはおそらく、「AIを使おう」という意思と多少の知識(プロンプトなど)の差にあると思われます。

Appleが発表したApple Intelligenceは、使う人の意思や知識とは関係なく、すでにOSやアプリに組み込まれた形で私たちの前に現れます。私たちは「AIを使おう」と意識せずに、アプリの新しい機能の一部としてAI機能を使うことになるでしょう。

加えて、iPhoneの中には膨大な個人情報が収められています。会議の予定や思い出の写真、家族や友人の名前、いま画面に表示されている内容などなど。Apple Intelligenceはこれらを使って文章やムービーを生成したり、アプリを操作して情報を探したりすることができるわけです。

もし今、AI動画生成アプリに「沖縄旅行の家族写真で1分の動画をつくって」と頼むとしたら、ライブラリから「沖縄旅行」の「家族写真」を選ぶのは人間です。そして、素材としてアップロードした写真がアプリ提供側のAIの学習に使われない保証はありません。

しかしApple Intelligenceは、過去の情報から「沖縄旅行」や「家族」の写真を認識して動画を生成します。写真は外部に送信されず、デバイス上だけで生成されるためプライバシー面でも安心です。もしデバイスの処理能力が足りない場合は、外部にデータが保存されない専用のクラウドを利用することになっています。

逆に、個人情報に関わらない知識や提案、例えば「スズキの調理法」や「子どものためのなぞなぞ」などを求めるなら、汎用的な目的で開発されたAIの方が適しています。この点はSiri経由でChatGPT-4oから回答を得ることもできる仕組みになっています。

誰もが“AIの存在”を意識しないまま、プロンプトを書いたりアプリを切り替えたりする手間もなく、機械の能力を自分の目的のために利用できるのがApple Intelligenceの特徴と言えるでしょう。

文章の書き方・読み方が変わる「記述ツール」

では、具体的にiOSでは何が変わるのでしょうか。まずは文章に関わる「記述ツール」です。これは、自分で書いた文章を異なる文体やトーンに変換する「書き直し」、つづりや文法の間違いを修正する「校正」、長い文章の要点をまとめる「要約」の機能を持ちます。メール、メモ、Pagesなど、文章を書く多くのアプリで、それも入力画面上で使用できます。

プロンプトなしで生成できる「Image Playground」

次に画像生成の「Image Playground」です。現在利用されている画像生成AIの多くは、何をどう描画したいのかを言葉で指示する(=プロンプト)必要があります。しかしImage Playgroundなら、直感的な操作画面でテーマや衣装、場所などを選択して画像を生成できます。モデルにする人物を写真ライブラリから選ぶことも可能です。

Image Playgroundは単独のアプリですが、メモやメッセージ、フリーボードなどのアプリ上からも使用できます。例えば、「メモ」に描いた落書きからキレイな画像を生成したり、前後の文章の内容をもとに関連した画像を生成することができます。

日本語対応は? 対応モデルは?

基調講演では他にも、短い説明文から独自の絵文字を生成する「Genmoji」や、写真検索、ムービー作成、Siriがより自然で状況に適した会話やアプリ操作に対応するなど、数多くの使い方が紹介されました。Apple純正アプリだけでなく、他社製のアプリもこれらの機能を搭載できる仕組みが提供されているので、活用の幅がより広がることが期待されます。

Apple Intelligenceは、iOS 18(およびiPadOS 18/macOS Sequoia)にベータ版として搭載される予定ですが、当初は英語(米国)のみ対応です。その他の言語には2025年以降に順次対応することが発表されています。

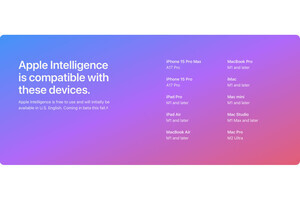

対応モデルは、発表時点ではiPhone 15 Pro/Pro Maxとなっており、この秋に発売が予定される新機種を含めてもごく限られたものになる見込みです(iPad/MacはM1以降のチップ搭載モデルで利用可能)。日本のユーザーにとって、Apple Intelligenceはまだ少し遠いものとなりそうです。