米澤センター長の話では、4月に初めてLINPACKを測定したら、エッーというほど低い性能しか得られず、日立が懸命にチューニングを行って83TFlopsまで改善したとのことである。しかし、それでも京大のシステムがピーク比で82.5%を達成しているのに対して、東大は73.4%と低いレベルに留まっている。筆者は、これはA、B群間の接続ネットワークのバンド幅が低いことが原因ではないかと思っている。

構成図を見ると、LINPACKの測定に使用されたA群512ノードクラスタとB群256ノードクラスタの間は、ライフネットワークと書かれたネットワークで接続されている。このネットワークに関しては、公表情報は無いのであるが、前述のように各計算ノードからは2本の1000BASE-Tが出ており、これで接続されていると考えられる。

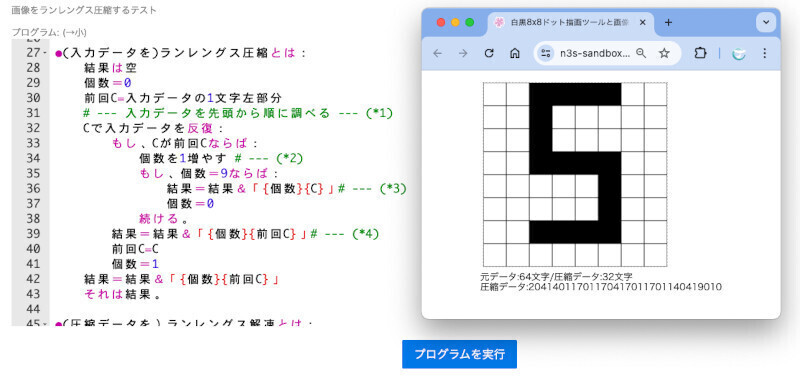

計算ノード筐体の中央部分にスイッチらしきものが見える |

計算ノードは筐体の上下に8ノードづつに分かれて搭載されており、筐体の中央にはスイッチらしきものが搭載されている。筐体の扉が閉まっておりパンチングメタル越しの見にくい写真であるが、 赤い1000Base-Tのケーブルが16本入る部分が2箇所あり、その右に更に1~2本の赤いケーブルが繋がっているのが見える。多分、1000BASE-Tを集約し、10倍の速度の10GBASE-Tに繋ぐEthernetスイッチであろう。そして、その上に青いマネジメントLANケーブルを繋ぐスイッチが搭載されている。

この1000BASE-TでA群512ノードとB群256ノードを接続しているとすると、その間のバンド幅は、1.25GB/s×2×256=640GB/sである。そしてB群の総演算能力は37.7TFlopsあるので、通信と演算の比は、0.017B/Flopというスパコンの常識でいうとかなり低い値である。LINPACKはそれほど通信を必要とするアプリケーションではないが、それでも、これくらいの通信/演算比率になると、影響が出るのではないかと思われる。

しかし、これはA群とB群を接続して処理を分担させるということから来る問題であり、前に述べたように、通常の使用形態では問題にならず、むしろ、通常使用しない部分にかける費用を抑えた良い設計であると言える。また、ピーク比率がどうであろうと83TFlopsはそれ自体、素晴らしい性能であり、東工大のTSUBAMEの56.4TFlopsを上回り、6月17日に発表される次回のTop500では、国内トップのスパコンシステムとなると予想される。

そして、3大学が共通使用で調達したシステムであるので、ハードウェアに若干の違いはあるものの、ソフトウェアの動作互換性は非常に高い。これを利用して、3大学のT2Kスパコンをグリッドで接続して連携動作を行わせたり、人材育成、学際的研究の推進、プログラム高度化支援などを3大学が共同で推進していくことになっている。

プログラムの高度化に関しては、これまで大学などの研究者が使用できるスパコンシステムは、最大でも1000コア程度であり、その程度の並列性があれば十分であったが、2012年に稼動が予定されている次世代日の丸スパコンは10万コアを越える並列度が要求されると予想される。今回のT2Kシステムでは512ノードで8192コアの並列処理環境が提供されることになり、次世代スパコンへのプログラム並列化の重要な飛び石となることが期待される。