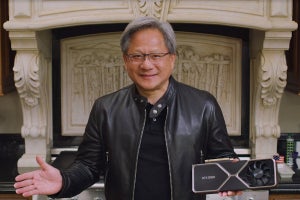

Micron Technologyは現地時間の9月1日、GDDR6X DRAMを公式に発表した。これはNVIDIAのGeForce RTX 30シリーズの発表とタイミングをあわせたもので、NVIDIAがGeForce RTX 3080/3090がPAM4を利用したGDDR6Xを採用したことを説明の中で公開(Photo01)しており、それもあってMicronも公式にこれを発表した形になる。

-

Photo01:左は16GbpsのNRZ Signal、右は21GbpsのPAM-4 Signalとなる。確かにEye Widthは取れてるのだが、Eye Heightがこれで十分なのか気になるところ

そのMicronであるが、9月3日にオンラインでこのGDDR6Xに関しての記者説明会を開催したので、まずはその内容をお届けしたい。ちなみに説明は同社のRalf Ebert氏(Director, Micron Worldwide Graphics Business)が行った。

そもそもGDDR6X開発の動機は? と言えば、より高い帯域へのニーズが絶えないことにある(Photo02)。

これに向けて、GDDR系はどんどん信号速度を引き上げてきた(Photo03)。

-

Photo03:左がPinあたり帯域、中央がGDDRチップ1個(=32bit)あたりの帯域、右がシステム(GDDRチップが8~12個)での帯域となる。GDDR6Xで遂に1TB/secを超えた、という訳だ

GDDR5は2008年から市場投入されており、そこからどんどん速度を上げてゆくが、8Gbps/pinあたりで頭打ちになる(当初は4Gbps程度だったから、ほぼ倍増である)。2016年にMicronはGDDR5Xを発表し、やはりNVIDIAがこのGDDR5Xを採用した製品(GeForce GTX 1000シリーズ)を出荷するが、採用事例はそのGeForce GTX 1000シリーズのみにとどまった。一応後追いでJEDECにより標準化はされたとはいえ、GDDR6の仕様策定が進んでおり、より低い消費電力で高いデータレートが実現できると見込まれたためである。GDDR5Xは14Gbps/pinまで可能とされたが、市場に出回っているのは12Gbps/pinどまりである。その後継であるGDDR6は2018年から量産が開始され、NVIDIAのGeForce RTX 2000シリーズやAMDのRadeon RX 5000シリーズに採用されたほか、間もなく登場するPlayStation 5やXbox Series Xなどにも採用が決まっている。ただこちらは16Gbpsで頭打ちとなっており、より広い帯域が必要な場合にはHBM2/HBM2Eを使うか、バス幅を広げるしかなかった。このマーケットにMicronは、独自規格であるGDDR6Xを投入した形だ。

これを可能にした最大のポイントは、データバスをNRZからPAM-4変調に切り替えた事だ。そもそもGDDR6の世代でも、16Gbpsというと信号速度が高速なために、これによる消費電力が増加するほか、タイミングがクリティカルという問題があった。銅配線で、しかもDifferentialならともかくSingle Endedだと16GHzというのはかなり厳しい状況であり、これ以上の速度アップはかなり厳しい。ところがPAM-4を使うことで、信号速度自体は落としても帯域は増やせる訳で、帯域あたりでの消費電力はNRZとほぼ同等以下に抑えられた模様だ(このあたりは後述)(Photo04)。

ちなみにMicronはPAM-4をメモリに採用する事そのものは、2006年にすでに手掛けていたとする。ただしそれはPhoto05で言う所の“Scientists discover”であり、これを量産できる技術で実現する(Engineers develop)と共に、それが受け入れられるマーケットを確立する(Business identifies market need)事が重要だ、とEbert氏は説明した。今回の場合、NVIDIAのGeForce RTX 30シリーズに要求される帯域がGDDR6ではカバーできない、というあたりで最後の要素であるマーケットの確立が出来た形となる。

-

Photo05:2017年の時点でMicronがGeForce RTX 30シリーズの開発計画を知っていた訳ではないだろうが、少なくともNVIDIAからMicronに、Bandwidthに関するロードマップ(何年位にどの程度の帯域が必要か)は伝えられ、それに対しての回答としてGDDR6Xを提示した、というあたりだろうか

余談であるが、同社のTim Hollis氏(Fellow and Signaling Expert)によれば、GDDR6Xの開発は2017年からスタートしたとしている。つまりGDDR5Xの開発が終わった(=GDDR6の開発真っ最中)のタイミングで、GDDR6Xの開発が始まった訳だ。

-

Photo06:こちらはMicronがYoutubeに上げている「“Feeding the Beast: the Making of GDDR6X”」より

ちなみに現在のGeForce RTX 3080/3090に採用されている製品は19Gbps・8GbitのGDDR6Xであるが、すでにMicronのParts Catalogには19Gbps品と21Gbps品がラインナップされている。容量は現在のところ8Gbit品のみだが、今後は16Gbit品や、より高速な製品も予定はしているとする。

-

Photo07:もっとも大容量/高速品のマーケットが出来るかどうか、はGDDR7の行方次第である。伝統的にAMDは非標準DRAMを嫌うため、GDDR6Xに移行する可能性はそう高くないと思うが、GDDR7が難航するようであればあるいは、という可能性は若干ある

さて発表内容はこの程度だが、質疑応答でもう少し判った内容を以下に記したい。まずPAM4変調だが、FECはどうも一切入っていないらしい。Ebert氏いわく「データバスにPAM-4変調を入れただけ」だそうで、一体BERがどの程度なのかちょっと心配になるが、配線長が短いからあるいは大丈夫なのかもしれない(DFEに関してはDDR5で標準採用が決まっているので、あるいはこちらを入れてカバーしている可能性はあるが、そのあたりはEbert氏も良くわからない様だ)。したがって、NRZをPAM-4に変えてもLatencyという意味では殆ど変わらないようで、LatencyはGDDR6と変わらないという話だった。

製造プロセスやダイサイズ、消費電力へのインパクトなどは詳細は明かされなかったが、「一般的に言ってGDDR6と同じ世代のプロセス」「ダイサイズも概ね同じ」「消費電力もほぼ変わらない」といった形で、曖昧ながら現状のGDDR6とほぼ同じ程度のコストと消費電力で実現されている事を示唆した。ちなみにGDDR5Xの場合と異なり、今のところJEDECで標準化される予定はないという話であった。

ところで、実はMicronはこの発表に先駆けて「うっかり」Technical Briefを公開しており、ところが一斉にここにアクセスがあったことで慌ててひっこめたのだが、製品発表が行われたことで改めてこのTechnical Briefを公開した。なので、このTech Briefの内容を基にもう少し詳細をご紹介したい(Photo08)。

まず主要な技術的諸元をまとめたのがこちら(Photo09)。

-

Photo09:Burst lengthがRDQS(Read Strobe Mode)のみ16になっているが、そもそもRDQSはLow Speed Modeであり、この状態だとPAM4も使われない(NRZになる)

差があるのはスピード以外で言えばVrefdに3つのsub-receiver per pinが用意されること程度である。これはPAM4のReceiverがPhoto10のような構造になっているためである。

ちなみに送信側はPhoto11のような実装になっており、VDDQ×3/6、VDDQ×4/6、VDDQ×5/6、VDDQ×6/6の電圧がそれぞれ00/01/11/10の各シンボルに対応する形になっている。これで十分なEyeが取れるのか? と思うが、Micronによれば十分対応できるとの事(Photo12)。

-

Photo11:ということは、要するにData EyeのHeightはVDD×1/6になるというわけだ

-

Photo12:これはどちらも16Gbpsの場合の比較。21Gbpsだとどの程度暴れるのか、ちょっと怖いが

Eye Heightそのものは小さいが、信号があまり暴れないためかそれなりにHeightが確保されており、その一方でWidthは2倍以上のサイズが取れるから、案外受信は難しくなさそうである。確かにこの程度の波形が維持されるとすれば、FECなしでもそんなに信号のBERは悪化しなそうな気もするが、ただこのあたりは基板のレイアウトとか材質、実装に左右されるはずで、OEMメーカー(NVIDIA用語で言う所のAICパートナー)からどんな声が出てくるのかを聞いてみたいところだ。

消費電力に関しては、14GbpsのGDDR6と21GbpsのGDDR6Xを比較すると、転送効率が15%改善する、としている。逆に言えば、GDDR6Xの21Gbpsの転送に要する消費電力の絶対値は、GDDR6で14Gbpsの転送に要する消費電力の27.5%増しになる、という計算になる。まぁ帯域が50%増しなのに消費電力は27.5%増しなのだから、良いバーターとは言えるだろう。

-

Photo13:加えると、メモリセルそのものも速度が上がる(Photo09で見る限りBurst LengthはGDDR6と同じなので、Burst Lengthを倍増させて速度を下げる案は使えない)から、メモリチップ全体の消費電力はもう少しあがりそうであるが

そんな訳で色々興味深い実装であるこのGDDR6X、今のところMicronからしか提供されないこともあって、NVIDIAの採用に続く話があるかどうかは判らない。Micronは他にもHPCやAIマーケット向けにも有望とするが、何しろ市販のGDDR6対応Memory I/F IPでは利用できない(PAM4に対応したMemory I/Fは無い)とか、Micronからしかチップが提供されないというあたりは、普及のネックになりそうである。Photo07のキャプションにも書いたが、GDDR7の標準化が順調に進めば、市場はこちらに流れそうに思われる。つまりGDDR6Xが更なる市場を得られるかどうか、はGDDR7の標準化がどこまで難航するかに掛かっていると言えるわけだ。