AtCoderは6月18日、Sakana AIと共同でAIによるアルゴリズム開発能力を評価する新たなベンチマーク「ALE-Bench(ALgorithm Engineering Benchmark)」を開発したことを発表した。

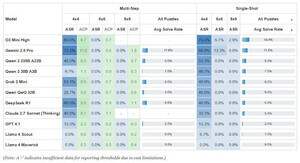

両社が開発したALE-Benchは、AtCoderが主催する「AtCoder Heuristic Contest(以下、AHC)」の最適化問題をもとに構成されている。既存のベンチマークでは評価が難しかったAIが開発した最適化アルゴリズムの性能を客観的かつ定量的に測定可能だという。

また、ALE-Benchで扱うタスクは創造性、高度な推論能力、継続的な改善能力を要するため、このベンチマークは最適化アルゴリズムの性能評価だけでなくAI分野全体の研究開発を前進させる基盤として期待できるとのことだ。

ALE-Benchの概要

ALE-BenchはAHCで出題された組合せ最適化問題40問で構成される。自然言語で記述された問題文だけでなく、可視化ツール、コード実行環境、順位算出用の評価ソフトウェアも提供しており、AIが人間の参加者と同じ条件でAHCに参加する状況を再現している。これにより、異なるAI同士を公平な環境で比較・評価可能。

ALE-Benchが果たす役割

ALE-Benchには2つの役割があるという。1つ目は、組合せ最適化問題に対するAIの性能を評価する新たな手段となり得る点。従来のベンチマークの多くは正解または不正解を判定する形式が主流であり、最適化問題のように「解の良し悪し(スコア)」を競う課題に対応するベンチマークは限られていた。

2つ目は、「創造性」「継続的な思考」「試行錯誤による知見の蓄積」など、最適化アルゴリズムを開発する際に求められる能力を評価できる枠組みを提供している点。従来は定量的な測定が難しかったAIの推論能力を組合せ最適化問題を通じて客観的に評価できるようになった。

AIエージェント「ALE-Agent」による検証結果

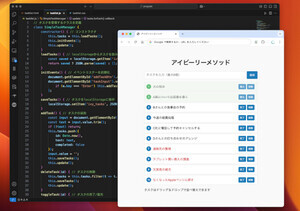

ALE-Benchの開発に合わせて、組合せ最適化分野におけるAIの実力を検証するため、AtCoderの許諾のもとでSakana AIが開発したAIエージェント「ALE-Agent」(AtCoderアカウント名:fishylene)が実際のコンテスト「AHC046」および「AHC047」に参加した。

コンテストではAIが人間の競技者と同じルール・環境下で約1000人の参加者と競い合った。その結果、AHC046では154位(上位16%)、AHC047では21位(上位2%)にランクインしたとのことだ。