NECは11月14日、大量のテキストデータ(ビッグデータ)から特定の意味を含む文書を漏れなく検出する「テキスト含意認識」を、従来に比べて約24,000倍高速化することに成功したと発表した。

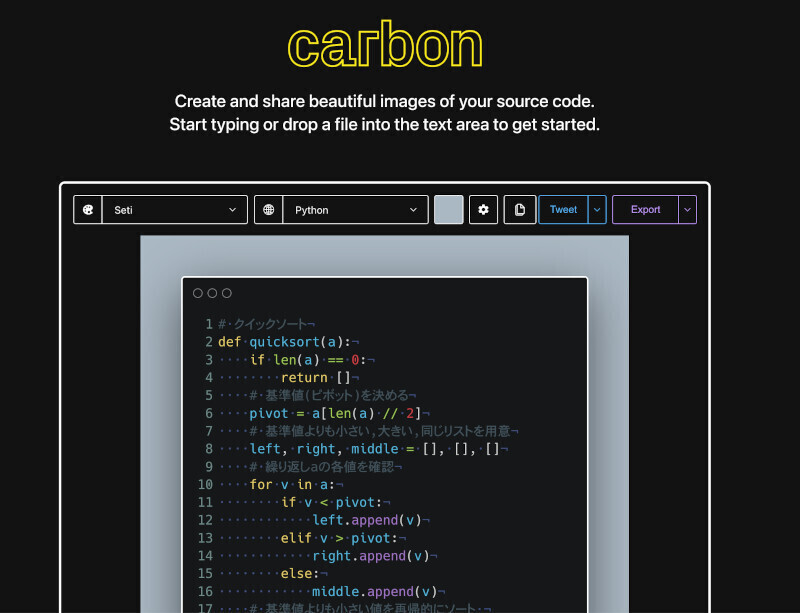

従来は、テキストデータ中の全文書に対して、特定の意味を含むかどうかを一つずつ判定していたため、テキストデータが大量になると膨大な処理時間が必要だったが、今回開発した技術は、テキストデータ中の文書が特定の意味を含むかどうかを一括で判定していく過程で、ある条件を含まないと確定した文書は、随時、候補から除いていくアルゴリズムにより、従来技術と同じ判定精度で高速に検出する。

NECのテキスト含意認識は、特定の意味が文書にどれだけ含まれているかどうかを、特定の意味の表現に使われている全単語を文書がカバーする割合(被覆率)に基づいて判定する含意候補判定と、含意候補判定で候補と判定された文書中の文の意味構造に基づいて判定する、特定の意味を含むか否かを判定する処理、の2段階から構成される。

最初の処理である含意候補判定において、被覆率の計算過程で各文書の被覆率の上限値を求め、被覆率が閾値を超えないことが明らかになった段階で判定を確定、候補から除くことにより、処理量の削減を実現する。

また、重要度が一定値以下の文書は、被覆率も閾値を超えないという関係が成り立つため、テキストの重要度のみで含意しない候補を判断できる。これを利用し、テキストを重要度の値ごとに複数グループに分け、グループごとに検索インデックスを構築し、重要度が閾値を超えないグループの検索を省略する。これにより、単語の被覆率を計算する以前の段階で、不要な候補の削減を実現する。

約700万文のテキストデータを用いた計測では、従来方式に比べて平均で約24,000倍の高速化が確認。これは、新聞に換算して約4年分のデータ量に相当し、従来、約1.3時間かかっていた含意認識が、わずか0.2秒で処理可能だという。