京都大学(京大)は5月22日、ヒトの脳活動パターンを深層ニューラルネットワークなどの人工知能モデルの信号に変換して利用することで、見ている画像に含まれる物体や想像している物体を脳から解読する技術の開発に成功したと発表した。

同成果は、国際電気通信基礎技術研究所(ATR)脳情報総合通信研究所神経情報学研究室 神谷之康客員室長(京都大学情報学研究科教授)、堀川友慈主任研究員らの研究グループによるもので、5月22日付けの英国科学誌「Nature Communications」に掲載された。

同研究グループはこれまでに、機能的磁気共鳴画像法(fMRI)などにより計測されるヒトの脳活動パターンを、機械学習によるパターン認識で解析することで心の状態を解読する「ブレインデコーディング」と呼ばれる技術を開発してきた。しかし、脳活動からそのときに見ている物体を解読する従来の方法では、あらかじめ脳活動を計測して機械学習モデルをトレーニングした少数の物体カテゴリしか対象にできないという課題があった。

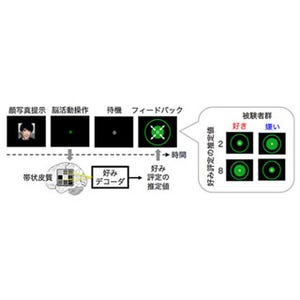

今回、同研究グループは、任意の物体カテゴリの予測を可能にするため、コンピュータビジョンの分野で用いられている「物体概念を視覚特徴のパターンによって表現する」という考え方を採用し、画像を深層ニューラルネットワーク(DNN)で処理することで得られる視覚特徴量のパターンによって、物体画像を表現。そしてブレインデコーディングを応用し、被験者が物体画像を見ているときに fMRIで計測した脳活動パターンから、DNNの信号の予測(脳からDNNへの変換)を行う機械学習モデル(DNN特徴デコーダ)を学習させた。

学習済みのDNN特徴デコーダによって脳活動から予測された特徴パターンと、大規模画像データベースから得られる物体カテゴリと視覚特徴パターンのリストを、パターン間の類似度をもとにマッチングすることで、画像を見たり想像したりしているときの脳活動から、任意の物体カテゴリの解読が可能となる。

このアプローチの有効性を検証するため、脳活動からDNNの特徴量を予測できるかどうかを確認したところ、画像を見ているときのヒトの脳活動パターンと、同じ画像を入力としたときのDNNの信号パターンの間に相同性を発見した。

そこで、この結果をもとに、ランダムに選択した1000個の物体カテゴリから、知覚・想像している物体カテゴリを正しく予測(検索)できるか検証した結果、正解の物体カテゴリが検索ランキングの上位にランクインするという結果が得られた。予測が外れた場合であっても、正解のカテゴリと意味的によく似たカテゴリを予測できていたという。

同研究グループは今回の成果について、人工知能モデルをヒトの脳と対応づけ利用する「脳-機械融合知能」の可能性を切り拓くもので、ブレインデコーディングへの応用だけでなく、脳型人工知能の開発にも貢献することが期待されると説明している。