SC12において、米国のエネルギー省(Department of Energy:DoE) Office of ScienceのAdvanced Scientific Computing ResearchのディレクタであるWilliam Harrod氏が「A Journey to Exascle Computing」と題する基調講演を行った。

Office of Scienceは今回のTop500で1位となったTitanスーパーコンピュータ(スパコン)のスポンサーであり、2位のSequoiaのスポンサーであるDoEの「NNSA(National Nuclear Security Administration)」と並ぶ米国のスパコン開発と調達の中心となる政府機関である。つまり、この講演は、米国政府がどのようにExaScaleスパコンを推進しようとしているかを説明するものである。

|

|

SC12で基調講演を行うDoE/Office of ScienceのHarrodディレクタ |

なお、米国では、DoEの他にも国防総省(Department of Defense:DoD)の国防高等研究計画局(Defense Advanced Research Projects Agency:DARPA)、国立科学財団(National Science Foundation)などがスパコンの開発や大規模スパコン調達に資金を供給している。

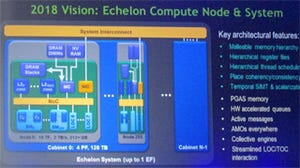

Harrod氏は、次世代のExtreme Scale Scienceのブレークスルーを達成するためにはコンピューティングテクノロジの大きな改善が必要。また、スパコンなどで生成されるデータ量の急増に対応することが必要であり、Exascaleのコンピューティングが必要になるという。そして、Exascaleでは、Exaflopsの実効性能をほぼ20MWの最大電力で実現するのが目標と述べ、次の図を示した。

そして、広範な科学者が使え、ソフトウェアの開発が容易なシステムであること。また、頂点となる1台のExaflopsシステム専用のテクノロジ開発でなく、市販可能なテクノロジで実現することを目標に掲げている。実現時期は、2020年以降とし、当初の予定よりも2年あまり遅めの時期を示した。

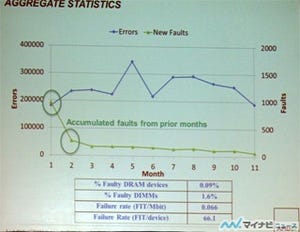

Exascaleの実現には消費電力、メモリとストレージ、並列性と局所性、耐故障性などに大きなチャレンジがあり、多くの研究開発が必要である。また、現在のシステム全体で同期をとるBulk Synchronousで、分散メモリを使い、順次実行するプロセス間の通信に基づくという実行モデルは、効率、スケーラビリティ、消費電力の点で壁にぶつかっており、システム設計にも新しいアプローチが必要になるという。

また、現在のソフトウェアスタックは過去50年のレガシーの上に築かれており、データ移動を最小化して消費エネルギーを最小化するという考慮は、全くなされていない。そして、プログラミングモデルも並列性やデータの局所性、耐故障性の記述能力が不足しているという。

Office of ScienceのExascale Computing Initiative

このため、Office of Scienceは、2020+年にExascale Computingを実用化するための研究開発を行うExascale Computing Initiative(ECI)を推進している。具体的な実現戦略としては、R&Dの予算的なサポート、Exascaleのソフトウェアスタックの開発、メーカーの研究段階のテクノロジを製品化に結び付けるための開発資金の提供、Exascaleコンピュータの設計、開発の資金の提供、他の政府機関や外国との協力、そしてDoEのNNSAとのECIの作業の分担などを行う。

すでにテクノロジ開発を行うExascale Science Program(1番目の青い線)とハード、ソフトのコデザインを推進するExascale Co-Design Centers(3番目のオレンジの線)は開始されており、プロセサやメモリを開発するFast Forward(5番目の青い線)も開始され、システムインテグレーションのR&Dを行うDesign Forward(4番目の緑の線)も近く開始される予定である。そして、2014年半ばから、ECIの予算措置を行い、ソフトウェアテクノロジの開発(2番目の紫の線)、Fast Forwardに続くPath ForwardやDesign Forwardなどの開発を本格化する。

これらの開発作業と並行して2016年から2年ごとにシステムの調達を行い、2022年にはExascaleシステムを調達するという計画である。

最初のステップとして、コデザインに関しては、極限状況での物質の研究、先進的原子炉、燃焼という分野でExascaleシミュレーションを可能にするソフト、ハードのコデサインを研究する3つのセンターがすでに活動を始めている。

ソフトウェアの研究としては、スケーラビリティやエネルギー効率、耐故障性などの問題を解決するためX-Stackプログラムを推進しており、新しいプログラミングモデル、ダイナミックなランタイムシステム、データを局所化しデータ移動のエネルギーを減らす戦略、ソフトウェアのインターオペラビリティなどの研究を行っている。

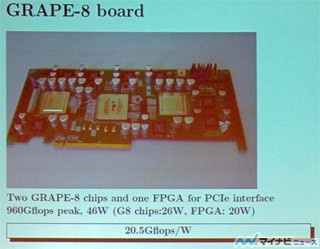

また、Fast Forwardプロジェクトは、現在は研究段階にあるプロセサ、メモリ、ストレージのテクノロジの実用化を行う2年間のプロジェクトであり、AMDがプロセサ、IBMがメモリ、Intelがプロセサとメモリ、NVIDIAがプロセサ、現在は買収されてIntelの一部になっているWham CloudがストレージとI/Oテクノロジの商用化を行う。このプロジェクトの予算総額は約62Mドルとなっている。

一方、Design Forwardプロジェクトは、まだ、研究機関やメーカーへの提案要請が出ていない状況であるという。

|

|

|

Fast Forwardでは研究段階のプロセサ、メモリ、ストレージのテクノロジの商用化を推進する |

Fast ForwardではAMD、IBM、Intel、NVIDIA、Wham Cloudの5社のプロジェクトに合計$62Mの予算が付いている |

しかし、Exascale Computingの実現は容易なことではなく、(1)スケーラブルでエネルギー効率が高く、プログラムが容易と言う新しいパラダイムの開発、(2)平均20pJのエネルギーで1命令を実行、(3)スパコン業界が経済的に成り立つようにする。という3つの奇蹟を起こす必要があるという。

このような困難のもかかわらず、結論は非常に前向きで、Extreme Scienceを実現するExascale Computingを実現する千載一遇の好機であり、将来のコンピューティングの新しい方向性を打ち立てようという努力が始まっている。そしてStar WarsのLukeとYodaの会話を引用して、トライしてみるという中途半端な話はなく、やるかやらないかだ。我々はすでにエキサイティングなスタートを切っていると結んだ。